Sztuczna inteligencja przeżywa prawdziwy boom, a wraz z nim dynamicznie rośnie zapotrzebowanie na energię potrzebną do zasilania jej infrastruktury. Centra danych, w których trenowane są i działają modele AI, stają się jednymi z największych nowych odbiorców energii elektrycznej na świecie. W latach 2024-2025 odnotowano rekordowe inwestycje w centra danych – szacuje się, że w samym 2025 roku globalnie wydano aż 580 mld USD na infrastrukturę centrów danych pod kątem AI. To przełożyło się na gwałtowny wzrost zużycia prądu w skali globalnej i lokalnej, stawiając przed branżą IT i energetyczną szereg wyzwań. Poniżej podsumowujemy twarde dane, statystyki i trendy z lat 2024-2025 oraz prognozy na 2026 rok, koncentrując się na zużyciu energii przez centra danych (zarówno trenowanie modeli AI, jak i ich proces wnioskowania), wpływie tego zjawiska na sektor energetyczny (miks energetyczny, OZE) oraz kluczowych decyzjach, przed jakimi stoją menedżerowie wdrażający AI.

1. Boom AI a rosnące zużycie energii w centrach danych (2024-2025)

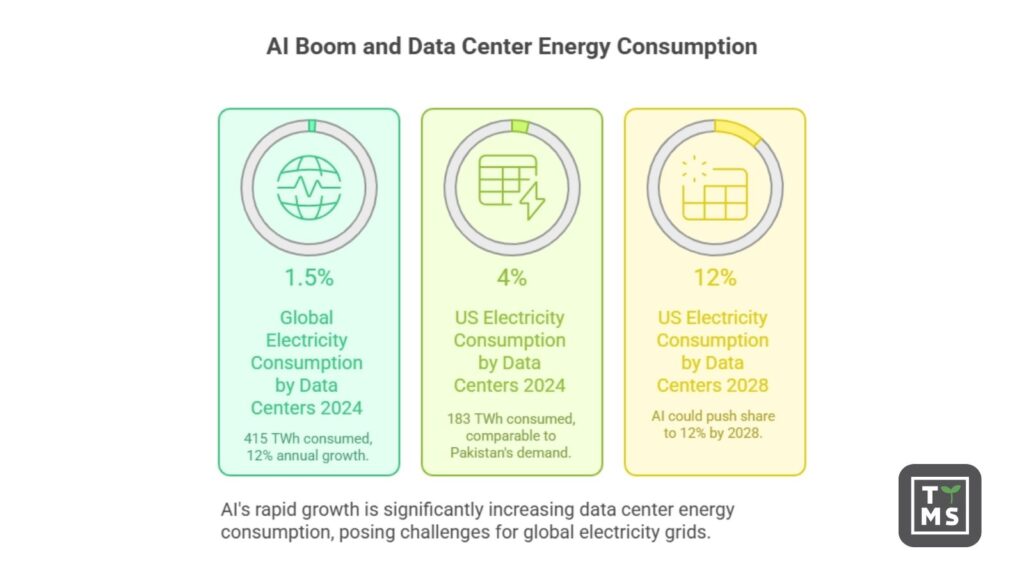

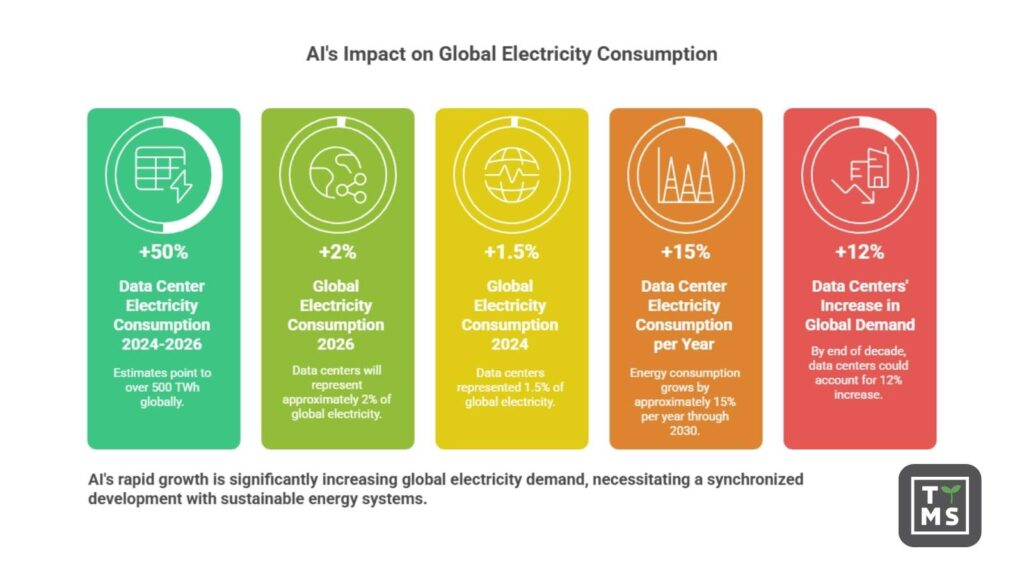

Rozwój generatywnej AI i dużych modeli językowych spowodował eksplozję zapotrzebowania na moc obliczeniową. Firmy technologiczne inwestują miliardy w rozbudowę centrów danych naszpikowanych procesorami graficznymi (GPU) i innymi akceleratorami AI. W efekcie globalne zużycie prądu przez centra danych osiągnęło w 2024 roku około 415 TWh, co stanowi już ok. 1,5% całej światowej konsumpcji energii elektrycznej. W samych Stanach Zjednoczonych centra danych zużyły w 2024 roku ok. 183 TWh, czyli ponad 4% krajowego zużycia prądu – to porównywalne z rocznym zapotrzebowaniem całego Pakistanu. Tempo wzrostu jest ogromne – globalnie konsumpcja energii przez centra danych rosła o ok. 12% rocznie w ostatnich pięciu latach, a boom AI dodatkowo ten wzrost przyspiesza.

Już w 2023-2024 dało się zauważyć wpływ AI na rozbudowę infrastruktury: moc zainstalowana nowo budowanych centrów danych w samej Ameryce Północnej pod koniec 2024 r. wynosiła 6350 MW, ponad dwa razy więcej niż rok wcześniej. Przeciętne duże centrum danych nastawione na AI zużywa tyle prądu co 100 000 gospodarstw domowych, a największe, powstające obecnie obiekty mogą potrzebować 20 razy więcej. Nic dziwnego, że całkowite zużycie energii przez centra danych w USA osiągnęło już ponad 4% miksu – według analizy Departamentu Energii AI może wywindować ten udział nawet do 12% już w 2028 roku. W skali świata przewiduje się natomiast, że do 2030 r. zużycie energii przez centra danych się podwoi, zbliżając się do 945 TWh (IEA, scenariusz bazowy). To poziom równy obecnemu zapotrzebowaniu całej Japonii.

2. Trenowanie vs. inferencja – gdzie AI zużywa najwięcej prądu?

W kontekście AI warto rozróżnić dwa główne rodzaje obciążenia centrów danych: trenowanie modeli oraz ich inferencję (wnioskowanie), czyli działanie modelu obsługujące zapytania użytkowników. Trenowanie najnowocześniejszych modeli jest niezwykle energochłonne – dla przykładu wytrenowanie jednego z największych modeli językowych w 2023 roku pochłonęło ok. 50 GWh energii, co odpowiada trzem dniom zasilania całego San Francisco. Inny raport rządowy oszacował moc wymaganą do trenowania czołowego modelu AI na 25 MW, przy czym stwierdzono, że z roku na rok potrzeby mocy do treningu mogą się podwajać. Te liczby obrazują skalę – pojedyncza sesja treningowa dużego modelu zużywa tyle energii, co tysiące przeciętnych gospodarstw domowych w ciągu roku.

Z kolei inferencja (czyli wykorzystanie wytrenowanego modelu do udzielania odpowiedzi, generowania obrazów, itp.) odbywa się na masową skalę w wielu aplikacjach jednocześnie. Choć pojedyncze zapytanie do modelu AI zużywa ułamek energii potrzebnej do treningu, to w skali globalnej to właśnie inferencja odpowiada za 80-90% całkowitego zużycia energii przez AI. Dla zobrazowania: jedno pytanie zadane chatbotowi pokroju ChatGPT może pochłaniać nawet 10 razy więcej energii niż wyszukanie hasła w Google. Gdy miliardy takich zapytań płyną każdego dnia, sumaryczny koszt energetyczny wnioskowania zaczyna przewyższać koszty jednorazowych treningów. Innymi słowy – AI “w akcji” (production) zużywa już więcej prądu niż AI “w szkoleniu”, co ma istotne konsekwencje dla planowania infrastruktury.

Inżynierowie i naukowcy próbują łagodzić ten trend poprzez optymalizację modeli i sprzętu. W ostatniej dekadzie efektywność energetyczna chipów AI znacząco wzrosła – GPU potrafią dziś wykonać 100 razy więcej obliczeń na wat energii niż w 2008 r. Mimo tych usprawnień rosnąca złożoność modeli i ich powszechne wykorzystanie sprawiają, że całkowity pobór mocy rośnie szybciej niż zyski z efektywności. Czołowe firmy odnotowują wręcz ponad 100% wzrost zapotrzebowania na moc obliczeniową AI rok do roku, co przekłada się wprost na większe zużycie prądu.

3. Wpływ AI na sektor energetyczny i miks źródeł energii

Rosnące zapotrzebowanie centrów danych na energię stawia wyzwania przed sektorem energetycznym. Duże, energochłonne serwerownie mogą lokalnie obciążać sieci elektroenergetyczne, wymuszając rozbudowę infrastruktury i nowych mocy wytwórczych. W 2023 roku w stanie Wirginia (USA) centra danych zużyły aż 26% całej energii elektrycznej w tym stanie. Podobnie wysokie udziały odnotowano m.in. w Irlandii – 21% krajowej konsumpcji prądu w 2022 przypadło na centra danych, a prognozy mówią nawet o 32% udziału do 2026 r.. Tak duża koncentracja odbioru energii w jednym sektorze powoduje konieczność modernizacji sieci przesyłowych i zwiększania rezerw mocy. Operatorzy sieci i lokalne władze alarmują, że bez inwestycji może dochodzić do przeciążeń, a koszty rozbudowy przenoszone są na odbiorców. W regionie PJM w USA (obszar kilku stanów) szacuje się, że zapewnienie mocy dla nowych centrów danych podniosło koszty rynku energii o 9,3 mld USD, co przełoży się na dodatkowe ~$18 miesięcznie na rachunku gospodarstw domowych w niektórych regionach USA.

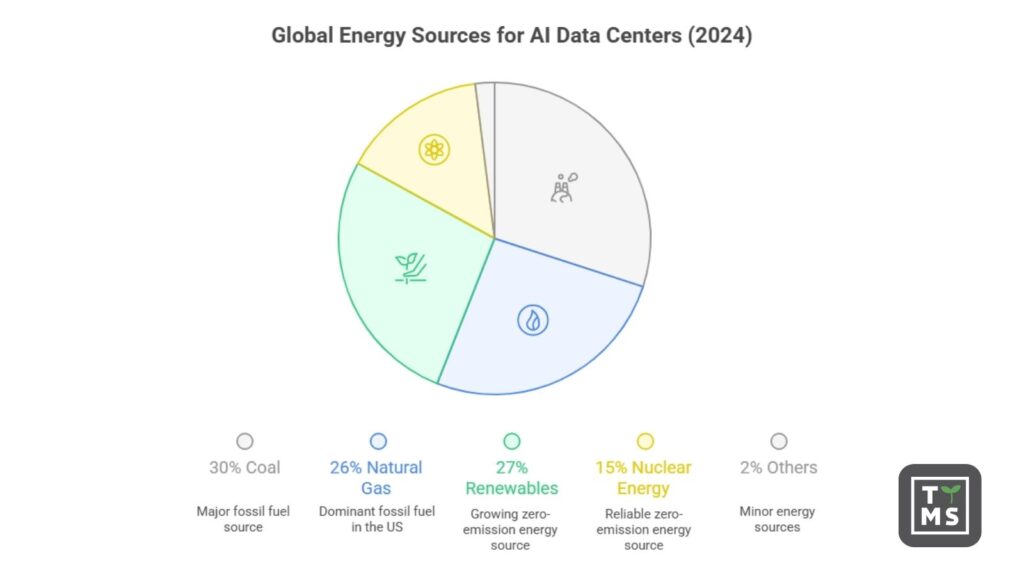

Skąd pochodzi energia zasilająca centra danych AI? Obecnie znaczna część prądu pochodzi z tradycyjnych paliw kopalnych. W ujęciu globalnym około 56% energii zużywanej przez centra danych pochodzi z paliw kopalnych (węgiel ok. 30%, gaz ziemny ok. 26%), a reszta ze źródeł bezemisyjnych – odnawialnych (27%) i energii jądrowej (15%). W USA dominował w 2024 gaz (ponad 40%), przy ok. 24% udziału OZE, 20% atomu i 15% węgla. Taki miks ma jednak ulegać zmianie pod wpływem dwóch czynników: ambitnych celów klimatycznych firm technologicznych oraz dostępności taniej energii odnawialnej.

Najwięksi gracze (Google, Microsoft, Amazon, Meta) ogłosili plany neutralności emisyjnej – np. Google i Microsoft chcą osiągnąć zerową emisję netto do 2030. To wymusza radykalne zmiany w zasilaniu centrów danych. Już teraz OZE są najszybciej rosnącym źródłem energii dla centrów danych – według IEA produkcja energii odnawialnej na potrzeby centrów rośnie średnio o 22% rocznie i pokryje blisko połowę dodatkowego zapotrzebowania do 2030. Tech-giganci masowo inwestują w farmy wiatrowe i fotowoltaiczne oraz podpisują umowy PPA na dostawy zielonej energii. Od początku 2025 roku czołowe firmy AI zawarły co najmniej kilkanaście dużych kontraktów na energię słoneczną, z których każdy doda ponad 100 MW mocy dla ich centrów danych. Podobnie rozwijane są projekty wiatrowe – np. centrum danych Microsoft w Wyoming jest w całości zasilane energią wiatrową, a Google kupuje energię z farm wiatrowych dla swoich serwerowni w Belgii.

Energia jądrowa wraca do łask jako stabilne źródło zasilania dla AI. Kilka stanów USA planuje reaktywację zamkniętych elektrowni atomowych specjalnie na potrzeby centrów danych – trwają przygotowania do ponownego uruchomienia reaktorów Three Mile Island (Pennsylvania) i Duane Arnold (Iowa) do 2028 roku, we współpracy z Microsoft i Google. Ponadto firmy technologiczne zainwestowały w rozwój małych reaktorów modułowych (SMR) – Amazon wsparł startup X-Energy, Google zakupił 500 MW mocy w SMR firmy Kairos, a operator centrów Switch zamówił energię z reaktora Oklo wspieranego przez OpenAI. SMRy mają zacząć działać po 2030 r., ale już teraz najwięksi globalni dostawcy chmury zabezpieczają dla siebie przyszłe dostawy z tych bezemisyjnych źródeł.

Mimo wzrostu udziału OZE i atomu, w najbliższych latach gaz ziemny i węgiel pozostaną istotne dla pokrycia skokowego popytu ze strony AI. IEA przewiduje, że do 2030 ok. 40% dodatkowego zużycia energii przez centra danych będzie nadal zaspokajane ze źródeł gazowych i węglowych. W niektórych krajach (np. Chiny, części Azji) węgiel nadal dominuje miks zasilania centrów danych. To rodzi wyzwania klimatyczne – analizy wskazują, że choć obecnie centra danych odpowiadają tylko za ~0,5% globalnych emisji CO₂, to jako jeden z nielicznych sektorów ich emisje wciąż rosną, podczas gdy wiele innych sektorów będzie się dekarbonizować. Pojawiają się głosy ostrzegające, że ekspansja energochłonnej AI może utrudnić osiąganie celów klimatycznych, jeśli nie zostanie zrównoważona czystą energią.

4. Prognoza na 2026 rok: dalszy wzrost zapotrzebowania

W perspektywie 2026 roku oczekuje się dalszego szybkiego wzrostu zużycia energii przez sztuczną inteligencję. Jeśli obecne trendy się utrzymają, centra danych będą zużywać w 2026 wyraźnie więcej niż w 2024 – szacunki wskazują na poziom ponad 500 TWh globalnie, co stanowiłoby ok. 2% światowego zużycia prądu (w porównaniu do 1,5% w 2024). Tylko w latach 2024-2026 sektor AI może wygenerować dodatkowy popyt rzędu setek TWh. Międzynarodowa Agencja Energetyczna podkreśla, że AI jest najważniejszym czynnikiem napędzającym wzrost zapotrzebowania centrów danych i jednym z kluczowych nowych odbiorców energii w skali globalnej. W scenariuszu bazowym IEA, przy założeniu dalszych usprawnień efektywności, zużycie energii przez centra danych rośnie ~15% rocznie do 2030. Gdyby jednak boom AI przyspieszył (więcej modeli, użytkowników, wdrożeń w różnych branżach), wzrost ten mógłby być jeszcze szybszy. Istnieją scenariusze, w których już pod koniec dekady centra danych mogłyby odpowiadać za nawet 12% przyrostu globalnego zapotrzebowania na prąd.

Rok 2026 prawdopodobnie przyniesie dalsze inwestycje w infrastrukturę AI. Wielu dostawców chmury i kolokacji ma zaplanowane otwarcie nowych kampusów centrów danych w ciągu najbliższych 1-2 lat, aby sprostać popytowi. Rządy i regiony aktywnie konkurują o lokalizacje takich obiektów, oferując ulgi i przyspieszone pozwolenia inwestorom, co obserwowaliśmy już w 2024-25. Z drugiej strony, rośnie świadomość ekologiczna – możliwe więc, że w 2026 pojawią się bardziej rygorystyczne regulacje. Niektóre państwa i stany debatują nad wymogami, by centra danych korzystały w części z OZE lub raportowały swój ślad węglowy i zużycie wody. Niewykluczone są także lokalne moratoria na budowę kolejnych energochłonnych serwerowni, jeśli sieć nie będzie w stanie ich obsłużyć – takie pomysły wysuwano już w rejonach o dużej koncentracji centrów (np. północna Wirginia).

Pod względem technologii rok 2026 może przynieść kolejne generacje bardziej energooszczędnych układów AI (np. nowe GPU/TPU) oraz popularyzację inicjatyw Green AI dążących do optymalizacji modeli pod kątem mniejszego zużycia mocy. Jednak biorąc pod uwagę skalę popytu, całkowite zużycie energii przez AI niemal na pewno będzie dalej rosło – pytanie tylko jak szybko. Kierunek jest jasny: branża musi synchronizować rozwój AI z rozwojem zrównoważonej energetyki, aby uniknąć konfliktu między ambicjami technologicznymi a celami klimatycznymi.

5. Wyzwania dla firm: koszty energii, zrównoważony rozwój i strategia IT

Dynamiczny wzrost zapotrzebowania na energię przez AI stawia menedżerów i dyrektorów przed kilkoma kluczowymi decyzjami strategicznymi:

- Rosnące koszty energii: Większe zużycie prądu oznacza wyższe rachunki. Firmy wdrażające AI na dużą skalę muszą uwzględniać w budżetach znaczące wydatki na energię. Prognozy wskazują, że bez zmian efektywności koszty zasilania mogą pochłaniać coraz większą część wydatków IT. Przykładowo, w USA ekspansja centrów danych może do 2030 podnieść średnie rachunki za prąd gospodarstw domowych o 8%, a w najbardziej obciążonych regionach nawet o 25%. Dla firm oznacza to presję na optymalizację zużycia – czy to poprzez poprawę efektywności (lepsze chłodzenie, niższy PUE), czy przenoszenie obliczeń do regionów z tańszą energią.

- Zrównoważony rozwój i emisje CO₂: Korporacyjne cele ESG wymuszają na liderach technologicznych dążenie do neutralności klimatycznej, co jest trudne przy gwałtownie rosnącym zużyciu energii. Wielkie koncerny jak Google czy Meta już zauważyły, że rozbudowa infrastruktury AI spowodowała skok ich emisji CO₂ pomimo wcześniejszych redukcji. Menedżerowie muszą więc inwestować w kompensację emisji i czyste źródła energii. Staje się normą, że firmy zawierają długoterminowe kontrakty na energię z OZE lub nawet inwestują bezpośrednio w farmy słoneczne, wiatrowe czy projekty jądrowe, aby zabezpieczyć zieloną energię dla swoich centrów danych. Pojawia się także trend wykorzystania alternatywnych źródeł – testy z zasilaniem serwerowni wodorem, geotermią czy eksperymentalną fuzją jądrową (np. kontrakt Microsoftu na 50 MW z przyszłej elektrowni fuzyjnej Helion Energy) – to wszystko element strategii dywersyfikacji i dekarbonizacji zasilania.

- Wybory architektury IT i efektywność: Decydenci IT stoją przed dylematem, jak dostarczyć moc obliczeniową dla AI w sposób najbardziej efektywny. Opcji jest kilka – od optymalizacji samych modeli (np. mniejsze modele, kompresja, inteligentniejsze algorytmy) po specjalizowany sprzęt (układy ASIC, nowe generacje TPU, pamięci optyczne itp.). Ważny jest też wybór modelu wdrożenia: chmura vs on-premises. Duzi dostawcy chmurowi często oferują centra danych o bardzo wysokiej efektywności energetycznej (PUE bliskie 1.1) oraz możliwość dynamicznego skalowania obciążenia, co poprawia wykorzystanie sprzętu i redukuje marnotrawstwo energii. Z drugiej strony, firmy mogą rozważać własne centra danych ulokowane tam, gdzie energia jest tańsza lub dostępna z OZE (np. w regionach o nadwyżkach energii odnawialnej). Strategia rozmieszczenia obciążeń AI – czyli które zadania obliczeniowe wykonywać w którym regionie i kiedy – staje się nowym obszarem optymalizacji kosztowej. Przykładowo, przenoszenie części zadań do centrów danych działających nocą na energii wiatrowej lub w chłodniejszym klimacie (niższe koszty chłodzenia) może przynieść oszczędności.

- Ryzyko reputacyjne i regulacyjne: Społeczna świadomość śladu energetycznego AI rośnie. Firmy muszą liczyć się z pytaniami inwestorów i opinii publicznej o to, jak “zielona” jest ich sztuczna inteligencja. Brak działań na rzecz zrównoważonego rozwoju może skutkować reputacyjnym uszczerbkiem, szczególnie gdy konkurenci będą mogli pochwalić się neutralnością węglową usług AI. Ponadto można spodziewać się nowych regulacji – od obowiązku ujawniania zużycia energii i wody przez centra danych, po normy efektywności czy limity emisyjne. Menedżerowie powinni proaktywnie śledzić te regulacje i angażować się w inicjatywy samoregulacji branży, aby uniknąć nagłych obostrzeń prawnych.

Podsumowując, rosnące potrzeby energetyczne AI to zjawisko, które w latach 2024-2026 z mało zauważalnej ciekawostki urosło do rangi strategicznego wyzwania zarówno dla sektora IT, jak i energetyki. Twarde dane pokazują wykładniczy wzrost zużycia prądu – AI staje się znaczącym konsumentem energii na świecie. Odpowiedzią na ten trend musi być innowacja i planowanie: rozwój bardziej efektywnych technologii, inwestycje w czystą energię oraz mądre strategie zarządzania obciążeniem. Przed liderami stoi zadanie znalezienia równowagi między napędzaniem rewolucji AI a odpowiedzialnym gospodarowaniem energią – tak, by sztuczna inteligencja napędzała postęp, nie przeciążając planety.

6. Czy Twoja architektura AI jest gotowa na rosnące koszty energii i infrastruktury?

AI nie jest już wyłącznie decyzją technologiczną – to decyzja infrastrukturalna, kosztowa i energetyczna. W TTMS pomagamy dużym organizacjom ocenić, czy ich architektury AI i chmurowe są gotowe na skalę produkcyjną, uwzględniając rosnące zapotrzebowanie na energię, kontrolę kosztów oraz długoterminową zrównoważoność. Jeśli Twoje zespoły przechodzą od pilotażowych wdrożeń AI do rozwiązań produkcyjnych, to właściwy moment, aby zweryfikować architekturę, zanim ograniczenia energetyczne i infrastrukturalne staną się realnym ryzykiem biznesowym.

Dowiedz się, jak TTMS wspiera przedsiębiorstwa w projektowaniu skalowalnych, efektywnych kosztowo i gotowych do produkcji architektur AI – porozmawiaj z naszymi ekspertami.

Dlaczego AI tak gwałtownie zwiększa zużycie energii w centrach danych?

Sztuczna inteligencja znacząco zwiększa zużycie energii, ponieważ opiera się na niezwykle zasobożernych obciążeniach obliczeniowych, w szczególności na inferencji działającej w trybie ciągłym w środowiskach produkcyjnych. W przeciwieństwie do tradycyjnych aplikacji enterprise, systemy AI często pracują 24/7, przetwarzają ogromne wolumeny danych i wymagają wyspecjalizowanego sprzętu, takiego jak GPU oraz akceleratory AI, które zużywają znacznie więcej energii na pojedynczą szafę serwerową. Choć trenowanie modeli jest bardzo energochłonne, to dziś właśnie inferencja w skali odpowiada za większość zużycia energii przez AI. Wraz z osadzaniem AI w codziennych procesach biznesowych zapotrzebowanie na energię ma charakter strukturalny, a nie chwilowy, co czyni energię elektryczną kluczowym zasobem organizacji opartych na AI.

Jak rosnące zapotrzebowanie energetyczne AI wpływa na lokalizację centrów danych i strategię chmurową?

Dostępność energii, przepustowość sieci elektroenergetycznej oraz ceny prądu stają się kluczowymi czynnikami przy wyborze lokalizacji centrów danych. Regiony o ograniczonej infrastrukturze energetycznej lub wysokich kosztach energii mogą mieć trudności z obsługą dużych wdrożeń AI, podczas gdy obszary z dostępem do taniej energii odnawialnej lub stabilnych źródeł bazowych zyskują na znaczeniu strategicznym. Bezpośrednio wpływa to na strategię chmurową firm, które coraz częściej analizują nie tylko to, jak uruchamiają obciążenia AI, ale również gdzie je uruchamiają. Architektury hybrydowe i wieloregionowe są dziś wykorzystywane nie tylko ze względów odporności i zgodności regulacyjnej, lecz także do optymalizacji kosztów energii, śladu węglowego i długoterminowej skalowalności.

Czy koszty energii realnie wpłyną na opłacalność inwestycji w AI?

Tak. Koszty energii coraz częściej stają się istotnym składnikiem całkowitego zwrotu z inwestycji w AI. Wraz ze skalowaniem obciążeń AI zużycie energii może dorównywać lub przewyższać tradycyjne koszty infrastrukturalne, takie jak amortyzacja sprzętu czy licencje oprogramowania. W regionach, w których szybko rośnie liczba centrów danych, dodatkowym czynnikiem są rosnące ceny energii oraz koszty rozbudowy sieci elektroenergetycznych. Organizacje, które nie uwzględnią realistycznie zużycia energii w swoich modelach finansowych, ryzykują poważne niedoszacowanie rzeczywistych kosztów inicjatyw AI, co może prowadzić do błędnych decyzji strategicznych.

Czy odnawialne źródła energii są w stanie nadążyć za wzrostem zapotrzebowania generowanym przez AI?

Odnawialne źródła energii rozwijają się dynamicznie i odgrywają kluczową rolę w zasilaniu infrastruktury AI, jednak w krótkiej perspektywie prawdopodobnie nie będą w stanie w pełni zrównoważyć tempa wzrostu zapotrzebowania generowanego przez AI. Mimo intensywnych inwestycji firm technologicznych w farmy wiatrowe, fotowoltaikę oraz długoterminowe kontrakty PPA, tempo adopcji AI jest wyjątkowo szybkie. W rezultacie paliwa kopalne oraz energetyka jądrowa pozostaną elementem miksu energetycznego centrów danych co najmniej do końca dekady. Długoterminowa zrównoważoność będzie zależeć od równoległego rozwoju OZE, modernizacji sieci, magazynowania energii oraz dalszej poprawy efektywności energetycznej systemów AI.

Jakie decyzje strategiczne powinni dziś podejmować menedżerowie, aby przygotować się na ograniczenia energetyczne związane z AI?

Menedżerowie powinni traktować energię jako strategiczny zasób w kontekście AI, a nie jako drugorzędny koszt operacyjny. Oznacza to konieczność uwzględniania kosztów energii w biznesowych uzasadnieniach projektów AI, spójnego powiązania planów rozwoju AI z celami zrównoważonego rozwoju oraz oceny stabilności i dostępności energii w kluczowych regionach operacyjnych. Decyzje dotyczące wyboru dostawców chmury, rozmieszczenia obciążeń czy architektury sprzętowej powinny wprost uwzględniać efektywność energetyczną i długoterminowe bezpieczeństwo dostaw. Organizacje, które już dziś zintegrują strategię AI z polityką energetyczną i klimatyczną, będą w lepszej pozycji do skalowania AI w sposób odpowiedzialny, przewidywalny i konkurencyjny.