Przełom w wykrywaniu deepfake’ów: uniwersalny detektor osiąga 98% skuteczności

Wyobraź sobie, że budzisz się i widzisz wiralowe nagranie, na którym prezes Twojej firmy wygłasza szokujące oświadczenia – tyle że nigdy tego nie zrobił. Ten koszmar staje się coraz bardziej realny wraz z tym, jak deepfake’i (fałszywe nagrania wideo lub audio generowane przez sztuczną inteligencję) stają się coraz bardziej przekonujące. W odpowiedzi na to zagrożenie naukowcy zaprezentowali nowy, uniwersalny detektor deepfake’ów, który potrafi wychwycić materiały syntetyczne z bezprecedensową skutecznością 98%. To przełom, który pojawił się w idealnym momencie – w czasie, gdy firmy intensywnie poszukują sposobów na ochronę reputacji i zaufania w epoce, w której „zobaczyć” nie zawsze znaczy „uwierzyć”.

Nowe, potężne narzędzie oparte na sztucznej inteligencji analizuje nagrania i wykrywa subtelne oznaki manipulacji, pomagając firmom odróżniać autentyczne materiały od deepfake’ów. Najnowszy „uniwersalny” detektor działa wieloplatformowo – z niezwykłą precyzją identyfikuje zarówno fałszywe nagrania wideo, jak i syntetyczne pliki audio. To znaczący krok naprzód w walce z dezinformacją napędzaną przez AI.

Czym jest uniwersalny detektor deepfake’ów o skuteczności 98% i jak działa?

Nowo ogłoszony detektor deepfake’ów to system oparty na sztucznej inteligencji, zaprojektowany do rozpoznawania fałszywych treści wideo i audio praktycznie na każdej platformie. Opracowany przez zespół badaczy (m.in. z UC San Diego w sierpniu 2025 roku), stanowi ogromny krok naprzód w technologii wykrywania deepfake’ów. W przeciwieństwie do wcześniejszych narzędzi ograniczonych do określonych formatów, ten „uniwersalny” detektor radzi sobie zarówno z mową generowaną przez AI, jak i z manipulowanym materiałem wideo. Innymi słowy, potrafi wychwycić zarówno zsynchronizowane nagranie z podmienioną twarzą dyrektora, jak i podszywający się głos – w ramach jednego rozwiązania.

Pod maską detektor wykorzystuje zaawansowane techniki uczenia maszynowego do wykrywania subtelnych „odcisków palców”, które generatywna sztuczna inteligencja pozostawia na fałszywych treściach. Gdy obraz lub film powstaje dzięki AI, a nie prawdziwej kamerze, pojawiają się drobne nieregularności na poziomie pikseli i we wzorcach ruchu – niewidoczne dla ludzkiego oka. Sieć neuronowa detektora została wytrenowana, by rozpoznawać te anomalie w skali subpikselowej. Na przykład prawdziwe nagrania charakteryzują się naturalnymi korelacjami kolorów i szumem typowym dla sensorów kamer, podczas gdy klatki wygenerowane przez AI mogą zawierać charakterystyczne niespójności w fakturze czy oświetleniu. Skupiając się na tych ukrytych markerach, system potrafi odróżnić fałszywkę od autentyku bez konieczności opierania się na oczywistych błędach.

Co istotne, nowy detektor nie koncentruje się jedynie na twarzach czy wybranym fragmencie kadru – skanuje całe nagranie (tło, ruchy, przebieg fal dźwiękowych itd.), szukając elementów, które „nie pasują”. Wcześniejsze detektory często skupiały się na anomaliach twarzy (np. nienaturalnym mruganiu czy dziwnej strukturze skóry) i mogły zawieść, jeśli w kadrze nie było widocznej twarzy. Tymczasem model uniwersalny analizuje wiele obszarów każdej klatki i ich ciągłość w kolejnych ujęciach, wychwytując subtelne niespójności przestrzenne i czasowe, które wcześniejsze metody pomijały. To model oparty na transformatorach, który uczy się ogólnych wzorców odróżniających treści rzeczywiste od fałszywych, zamiast stosować wąskie triki. Ta szerokość podejścia sprawia, że jest „uniwersalny” – jak ujął to jeden z badaczy: „To jeden model, który radzi sobie ze wszystkimi scenariuszami… i właśnie to czyni go uniwersalnym”.

Dane treningowe i testy: jak zbudowano lepszego „łowcę fałszywek”

Osiągnięcie skuteczności 98% wymagało dostarczenia detektorowi ogromnego zestawu zarówno prawdziwych, jak i fałszywych materiałów. Badacze trenowali system na szerokiej gamie nagrań generowanych przez różne programy – od podmian twarzy po całkowicie stworzone przez AI klipy. Wykorzystali m.in. przykłady z takich narzędzi jak generator wideo Stable Diffusion, Video-Crafter czy CogVideo, aby nauczyć sztuczną inteligencję rozpoznawania różnych „odcisków” fałszywek. Dzięki temu model nie daje się zwieść tylko jednemu typowi deepfake’a. Co imponujące, zespół badawczy poinformował, że detektor potrafi dostosować się nawet do nowych metod deepfake po zobaczeniu zaledwie kilku przykładów. Oznacza to, że jeśli jutro pojawi się nowy generator wideo, narzędzie będzie w stanie szybko poznać jego charakterystyczne ślady bez konieczności pełnego przeuczenia.

Rezultaty testów były rekordowe. W badaniach detektor poprawnie oznaczał treści generowane przez AI w ok. 98,3% przypadków. To istotny skok skuteczności w porównaniu z wcześniejszymi narzędziami, które często miały problem z przekroczeniem 90%. Co więcej, badacze porównali swój model z ośmioma istniejącymi systemami wykrywania deepfake’ów i nowy detektor przewyższył wszystkie (inne osiągały wyniki na poziomie ok. 93% lub niżej). Tak wysoki współczynnik trafnych detekcji to przełom w wyścigu zbrojeń przeciwko deepfake’om. Pokazuje, że sztuczna inteligencja jest w stanie rozpoznać niemal każdą fałszywkę, niezależnie od jej źródła.

Oczywiście „98% skuteczności” to nie 100%, a pozostałe 2% ma znaczenie. Przy milionach filmów publikowanych codziennie nawet niewielki odsetek fałszywych negatywów oznacza, że część deepfake’ów umknie, a fałszywe pozytywy mogą prowadzić do błędnego oznaczenia autentycznych materiałów. Niemniej jednak, skuteczność tego detektora jest obecnie najlepsza w swojej klasie. Daje on organizacjom realną szansę na wychwycenie złośliwych fałszywek, które jeszcze rok czy dwa temu mogłyby przejść niezauważone. Wraz z rozwojem technologii generowania deepfake’ów narzędzia wykrywające musiały nadążyć – i ten system pokazuje, że możliwe jest znaczące zmniejszenie dystansu.

Czym ten detektor różni się od wcześniejszych metod wykrywania deepfake’ów?

Poprzednie metody wykrywania deepfake’ów były często wyspecjalizowane i łatwe do obejścia. Kluczowa różnica polega na szerokim zakresie działania nowego narzędzia. Starsze detektory skupiały się na pojedynczych artefaktach – np. nienaturalnych ruchach twarzy czy niezgodnościach oświetlenia. To działało przy pewnych typach deepfake’ów, ale zawodziło przy innych. Wiele klasycznych systemów traktowało nagranie jak zbiór pojedynczych obrazów i szukało śladów edycji w każdej klatce z osobna. Takie podejście nie sprawdza się w przypadku w pełni generowanego przez AI wideo, które nie nosi typowych śladów „cięć”. Tymczasem detektor o skuteczności 98% patrzy szerzej: analizuje wzorce w czasie i w całym kadrze, a nie tylko w pojedynczych obrazach.

Kolejnym przełomem jest zdolność obsługi różnych formatów i modalności. Starsze rozwiązania zazwyczaj wykrywały jeden typ treści – np. deepfake wideo z podmianą twarzy – ale były bezużyteczne wobec sklonowanego głosu w nagraniu audio. Nowy uniwersalny detektor radzi sobie zarówno z wideo, jak i audio w jednym systemie, co stanowi prawdziwą zmianę jakościową. Jeśli więc deepfake łączy fałszywy głos z prawdziwym obrazem albo odwrotnie, starsze detektory mogłyby tego nie wykryć – ten system natomiast rozpozna oszustwo w obu przypadkach.

Dodatkowo architektura tego detektora jest bardziej zaawansowana. Wykorzystuje on specjalnie skonstruowaną sieć neuronową, która wychwytuje anomalie w rozkładach danych, zamiast szukać z góry określonej listy błędów. Można porównać wcześniejsze metody do listy kontrolnej („Czy oczy mrugają normalnie? Czy widoczny jest puls na szyi?”) – skutecznej tylko do momentu, gdy twórcy deepfake’ów naprawią te niedoskonałości. Nowe podejście przypomina uniwersalny wykrywacz kłamstw dla mediów – uczy się podstawowych różnic między prawdziwą a fałszywą treścią, których fałszerzom trudniej się pozbyć. W przeciwieństwie do wielu wcześniejszych systemów mocno uzależnionych od obecności twarzy, ten model nie potrzebuje w kadrze człowieka. Jeśli ktoś sfabrykuje wideo pustego biura z fałszywymi szczegółami w tle, wcześniejsze detektory mogłyby niczego nie zauważyć. Uniwersalny system natomiast przeanalizuje faktury, cienie i ruch w scenie, by znaleźć nienaturalne elementy. Dzięki temu jest odporny na znacznie szersze spektrum stylów deepfake’ów.

Podsumowując, tym, co wyróżnia nowy detektor, jest jego uniwersalność i odporność. To w zasadzie jedno narzędzie, które obejmuje wiele zastosowań: podmianę twarzy, całkowicie syntetyczne nagrania wideo, fałszywe głosy i wiele innych. Poprzednie generacje detektorów były znacznie węższe – rozwiązywały tylko część problemu. Ten system łączy w sobie doświadczenia z wcześniejszych podejść, tworząc kompleksowe narzędzie. Ta szerokość ma kluczowe znaczenie, ponieważ techniki deepfake stale się rozwijają. Rozwiązując problemy z kompatybilnością międzyplatformową, które nękały wcześniejsze systemy, nowy detektor utrzymuje wysoką skuteczność nawet w obliczu coraz bardziej zróżnicowanych metod fałszowania. To różnica między zbiorem lokalnych czujników dymu a systemem przeciwpożarowym obejmującym cały budynek.

Dlaczego ma to znaczenie dla bezpieczeństwa marki i ryzyka reputacyjnego?

Dla biznesu deepfake’i to nie tylko problem działu IT – to poważne zagrożenie dla bezpieczeństwa marki i reputacji. Żyjemy w czasach, w których jedno zmanipulowane nagranie może błyskawicznie rozprzestrzenić się w sieci i zniszczyć wiarygodność firmy. Wyobraź sobie fałszywe wideo, na którym Twój prezes wygłasza nieetyczne uwagi, albo sfałszowane ogłoszenie o wycofaniu produktu z rynku – taka fałszywka mogłaby spowodować spadek kursu akcji i utratę klientów, zanim prawda wyszłaby na jaw. Niestety, to nie są już scenariusze hipotetyczne. Firmy stały się realnym celem przestępców wykorzystujących deepfake. W 2019 roku oszuści użyli klonowanego przez AI głosu prezesa, by nakłonić pracownika do przelania 243 tys. dolarów na fałszywe konto. W 2024 roku międzynarodowa korporacja w Hongkongu została oszukana jeszcze bardziej wyrafinowanym deepfake’iem – wideokonferencją z „prezesem” i „kolegami z zespołu”, co skończyło się stratą 25 mln dolarów. Liczba ataków z wykorzystaniem deepfake’ów gwałtownie rośnie, a firmy z sektora finansowego i inne tracą miliony, co stawia zespoły ds. bezpieczeństwa w stanie najwyższej gotowości.

Poza bezpośrednimi stratami finansowymi, deepfake’i stanowią też ogromne zagrożenie reputacyjne. Marki budują zaufanie przez lata, a jeden wiralowy fałszywy film może zburzyć je w kilka minut. W sieci pojawiały się już zmanipulowane nagrania polityków czy prezesów – nawet jeśli później zostają obalone, szkody w międzyczasie bywają poważne. Konsumenci mogą zacząć się zastanawiać: „Czy to było prawdziwe?” przy każdym szokującym materiale z udziałem Twojej firmy. Taka niepewność podkopuje fundament zaufania, na którym opiera się biznes. Dlatego właśnie tak ważne jest narzędzie detekcji o bardzo wysokiej skuteczności – daje firmom realną szansę na szybkie wykrycie i reakcję na fałszywe treści, zanim plotki i dezinformacja zaczną żyć własnym życiem.

Z perspektywy bezpieczeństwa marki posiadanie niemal niezawodnego detektora deepfake’ów działa jak radar wczesnego ostrzegania dla reputacji. Umożliwia weryfikację autentyczności podejrzanych nagrań audio lub wideo, w których pojawiają się Twoi menedżerowie, produkty czy partnerzy. Na przykład, gdyby na mediach społecznościowych pojawiło się zmanipulowane nagranie prezesa, detektor mógłby je oznaczyć w ciągu kilku chwil, dając zespołowi czas na poinformowanie platformy i opinii publicznej, że to fałszywka. To może być różnica między kontrolowanym incydentem a pełnowymiarowym kryzysem PR. W branżach takich jak finanse, media czy dobra konsumenckie, gdzie zaufanie jest kluczowe, taka szybka reakcja jest ratunkiem. Jak stwierdził jeden z raportów branżowych, tego typu narzędzie to „linia ratunkowa dla firm obawiających się o reputację, dezinformację i zaufanie cyfrowe”. Coraz częściej staje się ono niezbędne dla każdej organizacji, która może paść ofiarą nadużyć z użyciem syntetycznych treści.

Deepfake’i otworzyły także nowe kanały dla oszustw i dezinformacji, na które tradycyjne zabezpieczenia nie były przygotowane. Fałszywe wiadomości głosowe rzekomego prezesa z poleceniem przelewu pieniędzy albo zmanipulowane nagranie rzecznika firmy ogłaszającego fikcyjną fuzję mogą obejść intuicję wielu ludzi – ponieważ jesteśmy przyzwyczajeni ufać temu, co widzimy i słyszymy. Podszywanie się pod markę poprzez deepfake’i może wprowadzać klientów w błąd – np. fałszywe nagranie „ogłoszenia” mogłoby zwabić ludzi do fałszywej inwestycji czy schematu phishingowego, wykorzystując renomę firmy. Detektor o skuteczności 98%, wdrożony właściwie, działa jako tarcza przeciwko takim nadużyciom. Nie powstrzyma powstawania deepfake’ów (tak jak kamery nie powstrzymują przestępstw same w sobie), ale znacząco zwiększa szanse na ich wychwycenie na czas, aby ograniczyć szkody.

Włączanie wykrywania deepfake’ów do strategii biznesowych AI i cyberbezpieczeństwa

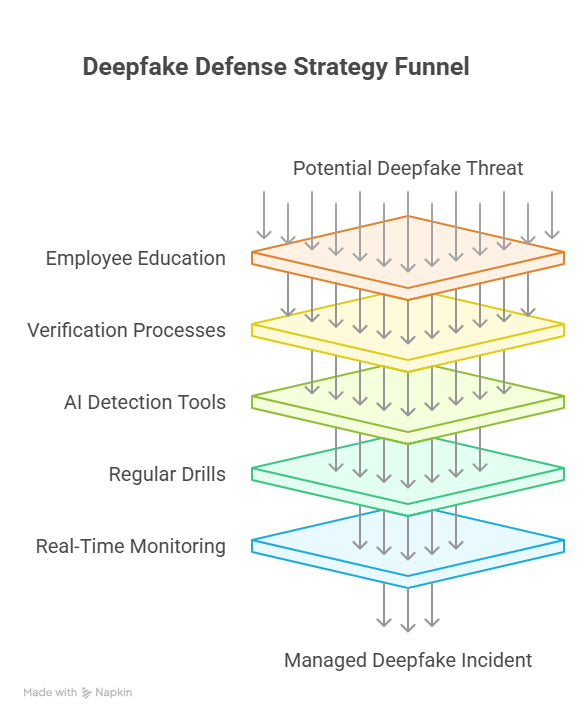

Mając na uwadze stawkę, firmy powinny proaktywnie włączać narzędzia do wykrywania deepfake’ów w swoje ramy bezpieczeństwa i zarządzania ryzykiem. Detektor nie jest już ciekawostką dla działu IT – szybko staje się równie ważny jak filtry antyspamowe czy oprogramowanie antywirusowe w świecie korporacyjnym. Oto kilka kluczowych kroków i zaleceń dla organizacji chcących chronić się przed zagrożeniami:

- Edukacja pracowników i polityki: Szkol pracowników na wszystkich poziomach, aby byli świadomi zagrożeń związanych z deepfake’ami i potrafili weryfikować wrażliwe komunikaty. Powinni podchodzić sceptycznie do wszelkich pilnych wiadomości głosowych czy nagrań wideo, które wydają się choć trochę podejrzane. Należy wprowadzić zasadę, że żadne istotne działania nie są podejmowane wyłącznie na podstawie komunikacji elektronicznej bez dodatkowej weryfikacji.

- Wzmocnienie procesów weryfikacyjnych: Stwórz solidne procedury zatwierdzania transakcji finansowych i komunikacji na szczeblu kierowniczym. Może to obejmować wieloskładnikowe uwierzytelnianie, hasła weryfikacyjne czy obowiązkowe „pauzy i sprawdzenie” przy nietypowych żądaniach. Już incydent z 2019 roku pokazał, że rozpoznanie głosu nie wystarcza do potwierdzenia tożsamości – tak samo należy traktować wideo i audio jak podejrzany e-mail.

- Wdrożenie narzędzi AI do wykrywania: Włącz technologię wykrywania deepfake’ów do swojego arsenału cyberbezpieczeństwa. Specjalistyczne oprogramowanie może analizować przychodzące treści (maile z załącznikami wideo, nagrania głosowe, filmy w mediach społecznościowych) i oznaczać potencjalne fałszywki. Zaawansowane systemy AI potrafią wychwycić subtelne niespójności, których człowiek nie zauważy. Wiele firm technologicznych oferuje już takie rozwiązania jako usługę.

- Regularne ćwiczenia i gotowość: Uaktualnij plan reagowania kryzysowego o scenariusze związane z deepfake’ami. Organizuj symulacje (np. nagłe „wystąpienie prezesa” jako deepfake), aby sprawdzić, jak zespół zareaguje. Tak jak firmy organizują ćwiczenia phishingowe, tak samo powinny trenować reakcje na deepfake’i.

- Monitorowanie i szybka reakcja: Przydziel pracowników lub skorzystaj z usług monitoringu, aby stale obserwować wzmianki o marce i kluczowych menedżerach w sieci. Jeśli pojawi się deepfake wymierzony w Twoją firmę, kluczowa jest błyskawiczna reakcja. Im szybciej potwierdzisz fałszywość materiału (przy pomocy AI) i zareagujesz publicznie, tym skuteczniej ograniczysz fałszywą narrację.

Wdrożenie tych działań sprawia, że ochrona przed deepfake’ami staje się zarówno techniczna, jak i ludzka. Żadne pojedyncze narzędzie nie jest cudownym rozwiązaniem – nawet detektor o skuteczności 98% działa najlepiej w połączeniu z dobrymi praktykami. Firmy, które przyjmują takie podejście, traktują ryzyko deepfake jako kwestię „kiedy”, a nie „czy”. Integrują wykrywanie deepfake’ów w swoje praktyki bezpieczeństwa i zgodności. Dzięki temu nie tylko chronią się przed oszustwami i stratami wizerunkowymi, ale też wzmacniają zaufanie interesariuszy. W świecie, w którym AI może podszyć się pod każdego, solidna strategia weryfikacji i detekcji staje się fundamentem zaufania cyfrowego.

Patrząc w przyszłość, można się spodziewać, że detektory deepfake’ów staną się standardowym elementem korporacyjnych systemów bezpieczeństwa. Tak jak filtry antyspamowe czy oprogramowanie antymalware stały się normą, tak samo uwierzytelnianie treści i skanowanie pod kątem deepfake’ów będzie rutyną. Najbardziej dalekowzroczne firmy już teraz badają możliwości integracji detektorów poprzez API z systemami wideokonferencji i pocztą e-mail. Inwestycja w te narzędzia jest nieporównanie tańsza niż koszt poważnego kryzysu wywołanego deepfake’iem. W obliczu rosnących zagrożeń przedsiębiorstwa muszą wyprzedzać cyberprzestępców – a detektor o skuteczności 98% to obiecane narzędzie, które im to umożliwia.

Chroń swoją firmę z rozwiązaniami AI od TTMS

W Transition Technologies MS (TTMS) pomagamy organizacjom wzmacniać ochronę przed zagrożeniami cyfrowymi, integrując najnowocześniejsze narzędzia AI ze strategiami cyberbezpieczeństwa. Od zaawansowanej analizy dokumentów, przez systemy zarządzania wiedzą, po platformy e-learningowe – nasze rozwiązania oparte na sztucznej inteligencji wspierają zaufanie, zgodność z regulacjami i odporność biznesu w erze cyfrowej. Współpracuj z TTMS, aby chronić reputację swojej marki i przygotować się na kolejne wyzwania związane z wykrywaniem deepfake’ów i nie tylko.

FAQ

Jak rozpoznać, czy film jest deepfake’iem, bez użycia specjalistycznych narzędzi?

Nawet bez użycia detektora opartego na sztucznej inteligencji można zauważyć pewne sygnały ostrzegawcze sugerujące, że nagranie jest deepfake’iem. Warto uważnie przyjrzeć się twarzy i ruchom postaci – we wcześniejszych deepfake’ach często występowało nienaturalne mruganie oczami lub grymasy twarzy, które „nie pasowały”. Należy zwrócić uwagę na spójność oświetlenia i cieni; zdarza się, że światło na twarzy nie zgadza się z resztą sceny. Również dźwięk może zdradzać fałszerstwo: niedokładna synchronizacja ruchu ust z mową lub głosy brzmiące sztucznie mogą wskazywać na manipulację. Pomocne bywa także zatrzymanie obrazu – zniekształcone lub rozmazane detale wokół krawędzi twarzy, zwłaszcza w momentach przejść, mogą sugerować, że coś jest nie tak. Trzeba jednak pamiętać, że współczesne deepfake’i są coraz trudniejsze do wykrycia gołym okiem, dlatego coraz większego znaczenia nabierają wyspecjalizowane narzędzia i systemy detekcji.

Czy istnieją przepisy prawne lub regulacje dotyczące deepfake’ów, o których firmy powinny wiedzieć?

Regulacje dotyczące deepfake’ów zaczynają stopniowo nadążać za rosnącym wpływem tej technologii. Różne jurysdykcje zaczęły wprowadzać przepisy mające na celu zniechęcenie do złośliwego wykorzystania deepfake’ów. Na przykład Chiny wprowadziły regulacje wymagające wyraźnego oznaczania treści generowanych przez AI (deepfake’ów) oraz zakazujące tworzenia takich materiałów, jeśli mogłyby one wprowadzać opinię publiczną w błąd lub szkodzić reputacji danej osoby. W Unii Europejskiej nadchodzący AI Act traktuje manipulacyjne treści generowane przez sztuczną inteligencję jako obszar wysokiego ryzyka i prawdopodobnie wprowadzi obowiązki transparentności – co oznacza, że firmy mogą być zobowiązane do ujawniania treści stworzonych przez AI i narażać się na kary za szkodliwe wykorzystanie deepfake’ów. W Stanach Zjednoczonych nie istnieje jeszcze ogólnokrajowe prawo federalne dotyczące deepfake’ów, ale część stanów już podjęła działania: Wirginia jako jedna z pierwszych uznała określone formy pornografii deepfake i podszywania się za przestępstwo, a Kalifornia i Teksas uchwaliły przepisy zakazujące używania deepfake’ów w wyborach. Dodatkowo obowiązujące już przepisy dotyczące oszustw, zniesławienia czy kradzieży tożsamości mogą znaleźć zastosowanie w kontekście deepfake’ów (na przykład wykorzystanie deepfake’a do popełnienia oszustwa nadal pozostaje oszustwem).

Dla firm ten krajobraz regulacyjny oznacza dwie rzeczy: po pierwsze, należy powstrzymywać się od nieetycznego wykorzystywania deepfake’ów w działalności i marketingu (aby uniknąć problemów prawnych i krytyki), a po drugie, trzeba być na bieżąco z rozwijającym się prawem chroniącym ofiary deepfake’ów – takie regulacje mogą pomóc Twojej firmie, jeśli kiedykolwiek zajdzie potrzeba podjęcia kroków prawnych przeciwko podmiotom tworzącym złośliwe fałszywki. Rozsądnie jest skonsultować się z ekspertami prawnymi, aby zrozumieć, jak przepisy dotyczące deepfake’ów w Twoim regionie mogą wpływać na zgodność działań i strategie reagowania.

Czy twórcy deepfake’ów wciąż mogą oszukać detektor o skuteczności 98%?

To trudne, ale nie niemożliwe. Detektor o skuteczności 98% to wynik znakomity, jednak zdeterminowani przeciwnicy zawsze będą szukać sposobów na obejście systemu. Badacze wykazali, że dodając specjalnie przygotowany „szum” lub artefakty (tzw. przykłady adwersarialne) do deepfake’a, można czasami oszukać modele detekcji. To klasyczna gra w kotka i myszkę: gdy detektory się udoskonalają, techniki tworzenia deepfake’ów stają się coraz bardziej podstępne. Trzeba jednak podkreślić, że oszukanie detektora z najwyższej półki wymaga ogromnej wiedzy i nakładu pracy – przeciętny deepfake krążący dziś w internecie raczej nie jest aż tak perfekcyjnie zamaskowany. Nowy, uniwersalny detektor znacząco podnosi poprzeczkę, co oznacza, że większość fałszywek zostanie wykryta. Można się jednak spodziewać, że twórcy deepfake’ów będą próbowali opracować metody przeciwdziałania, dlatego konieczne są dalsze badania i regularnie aktualizowane modele. Krótko mówiąc, 98% skuteczności nie oznacza całkowitej niezawodności, ale sprawia, że udane ataki deepfake stają się znacznie rzadsze.

Co powinna zrobić firma, jeśli deepfake przedstawiający jej prezesa lub markę trafi do opinii publicznej?

Zmierzając się z atakiem deepfake na firmę, należy działać szybko i ostrożnie. Najpierw wewnętrznie zweryfikuj materiał – użyj narzędzi detekcji (np. detektora o skuteczności 98%), aby potwierdzić, że to fałszywka, i jeśli to możliwe, zgromadź dowody dotyczące sposobu jej stworzenia. Natychmiast uruchom zespół reagowania kryzysowego, który zwykle obejmuje dział komunikacji, bezpieczeństwa IT, doradców prawnych oraz kadrę zarządzającą. Skontaktuj się z platformą, na której rozpowszechniane jest nagranie, i zgłoś je jako treść fałszywą – wiele serwisów społecznościowych i stron internetowych posiada regulacje przeciwko deepfake’om, szczególnie tym szkodliwym, i usuwa je po zgłoszeniu. Równolegle przygotuj publiczne oświadczenie lub komunikat prasowy dla interesariuszy. Bądź przejrzysty i stanowczy: poinformuj, że nagranie jest fałszywe i że ktoś próbuje wprowadzić opinię publiczną w błąd. Jeżeli deepfake może rodzić konsekwencje prawne (np. manipulację giełdową lub zniesławienie), zaangażuj odpowiednie organy ścigania lub regulatorów. W dalszej perspektywie przeprowadź analizę powłamaniową, aby ulepszyć plan reagowania na przyszłość. Dzięki szybkiej reakcji i klarownej komunikacji firma może często odwrócić sytuację i zapobiec trwałym szkodom wynikającym z incydentu z deepfake.

Czy narzędzia do wykrywania deepfake’ów są dostępne dla firm?

Tak – choć część najbardziej zaawansowanych detektorów wciąż znajduje się w fazie badań, już teraz istnieją narzędzia dostępne na rynku, z których firmy mogą korzystać. Wiele przedsiębiorstw z branży cyberbezpieczeństwa oraz startupów AI oferuje usługi wykrywania deepfake’ów, często zintegrowane z szerszymi platformami analizy zagrożeń. Niektóre udostępniają API lub oprogramowanie, które potrafi skanować nagrania wideo i audio w poszukiwaniu śladów manipulacji. Duże firmy technologiczne również inwestują w ten obszar – na przykład Facebook i YouTube opracowały wewnętrzne systemy wykrywania deepfake’ów do moderowania treści, a Microsoft kilka lat temu udostępnił narzędzie Video Authenticator. Ponadto istnieją projekty open source i modele opracowane przez laboratoria akademickie, które mogą być testowane przez bardziej zaawansowane technologicznie organizacje. Sam nowy „uniwersalny” detektor o skuteczności 98% może w przyszłości trafić na rynek komercyjny lub publiczny – wtedy firmy mogłyby go wdrażać podobnie jak oprogramowanie antywirusowe. Warto jednak pamiętać, że skuteczne korzystanie z tych narzędzi wymaga także nadzoru człowieka. Organizacje powinny wyznaczyć odpowiednio przeszkolonych pracowników lub współpracować z dostawcami, aby właściwie wdrożyć detektory i interpretować wyniki. Podsumowując: choć nie ma jeszcze rozwiązania idealnego „z półki”, dostępnych jest coraz więcej opcji wykrywania deepfake’ów, a ich rozwój postępuje bardzo szybko.