Wraz z rosnącym znaczeniem sztucznej inteligencji w działalności biznesów, firmy coraz mocniej koncentrują się na odpowiedzialnym podejściu do AI, starając się, by systemy AI były etyczne, przejrzyste i podlegały kontroli. Dynamiczny rozwój narzędzi generatywnej AI, takich jak ChatGPT, przynosi nowe wyzwania dla przedsiębiorstw. Pracownicy mogą dziś korzystać z chatbotów AI do tworzenia treści czy analizy danych – ale bez odpowiedniego nadzoru może to prowadzić do poważnych problemów. W jednym z głośnych przypadków czołowa firma technologiczna zakazała korzystania z ChatGPT po tym, jak pracownik nieświadomie ujawnił przez czat fragmenty wrażliwego kodu źródłowego. Tego typu incydenty pokazują, dlaczego firmy potrzebują solidnych ram zarządzania AI. Dzięki jasnym zasadom, ścieżkom audytu i wytycznym etycznym organizacje mogą korzystać z potencjału AI, jednocześnie ograniczając ryzyko. W tym artykule przedstawiamy, jak zbudować takie ramy (szczególnie w kontekście dużych modeli językowych jak ChatGPT) – omawiamy nowe standardy audytu i dokumentacji, rolę rad ds. etyki AI, konkretne kroki wdrożeniowe oraz odpowiedzi na najczęstsze pytania liderów biznesu.

1. Czym są ramy zarządzania AI?

Zarządzanie AI oznacza zestaw standardów, procesów i mechanizmów ochronnych, które zapewniają odpowiedzialne wykorzystywanie sztucznej inteligencji – zgodnie z wartościami organizacji. Ramy governance definiują, jak firma będzie zarządzać ryzykiem i etyką związaną z systemami AI przez cały ich cykl życia. Obejmuje to zasady korzystania z danych, rozwój modeli, ich wdrażanie i bieżący monitoring. Governance AI często pokrywa się z zarządzaniem danymi – np. w zakresie jakości danych treningowych, braku stronniczości i zgodności z przepisami o prywatności. Dobrze zdefiniowane ramy zapewniają, że inicjatywy AI są z natury sprawiedliwe, przejrzyste i podlegają odpowiedzialności. W praktyce oznacza to określenie zasad (np. sprawiedliwość, prywatność, niezawodność), przypisanie ról i obowiązków nadzorczych oraz wdrożenie procesów dokumentowania i audytu systemów AI. Dzięki temu organizacje mogą budować godne zaufania systemy AI, na których mogą polegać zarówno użytkownicy, jak i interesariusze.

2. Dlaczego firmy potrzebują governance dla ChatGPT?

Wdrażanie narzędzi takich jak ChatGPT bez nadzoru to ryzyko. Generatywne modele AI są potężne, ale nieprzewidywalne – ChatGPT może generować błędne lub stronnicze odpowiedzi (halucynacje), które brzmią przekonująco. W codziennym użyciu to może nie mieć większych konsekwencji, ale w kontekście biznesowym może wprowadzić w błąd decydentów lub klientów. Co więcej, jeśli pracownicy nieświadomie wprowadzą poufne dane do ChatGPT, informacje te mogą zostać zapisane poza systemami firmy – co rodzi zagrożenie dla bezpieczeństwa i zgodności z przepisami. Dlatego duże banki i firmy technologiczne często wstrzymują lub ograniczają korzystanie z AI do czasu opracowania odpowiednich polityk.

Poza kwestiami dokładności treści i wycieku danych, istnieją też szersze zagrożenia: etyczne uprzedzenia, brak przejrzystości decyzji AI i ryzyko naruszenia przepisów. Bez governance firma może wdrożyć AI, która nieumyślnie dyskryminuje (np. w procesach rekrutacyjnych lub przy decyzjach kredytowych) lub narusza przepisy jak RODO. Koszty porażek AI mogą być ogromne – od sankcji prawnych po utratę reputacji.

Z drugiej strony, wdrożenie odpowiedzialnych ram zarządzania AI znacząco ogranicza te ryzyka. Pozwala firmom wcześnie identyfikować i naprawiać problemy, takie jak uprzedzenia w danych czy luki w bezpieczeństwie. Przykładowo, działania takie jak regularne audyty sprawiedliwości pomagają zmniejszyć ryzyko dyskryminujących rezultatów. Przeglądy bezpieczeństwa i zabezpieczenia danych chronią przed ujawnieniem wrażliwych informacji. Dobrze prowadzona dokumentacja i testy zwiększają przejrzystość systemów AI, które przestają być „czarną skrzynką” – co buduje zaufanie użytkowników i regulatorów. Jasne określenie odpowiedzialności (kto nadzoruje i odpowiada za decyzje AI) oznacza, że w razie problemów organizacja może szybko zareagować i pozostać w zgodzie z przepisami. Krótko mówiąc, governance nie ogranicza innowacji – przeciwnie, umożliwia bezpieczne i skuteczne wykorzystanie AI. Dzięki ustalonym zasadom firmy mogą z pełnym przekonaniem wdrażać narzędzia takie jak ChatGPT, zwiększając produktywność i jednocześnie zachowując kontrolę oraz zgodność z polityką i wartościami organizacji.

3. Kluczowe elementy odpowiedzialnych ram zarządzania AI

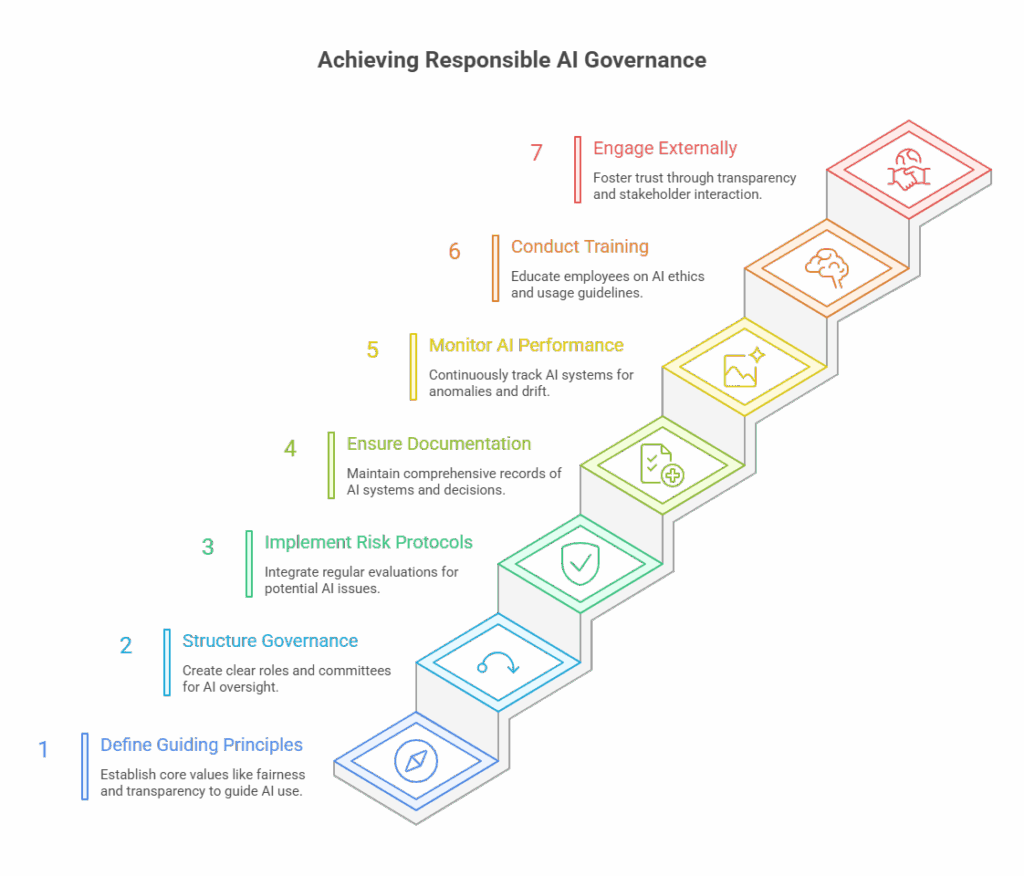

Budowanie ram governance od zera może wydawać się trudne, ale warto rozłożyć je na kilka głównych komponentów. Zgodnie z najlepszymi praktykami branżowymi, solidne ramy powinny zawierać następujące elementy:

- Wartości przewodnie: Na początek warto zdefiniować główne zasady, które będą kierować wykorzystaniem AI – np. sprawiedliwość, przejrzystość, prywatność, bezpieczeństwo i odpowiedzialność. Te wartości stanowią etyczny kompas wszystkich projektów AI, zapewniając ich zgodność zarówno z wartościami firmy, jak i oczekiwaniami społecznymi.

- Struktura i role w governance: Należy jasno określić strukturę organizacyjną odpowiedzialną za nadzór nad AI. Może to oznaczać powołanie komitetu ds. zarządzania AI lub rady etyki AI (więcej na ten temat później), a także zdefiniowanie ról takich jak data steward, właściciel modelu czy nawet Chief AI Ethics Officer. Jasne przypisanie odpowiedzialności gwarantuje, że nadzór jest obecny na każdym etapie cyklu życia AI. Przykładowo – kto musi zatwierdzić model przed jego wdrożeniem? Kto odpowiada za reakcję w przypadku błędnego działania systemu? Struktura governance odpowiada na te pytania.

- Protokoły oceny ryzyka: Proces rozwoju AI powinien uwzględniać zarządzanie ryzykiem. Oznacza to regularną ocenę potencjalnych zagrożeń, takich jak uprzedzenia w danych, wpływ na prywatność, podatności bezpieczeństwa oraz zgodność z przepisami prawa. Można stosować narzędzia takie jak zestawy testów biasu czy oceny wpływu AI. Ramy powinny precyzować, kiedy przeprowadzać te oceny (np. przed wdrożeniem i okresowo później) oraz jak reagować na wykryte ryzyka. Systematyczne podejście do ryzyka ogranicza prawdopodobieństwo wystąpienia poważnych incydentów lub naruszeń regulacyjnych.

- Dokumentacja i możliwość śledzenia: Podstawą odpowiedzialnego AI jest szczegółowa dokumentacja. Każdy system AI (w tym modele takie jak ChatGPT, które firma wdraża lub integruje) powinien posiadać zapis celu, sposobu działania, danych treningowych oraz znanych ograniczeń. Dokumentowanie źródeł danych i decyzji modelu tworzy ścieżkę audytu, wspierając wyjaśnialność. Coraz więcej firm wdraża Karty Modelu (Model Cards) i Arkusze Danych (Data Sheets) jako standardowe formaty dokumentacji. Dobra dokumentacja pozwala prześledzić, jak i dlaczego system AI wygenerował daną odpowiedź – co ma ogromne znaczenie podczas debugowania, audytu lub komunikacji z interesariuszami.

- Monitoring i nadzór człowieka: Governance nie kończy się po wdrożeniu AI – kluczowe jest ciągłe monitorowanie. Zdefiniuj metryki wydajności i progi alarmowe dla swoich systemów AI oraz monitoruj je w czasie rzeczywistym, by wychwycić dryf modelu lub nietypowe wyniki. Uwzględnij mechanizmy human-in-the-loop, zwłaszcza w przypadkach o dużym znaczeniu. Oznacza to, że człowiek powinien mieć możliwość przeglądu lub korekty decyzji podejmowanych przez AI. Na przykład, jeśli ChatGPT generuje treści dla klientów, ludzie powinni zatwierdzać wrażliwą komunikację. Stały monitoring umożliwia szybką reakcję w razie spadku jakości działania lub nieoczekiwanych zachowań modelu.

- Szkolenia i świadomość: Nawet najlepsze polityki AI mogą zawieść, jeśli pracownicy nie są ich świadomi. Ramy governance powinny obejmować szkolenia dla personelu z zasad korzystania z AI i etyki. Należy edukować pracowników, jakie dane wolno wprowadzać do narzędzi takich jak ChatGPT (by uniknąć wycieków), oraz jak krytycznie analizować wyniki AI, zamiast ufać im bezrefleksyjnie. Budowanie wewnętrznej kultury odpowiedzialnego użycia AI jest równie ważne co aspekty techniczne.

- Transparentność zewnętrzna i zaangażowanie: Wiodące organizacje idą o krok dalej i otwarcie komunikują światu, jak korzystają z AI. Może to oznaczać publikację polityki wykorzystania AI lub oświadczenia etycznego, a także informowanie o sposobach testowania i monitorowania modeli AI. Angażowanie interesariuszy zewnętrznych – klientów, regulatorów czy opinii publicznej – buduje zaufanie. Na przykład, jeśli firma używa AI do rekrutacji lub udzielania kredytów, warto wyjaśnić, jak minimalizowane są uprzedzenia i jak zapewniana jest sprawiedliwość. W niektórych przypadkach warto dopuścić zewnętrzne audyty lub włączyć się w inicjatywy branżowe dotyczące etyki AI – to silny sygnał, że firma poważnie traktuje odpowiedzialność technologiczną.

Te elementy razem tworzą kompleksowe ramy governance. Wartości przewodnie wpływają na polityki; struktury governance egzekwują te polityki; oceny ryzyka i dokumentacja zapewniają przejrzystość i odpowiedzialność; a monitoring z udziałem człowieka zamyka pętlę, wychwytując problemy w czasie rzeczywistym. Dobrze dopasowane do kontekstu organizacji, takie ramy stają się potężnym narzędziem do zarządzania AI w sposób bezpieczny, etyczny i skuteczny.

4. Nowe standardy audytu i dokumentacji AI

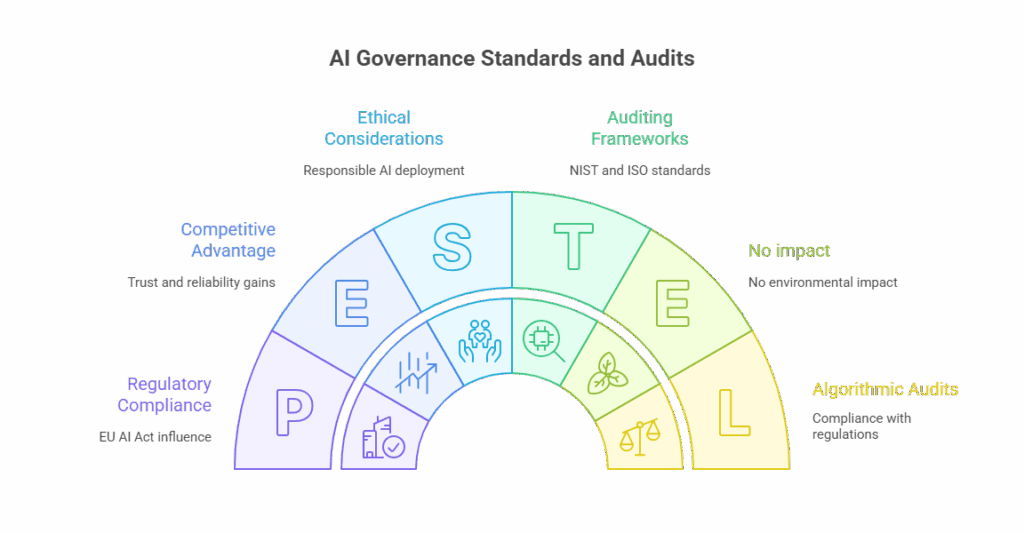

W związku z błyskawicznym rozwojem technologii AI, instytucje normalizacyjne i regulatorzy na całym świecie intensywnie pracują nad wytycznymi dla wiarygodnych systemów sztucznej inteligencji. Firmy budujące własne ramy governance powinny znać kluczowe standardy i dobre praktyki dotyczące audytu, przejrzystości i zarządzania ryzykiem:

- Framework zarządzania ryzykiem AI (NIST AI RMF): Na początku 2023 r. amerykański Narodowy Instytut Standaryzacji i Technologii (NIST) opublikował kompleksowy framework do zarządzania ryzykiem AI. Choć dobrowolny, został szeroko przyjęty jako wzorzec identyfikacji i kontroli ryzyk związanych z AI. Framework zawiera funkcje takie jak Govern, Map, Measure i Manage, które pomagają strukturze organizacyjnej podejść do ryzyka systematycznie. W 2024 r. NIST dodał profil dla generatywnej AI, by uwzględnić zagrożenia specyficzne dla narzędzi takich jak ChatGPT. Przedsiębiorstwa mogą korzystać z tego frameworka jako zestawu narzędzi audytowych – do oceny istnienia procesów governance, zrozumienia kontekstu zastosowania AI, pomiaru wydajności i wiarygodności oraz zarządzania ryzykiem przez odpowiednie mechanizmy nadzoru.

- ISO/IEC 42001:2023 (Standard zarządzania systemami AI): Opublikowany pod koniec 2023 roku, ISO/IEC 42001 to pierwszy na świecie międzynarodowy standard zarządzania systemami AI. Można go porównać do norm ISO dla zarządzania jakością – ale dedykowany AI. Organizacje mogą zdecydować się na certyfikację względem ISO 42001, by wykazać, że posiadają formalny system governance AI. Standard opiera się na cyklu Plan-Do-Check-Act i wymaga zdefiniowania zakresu działania systemów AI, identyfikacji ryzyk i celów, wdrożenia kontroli, monitorowania wyników i ciągłego doskonalenia. Choć zgodność ze standardem jest dobrowolna, ISO 42001 to ustrukturyzowany szkielet audytowy, zgodny z globalnymi dobrymi praktykami – szczególnie przydatny dla firm działających w branżach regulowanych lub na wielu rynkach.

- Model Cards i Data Sheets dla przejrzystości: W obszarze AI dużą popularność zdobyły dwa wpływowe formaty dokumentacji – Model Cards (wprowadzone przez Google) i Data Sheets dla zbiorów danych. Są to ustandaryzowane szablony raportów towarzyszące modelom AI i zestawom danych. Model Card dokumentuje przeznaczenie modelu, jego metryki wydajności (w tym dokładność i wskaźniki uprzedzeń), ograniczenia oraz kwestie etyczne. Data Sheets pełnią podobną rolę w odniesieniu do danych – opisują sposób pozyskania danych, ich zawartość oraz ewentualne problemy z jakością czy stronniczością. Coraz więcej organizacji wdraża takie dokumentacje jako część governance, co zwiększa przejrzystość i ułatwia audyty. Przykładowo, przegląd Model Card umożliwia audytorowi (lub radzie etycznej AI) szybkie zrozumienie, czy model był testowany pod kątem uczciwości i w jakich sytuacjach nie powinien być stosowany. Te praktyki stają się wręcz obowiązkowymi krokami przy wdrażaniu odpowiedzialnego AI i pomagają unikać niezamierzonych szkód.

- Audyty algorytmiczne: Oprócz samooceny coraz więcej mówi się o niezależnych audycie algorytmicznym. To audyty (często prowadzone przez zewnętrznych ekspertów lub firmy audytorskie), które oceniają zgodność systemów AI z określonymi standardami lub ich wpływ na uczciwość, prywatność itd. Na przykład Nowy Jork wprowadził obowiązek corocznych audytów uprzedzeń w narzędziach AI używanych do rekrutacji. Podobnie unijne przepisy dotyczące AI będą wymagać oceny zgodności (czyli formy audytu i dokumentacji) dla systemów AI „wysokiego ryzyka” przed ich wdrożeniem. Firmy powinny się przygotować, że zewnętrzne audyty staną się normą w przypadku wrażliwych zastosowań AI – i już dziś projektować systemy tak, by były możliwe do audytowania. Ramy governance uwzględniające dokumentację, śledzenie decyzji i testowanie znacznie to ułatwiają.

- Unijny AI Act i zgodność regulacyjna: Unijny AI Act, sfinalizowany w 2024 roku, będzie jednym z pierwszych globalnych aktów prawnych regulujących AI. Przewiduje surowe wymogi dla systemów AI wysokiego ryzyka (np. w ochronie zdrowia, finansach, HR) – obejmujące m.in. ocenę ryzyka, przejrzystość, nadzór ludzki, jakość danych. Firmy oferujące lub wykorzystujące AI w UE będą musiały prowadzić szczegółową dokumentację techniczną, prowadzić logi systemowe i często przechodzić audyty lub procesy certyfikacji. Nawet poza UE, ten akt wpływa na standardy międzynarodowe – inne jurysdykcje przygotowują podobne regulacje, a minimalnie już dziś obowiązujące prawo (np. RODO) reguluje przetwarzanie danych osobowych i decyzje podejmowane automatycznie. Dla firm oznacza to, że zgodność regulacyjna powinna być uwzględniana od początku w ramach governance AI. Przyjęcie już teraz frameworków takich jak NIST czy ISO 42001 pozwala zbudować gotowość na nowe wymogi. Wniosek: nowe standardy etyki i governance AI stają się integralną częścią prowadzenia biznesu – a firmy, które wdrażają je proaktywnie, zyskują nie tylko spokój prawny, ale też przewagę konkurencyjną dzięki zaufaniu i wiarygodności.

5. Tworzenie rad etyki AI w dużych organizacjach

Jednym z wyraźnych trendów w obszarze odpowiedzialnego AI jest powoływanie rad etyki AI (lub komitetów doradczych) w ramach organizacji. To interdyscyplinarne zespoły odpowiedzialne za nadzór, doradztwo i rozliczalność projektów AI. Taka rada zazwyczaj opiniuje planowane wdrożenia, wspiera w rozwiązywaniu dylematów etycznych i pilnuje, by wykorzystanie AI było zgodne z zasadami firmy i wartościami społecznymi. W firmach, które intensyfikują wdrożenia AI, utworzenie rady etycznej może być silnym środkiem governance – ale jej skuteczność zależy od przemyślanej struktury.

Wiele czołowych firm technologicznych wdrożyło lub testowało tego typu sugestie. Microsoft powołał wewnętrzny komitet AETHER (AI Ethics and Effects in Engineering and Research), który doradza kierownictwu w sprawach związanych z etyką AI. DeepMind (część Google) utworzył Komitet Przeglądu Instytucjonalnego, który analizował m.in. etyczne konsekwencje udostępnienia systemu AlphaFold. Nawet Meta (Facebook) stworzyła Oversight Board – choć ten organ skupia się głównie na treściach publikowanych przez użytkowników. Wszystko to pokazuje, że rady etyki mogą mieć realny wpływ na rozwój AI.

Jednak nie brakuje też głośnych porażek tych inicjatyw. Google w 2019 r. powołało zewnętrzną radę doradczą AI (ATEAC), która została rozwiązana po zaledwie tygodniu z powodu kontrowersji wokół członków i protestów wewnętrznych. Z kolei firma Axon (dostawca narzędzi dla służb porządkowych) rozwiązała swoją radę etyki AI, gdy firma zdecydowała się rozwijać projekt z wykorzystaniem dronów z paralizatorami, mimo sprzeciwu większości doradców etycznych. Pokazuje to, że rada etyki AI bez właściwego umocowania może być nieskuteczna, a nawet szkodliwa wizerunkowo.

Jak zatem zbudować radę etyki AI, która faktycznie działa? Badania i praktyka wskazują na kilka kluczowych decyzji projektowych:

- Cel i zakres działania: Jasno określ, jakie kompetencje będzie miała rada. Czy będzie to ciało doradcze bez mocy decyzyjnej, czy może będzie miała uprawnienia do blokowania wdrożeń (np. prawo weta dla wybranych zastosowań AI)? Kluczowe jest też zdefiniowanie zakresu działania – czy rada opiniuje wszystkie projekty AI, czy tylko te wysokiego ryzyka?

- Struktura i uprawnienia: Określ strukturę organizacyjną rady. Czy to wewnętrzny komitet raportujący do zarządu, czy zewnętrzna rada złożona z niezależnych ekspertów? Część firm stawia na członków zewnętrznych, by zapewnić obiektywizm, inne wolą wewnętrzną kontrolę. Niezależnie od wyboru, rada powinna mieć bezpośredni dostęp do najwyższego kierownictwa, by jej głos był słyszany i miał realny wpływ.

Skład zespołu: Wybierz członków o zróżnicowanych kompetencjach. Kwestie etyki AI obejmują technologię, prawo, etykę, strategię biznesową i politykę publiczną. Mieszanka ekspertów – data scientists, etyków, prawników/specjalistów ds. zgodności, liderów biznesowych, a nawet przedstawicieli klientów czy doradców akademickich – zapewnia bardziej wszechstronną perspektywę. Różnorodność płci, pochodzenia i doświadczeń kulturowych również odgrywa kluczową rolę – pozwala wnieść szerszą perspektywę, wzbogacić proces decyzyjny i zwiększyć trafność ocen etycznych.. Trzeba także rozważyć liczebność – zbyt duży zespół może być nieefektywny, zbyt mały – zbyt jednostronny.

- Procesy i podejmowanie decyzji: Określ, jak rada będzie funkcjonować. Jak często się spotyka? W jaki sposób ocenia projekty AI – czy korzysta z checklisty lub wytycznych (np. zgodnych z zasadami AI przyjętymi w firmie)? Jak zapadają decyzje – poprzez konsensus, głosowanie większościowe, czy rada jedynie doradza, a decyzje podejmują liderzy? Kluczowe jest też ustalenie, czy rekomendacje rady będą wiążące. Nadanie radzie realnego wpływu – choćby w formie autorytetu moralnego – pozwala jej skutecznie wpływać na projekty. Jeśli będzie tylko fasadowa, świadomi pracownicy i interesariusze szybko to zauważą.

- Zasoby i integracja: Aby rada była skuteczna, potrzebuje dostępu do informacji i odpowiednich zasobów. Może to oznaczać briefingi od zespołów inżynieryjnych, budżet na konsultacje z zewnętrznymi ekspertami lub audyty, a także szkolenia z najnowszych zagadnień związanych z AI. Rekomendacje rady powinny być włączone w cykl rozwoju produktów – np. wymóg zatwierdzenia etycznego przed uruchomieniem nowej funkcji opartej na AI. W firmie Microsoft wewnętrzna komisja ds. etyki AI tworzy grupy robocze z udziałem inżynierów, by lepiej wdrażać swoje zalecenia. Rada nie powinna działać w oderwaniu, ale być zintegrowana z procesami zarządzania AI w firmie.

- Zdefiniuj zasady i polityki dotyczące AI: Zacznij od sformułowania zestawu zasad odpowiedzialnego wykorzystania AI dla swojej organizacji. Mogą one odzwierciedlać standardy branżowe (np. zasady Microsoftu: sprawiedliwość, niezawodność i bezpieczeństwo, prywatność i ochrona, inkluzywność, przejrzystość i odpowiedzialność) lub być dostosowane do misji Twojej firmy. Na ich podstawie opracuj konkretne polityki, które będą regulować wykorzystanie AI. Przykładowa polityka może zakładać, że każdy model AI mający wpływ na klientów musi być przetestowany pod kątem uprzedzeń, a pracownikom nie wolno wprowadzać danych poufnych do publicznych narzędzi AI. Polityki powinny być jasno komunikowane w całej organizacji i formalnie zatwierdzone przez kierownictwo – to ważny sygnał z góry.

- Sporządź inwentaryzację i ocenę zastosowań AI: Trudno zarządzać tym, czego się nie zna. Przeanalizuj wszystkie systemy AI i uczenia maszynowego wykorzystywane lub rozwijane w Twoim przedsiębiorstwie. Obejmuje to zarówno oczywiste projekty (np. wewnętrzny chatbot oparty na GPT-4 do obsługi klienta), jak i mniej oczywiste (np. algorytm stworzony w Excelu lub zewnętrzna usługa AI używana przez dział HR). Dla każdego rozwiązania oceń poziom ryzyka: Jak krytyczna jest jego funkcja? Czy przetwarza dane osobowe lub wrażliwe? Czy jego działanie może istotnie wpłynąć na ludzi lub firmę? Taka inwentaryzacja AI i ocena ryzyka pozwala określić priorytety dla działań nadzoru. Zastosowania wysokiego ryzyka powinny być objęte ścisłym nadzorem i wymagać zatwierdzenia przez komitet ds. AI przed ich wdrożeniem.

- Ustanów struktury zarządzania i role: Stwórz struktury nadzorujące zastosowania AI. W zależności od wielkości i potrzeb firmy może to być komitet ds. AI, który spotyka się okresowo, lub pełnoprawna rada etyki AI, jak wcześniej opisano. Zapewnij sponsora na poziomie zarządu (np. Chief Data Officer lub dyrektor działu prawnego) oraz udział przedstawicieli kluczowych działów: IT, bezpieczeństwa, zgodności oraz jednostek biznesowych korzystających z AI. Wyznacz ścieżki eskalacji – np. co zrobić, jeśli system AI wygeneruje niepokojący wynik? Niektóre firmy wyznaczają również liderów AI lub koordynatorów ds. etyki w zespołach, by połączyć je z centralną strukturą governance. Celem jest stworzenie sieci odpowiedzialności – każdy wie, że projekty AI nie funkcjonują w próżni, lecz są objęte przeglądami i dokumentacją zgodnie z przyjętym modelem zarządzania.

- Włącz testy, audyty i dokumentację w proces wytwórczy: Odpowiedzialne AI musi być elementem procesu rozwoju. Każdy nowy system AI powinien być poddany określonym testom (np. na uprzedzenia, odporność, wpływ na prywatność) oraz udokumentowany (np. poprzez uproszczoną kartę modelu lub dokument projektowy). Wprowadzenie szablonów projektów AI może być pomocne – np. checklisty, którą każdy product manager uzupełnia, opisując wykorzystane dane, sposób walidacji modelu i przeanalizowane ryzyka etyczne. To nie tylko wspiera dobre praktyki, lecz także zapewnia niezbędną dokumentację do audytów i celów zgodności. Dla kluczowych systemów warto zaplanować niezależne audyty – wewnętrzne lub zewnętrzne – oceniające rozwiązanie pod kątem np. sprawiedliwości czy bezpieczeństwa. Włączając te kroki w cykl życia rozwoju (np. jako bramy przed wdrożeniem produkcyjnym), firma zapewnia, że governance AI nie jest dodatkiem, lecz integralnym elementem jakości produktu.

- Zapewnij szkolenia i wsparcie: Wyposaż pracowników w wiedzę potrzebną do odpowiedzialnego korzystania z AI. Organizuj szkolenia na temat dobrych i złych praktyk przy używaniu narzędzi takich jak ChatGPT w pracy. Przykładowo – wyjaśnij, jakie dane uznaje się za wrażliwe i których nie należy nigdy udostępniać zewnętrznym usługom AI. Naucz deweloperów bezpiecznych praktyk kodowania AI oraz interpretowania wskaźników sprawiedliwości. Pracownicy nietechniczni też potrzebują wskazówek, jak oceniać wyniki AI – np. rekruter korzystający z listy kandydatów wygenerowanej przez AI powinien stosować także własny osąd i mieć świadomość potencjalnych uprzedzeń. Warto stworzyć wewnętrzne centrum wiedzy lub kanał Slackowy nt. governance AI, gdzie można zadawać pytania lub zgłaszać problemy. Świadomi pracownicy znacznie rzadziej dopuszczają się niezamierzonych naruszeń polityki AI.

- Monitoruj, ucz się i doskonal: Zarządzanie AI to nie jednorazowa inicjatywa, lecz program wymagający ciągłego rozwoju. Ustal metryki dla samego procesu zarządzania – np. ile systemów AI przeszło testy na uprzedzenia albo jak często dochodzi do incydentów związanych z AI i jak szybko są rozwiązywane. Regularnie przeglądaj te dane z komitetem ds. ładu AI. Wprowadź mechanizm informacji zwrotnej: gdy coś pójdzie nie tak (np. błąd modelu AI spowoduje pomyłkę lub zagrożenie zgodności z regulacjami), przeanalizuj to i zaktualizuj procesy, aby zapobiec powtórce. Śledź też zmiany zewnętrzne – jeśli pojawi się nowe prawo lub zaktualizowany standard (np. nowa wersja ram NIST), uwzględnij je w swoich działaniach. Wiele firm przeprowadza coroczny przegląd swojego frameworku AI governance – podobnie jak aktualizują inne polityki wewnętrzne. Obszar AI rozwija się dynamicznie, dlatego zarządzanie nim musi ewoluować równie szybko.

Stosując powyższe kroki, przedsiębiorstwa mogą przejść od abstrakcyjnych zasad do konkretnych działań w obszarze zarządzania AI. Jeśli trzeba – zacznij od małych projektów pilotażowych, by dopracować podejście. Kluczowe jest zbudowanie firmowego przekonania, że odpowiedzialność za AI to wspólna sprawa. Z odpowiednim frameworkiem firmy mogą bezpiecznie i świadomie wykorzystywać ChatGPT i inne narzędzia AI, wiedząc, że działają w ramach jasno określonych zabezpieczeń.

6. Podsumowanie: Odpowiedzialne AI w środowisku korporacyjnym

Technologie AI, takie jak ChatGPT, otwierają przed biznesem ekscytujące możliwości – od automatyzacji powtarzalnych zadań po odkrywanie ukrytych wzorców w danych. Aby jednak w pełni wykorzystać te szanse, firmy muszą zmierzyć się z wyzwaniem odpowiedzialności: korzystać z AI w sposób etyczny, przejrzysty i zgodny z prawem oraz wartościami firmy. Dobrą wiadomością jest to, że wdrażając framework zarządzania AI, przedsiębiorstwa mogą z powodzeniem integrować sztuczną inteligencję z codziennymi operacjami. Wymaga to przejrzystych zasad (polityki i wartości), skuteczne mechanizmy bezpieczeństwa (audyty, monitoring, dokumentacja) i kulturę odpowiedzialności (w tym nadzór zarządu oraz rady etyki).

Wdrożenie odpowiedzialnego ładu AI może wymagać nowych kompetencji i zaangażowania – ale nie musisz działać sam. Jeśli Twoja firma chce rozwijać rozwiązania AI oparte na solidnym fundamencie etyki i zgodności, warto współpracować z doświadczonym partnerem. TTMS oferuje usługi wspierające firmy w odpowiedzialnym wdrażaniu AI – od budowania frameworków governance i strategii zgodności, po tworzenie dedykowanych aplikacji AI. Z odpowiednim wsparciem możesz wykorzystać AI do zwiększenia efektywności i rozwoju, nie rezygnując z zasad etyki i odpowiedzialności. W erze transformacji napędzanej AI, liderami zostaną ci, którzy połączą innowację z integralnością – wyznaczając nowe standardy odpowiedzialnego biznesu opartego na sztucznej inteligencji.

Czym są odpowiedzialne ramy zarządzania AI?

To uporządkowany zestaw polityk, procesów i ról, które organizacja wdraża, aby zapewnić, że jej systemy AI są rozwijane i wykorzystywane w sposób etyczny, bezpieczny i zgodny z prawem. Odpowiedzialne ramy governance AI zazwyczaj określają kluczowe zasady (takie jak sprawiedliwość, przejrzystość i odpowiedzialność), opisują sposoby oceny i ograniczania ryzyk oraz przydzielają obowiązki nadzorcze. W praktyce przypominają one wewnętrzny kodeks postępowania lub system zarządzania jakością dla AI. Ramy mogą zawierać m.in. wymagania dotyczące dokumentowania działania modeli AI, testowania ich pod kątem uprzedzeń lub błędów, monitorowania decyzji i zapewnienia udziału człowieka przy istotnych rezultatach. Dzięki przestrzeganiu takich ram firmy mogą mieć pewność, że ich projekty AI spełniają określone standardy i nie niosą za sobą niezamierzonych szkód ani ryzyka niezgodności z przepisami.

Dlaczego należy zarządzać wykorzystaniem ChatGPT w firmie?

Narzędzia takie jak ChatGPT mogą znacząco zwiększyć produktywność – pomagają np. w generowaniu raportów, streszczaniu dokumentów czy wspieraniu obsługi klienta. Jednak bez odpowiednich zasad ich użycie może wiązać się z ryzykiem. ChatGPT potrafi tworzyć nieprawdziwe informacje (tzw. halucynacje), które – jeśli zostaną potraktowane jako fakty – mogą wprowadzić w błąd pracowników lub klientów. Może także nieumyślnie generować nieodpowiednie lub stronnicze treści, jeśli zostanie odpowiednio sprowokowany.

Dodatkowo, jeśli pracownicy wprowadzą do ChatGPT poufne dane, opuszczą one bezpieczne środowisko firmy – ChatGPT to zewnętrzna usługa, więc te informacje mogą potencjalnie trafić do nieuprawnionych osób. Dochodzą też aspekty prawne – korzystanie z wyników AI bez weryfikacji może prowadzić do naruszenia przepisów, a prawo o ochronie danych osobowych zabrania przekazywania danych wrażliwych na zewnętrzne platformy bez odpowiednich zabezpieczeń.

Governance (zarządzanie) oznacza w tym kontekście wprowadzenie zasad i mechanizmów kontroli, które pozwalają korzystać z ChatGPT bezpiecznie. Obejmuje to np. reguły dotyczące tego, czego nie wolno robić (np. nie wklejać danych klientów), procesy weryfikacji treści generowanych przez AI oraz monitorowanie użycia narzędzia pod kątem niepokojących sygnałów.

Podsumowując: zarządzanie ChatGPT pozwala czerpać korzyści z jego szybkości i wydajności, a jednocześnie ogranicza ryzyko błędów, wycieków i problemów etycznych w działalności firmy.

Czym jest rada etyki AI i czy powinniśmy ją mieć?

Rada etyki AI to zespół (zazwyczaj międzydziałowy, czasem z udziałem ekspertów zewnętrznych), który nadzoruje etyczne i odpowiedzialne wykorzystanie sztucznej inteligencji w organizacji. Jej głównym celem jest analiza i doradztwo w zakresie tworzenia i wdrażania AI tak, aby było to zgodne z zasadami etycznymi i pozwalało ograniczać ryzyko.

Taka rada może np. oceniać planowane projekty AI pod kątem potencjalnych problemów (uprzedzenia, prywatność, wpływ społeczny), proponować lub dopracowywać polityki dotyczące AI, a także zabierać głos w razie kontrowersji czy incydentów.

Czy Twoja firma jej potrzebuje? To zależy od skali wykorzystania AI i poziomu ryzyka. Duże organizacje lub firmy stosujące AI w wrażliwych obszarach (np. zdrowie, finanse, rekrutacja) często zyskują na posiadaniu rady etyki, ponieważ wnosi ona różnorodne perspektywy i specjalistyczną wiedzę. Nawet w mniejszych firmach warto rozważyć powołanie komitetu lub zespołu ds. etyki AI, który gromadzi wiedzę i dobre praktyki w jednym miejscu.

Kluczowe jednak jest, by taka rada miała jasny mandat i poparcie zarządu. Musi mieć realny wpływ na decyzje – w przeciwnym razie stanie się jedynie fasadą.

Podsumowując: rada etyki AI to cenne narzędzie governance, które zapewnia odpowiedzialność i stanowi forum do zadania pytania: „czy powinniśmy to robić?”, a nie tylko: „czy potrafimy to zrobić?” – gdy chodzi o inicjatywy związane ze sztuczną inteligencją.

Jak możemy audytować nasze systemy AI pod kątem sprawiedliwości i dokładności?

Audytowanie systemów AI polega na sprawdzeniu, czy działają one zgodnie z założeniami i nie generują niepożądanych skutków.

Aby ocenić sprawiedliwość, często analizuje się metryki działania modelu w podziale na różne grupy danych – np. demograficzne. Przykładowo, jeśli system AI służy do preselekcji kandydatów do pracy, warto sprawdzić, czy jego rekomendacje nie różnią się istotnie między kobietami a mężczyznami lub w zależności od pochodzenia etnicznego. Wiele firm wykorzystuje w tym celu specjalistyczne narzędzia, jak np. AI Fairness 360 Toolkit opracowany przez IBM, które wspomagają testy uprzedzeń.

Jeśli chodzi o dokładność i wydajność, audyt może obejmować testy na zestawie benchmarków lub realistycznych scenariuszy, aby zmierzyć wskaźniki błędów. Dla modeli generatywnych (np. ChatGPT) oznacza to ocenę, jak często model tworzy niepoprawne, mylące lub niestosowne treści przy różnych typach zapytań.

Ważne jest też przeprowadzenie audytu danych i założeń, na których oparto model – sprawdzenie, czy dane treningowe nie były stronnicze lub zawierały błędy, to kluczowy element oceny.

Coraz częściej stosuje się również audyt proceduralny, czyli weryfikację, czy zespół tworzący AI przestrzegał ustalonych zasad governance – np. czy przeprowadzono ocenę wpływu na prywatność, czy dokonano niezależnego przeglądu projektu.

W zależności od znaczenia danego systemu, audyt może być prowadzony przez wewnętrzne zespoły audytowe lub zewnętrznych audytorów. Warto też pamiętać, że zbliżające się regulacje (np. unijny AI Act) mogą w niektórych przypadkach wymagać formalnych audytów zgodności dla systemów AI wysokiego ryzyka.

Regularne audytowanie systemów AI pozwala wcześnie wykrywać problemy i pokazuje, że firma poważnie traktuje odpowiedzialność w zarządzaniu technologiami AI.

Czy istnieją przepisy prawa dotyczące AI, z którymi musimy się liczyć?

Tak – środowisko regulacyjne dotyczące sztucznej inteligencji bardzo szybko się rozwija. Już teraz ogólne przepisy o ochronie danych osobowych – takie jak RODO w Europie czy różne ustawy o prywatności obowiązujące w innych krajach – mają bezpośredni wpływ na zastosowania AI, ponieważ regulują wykorzystanie danych osobowych i podejmowanie decyzji w sposób zautomatyzowany.

Na przykład RODO przyznaje jednostkom prawo do uzyskania wyjaśnienia decyzji podjętej przez AI w określonych sytuacjach oraz nakłada ścisłe wymagania dotyczące przetwarzania danych – więc każdy system AI wykorzystujący dane osobowe musi być z nimi zgodny.

Poza tym, na horyzoncie pojawiają się nowe regulacje dedykowane sztucznej inteligencji. Najważniejszym przykładem jest unijna ustawa o AI (AI Act), która wprowadzi wymogi w zależności od poziomu ryzyka związanego z systemem AI. Systemy wysokiego ryzyka (np. stosowane w ochronie zdrowia, finansach, rekrutacji) będą musiały przechodzić oceny bezpieczeństwa, sprawiedliwości i przejrzystości przed wdrożeniem, a ich twórcy będą zobowiązani do prowadzenia dokumentacji i logów umożliwiających audyt.

Równolegle pojawiają się też regulacje branżowe. Przykładowo, w USA nadzór finansowy wydał wytyczne dotyczące AI w bankowości, EEOC przygląda się zastosowaniom AI w rekrutacji, a niektóre stany – jak Nowy Jork – już dziś wymagają audytów uprzedzeń dla algorytmów używanych przy zatrudnianiu.

Choć obecnie nie istnieje jedna globalna ustawa o AI, trend jest jasny: regulatorzy oczekują od firm aktywnego zarządzania ryzykiem związanym z AI. Dlatego warto już teraz wdrożyć ramy governance – pozwolą one spełnić nowe wymogi, gdy zaczną obowiązywać.

Zachowanie przejrzystości, dokumentacji i sprawiedliwości w systemach AI nie tylko ułatwi zgodność z przepisami, ale również zbuduje wizerunek odpowiedzialnej i godnej zaufania organizacji. Warto też śledzić lokalne regulacje w krajach, w których prowadzicie działalność, i – jeśli potrzeba – konsultować się z prawnikami. Prawo dotyczące AI zmienia się bardzo dynamicznie.