Zaskakująco wielu pracowników wkleja poufne informacje firmowe do publicznych narzędzi AI — według jednego z raportów z 2025 roku, aż 77% pracowników udostępniło wrażliwe dane za pośrednictwem ChatGPT lub podobnych narzędzi. Generatywna AI błyskawicznie stała się głównym kanałem wycieków danych w firmach, co postawiło CIO i CISO w stan najwyższej gotowości. Jednak trudno oprzeć się możliwościom, jakie oferuje GPT. Dla dużych firm pytanie nie brzmi już „Czy powinniśmy korzystać z AI?”, lecz „Jak możemy korzystać z GPT na własnych zasadach, nie ryzykując danych?”

Odpowiedź, która coraz częściej pojawia się w salach zarządu, to budowa prywatnej warstwy GPT – czyli własnego firmowego ChatGPT, działającego wewnątrz zabezpieczonego środowiska IT. Dzięki temu podejściu firmy mogą wykorzystywać najnowocześniejsze modele GPT jako silnik rozumowania, a jednocześnie zachować pełną kontrolę nad danymi. W tym artykule pokażemy, jak duże organizacje mogą wdrożyć własnego asystenta AI opartego na GPT: omówimy architekturę (API GPT, wektorowe bazy danych, kontrola dostępu, szyfrowanie), dobre praktyki zapobiegające halucynacjom i błędom, realistyczne koszty (od ~50 tys. do kilku milionów dolarów) oraz strategiczne korzyści z posiadania własnego „AI brain”. Zaczynajmy.

1. Dlaczego firmy stawiają na prywatne warstwy GPT

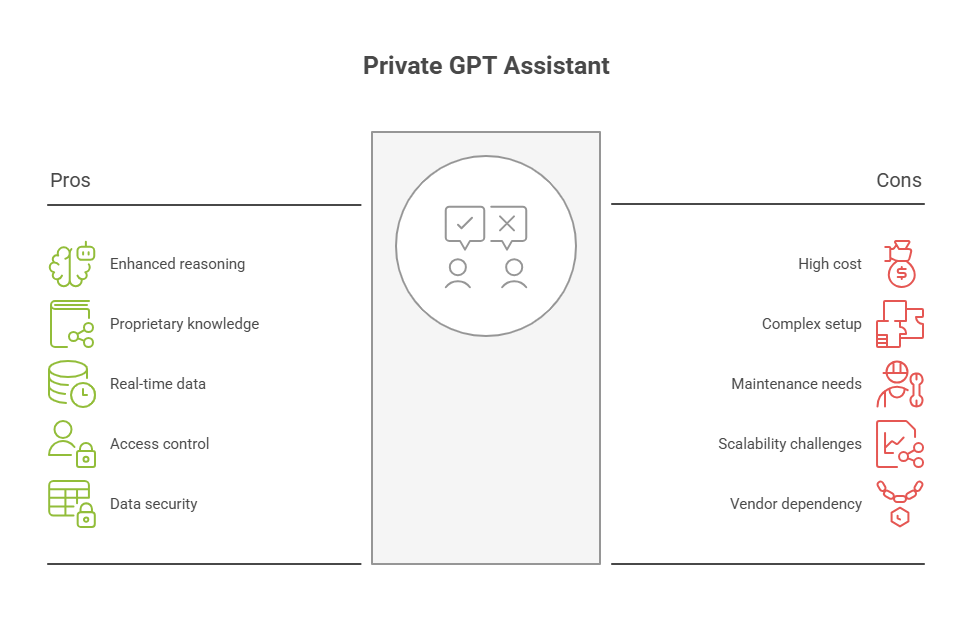

Publiczne usługi AI, takie jak ChatGPT, Google Bard czy Claude, pokazały ogromne możliwości generatywnej AI – ale z punktu widzenia firm budzą poważne wątpliwości. Prywatność danych, zgodność z regulacjami i kontrola to główne wyzwania. Liderzy IT obawiają się, gdzie trafiają ich dane i czy nie zostaną wykorzystane do trenowania modeli należących do innych firm. Co więcej, regulatorzy zaczęli działać stanowczo (np. unijna AI Act, RODO), czasowo nawet ograniczając dostęp do narzędzi takich jak ChatGPT z powodu problemów z prywatnością. Incydenty bezpieczeństwa potwierdziły te obawy – pracownicy nieświadomie tworzą zagrożenia typu „shadow AI”, kopiując poufne informacje do chatbotów, dochodzi też do ataków prompt injection i wycieków danych z historii czatów. Dodatkowo, opieranie się na zewnętrznym API AI to ryzyko nieprzewidywalnych zmian i przestojów – nieakceptowalne w przypadku krytycznych systemów firmowych.

Wszystko to przyspiesza zmianę podejścia. Rok 2026 zapowiada się jako przełomowy dla „prywatnej AI” – firmy coraz częściej wdrażają stosy AI własnym zakresie, dostosowane do ich danych i regulowane przez ich wewnętrzne zasady. W podejściu private GPT, modele są całkowicie kontrolowane przez organizację, dane pozostają w zaufanym środowisku, a użycie jest zgodne z polityką wewnętrzną. AI przestaje być publiczną usługą, a staje się częścią infrastruktury firmy. Efekt? Przedsiębiorstwa zyskują produktywność i inteligencję GPT, bez kompromisów w zakresie bezpieczeństwa i zgodności. To najlepsze z obu światów: innowacyjność AI i nadzór klasy enterprise.

2. Architektura prywatnej warstwy GPT: kluczowe komponenty i bezpieczeństwo

Stworzenie prywatnego asystenta opartego na GPT wymaga integracji kilku kluczowych elementów. Na wysokim poziomie polega to na połączeniu inteligencji dużego modelu językowego z danymi przedsiębiorstwa i opakowaniu tego wszystkiego w solidne warstwy bezpieczeństwa. Oto przegląd architektury i najważniejszych jej składników:

- Model GPT (silnik rozumowania przez API lub lokalnie): W centrum znajduje się duży model językowy – np. GPT-4/5 udostępniany przez API (OpenAI, Azure OpenAI itd.) lub samodzielnie hostowany model open source, jak LLaMA, uruchamiany na serwerach wewnętrznych. To mózg, który rozumie zapytania i generuje odpowiedzi. Wiele firm zaczyna od wykorzystania API zewnętrznego dostawcy, a z czasem przechodzi na wewnętrzne hostowanie modeli dopasowanych do własnych potrzeb. Niezależnie od wariantu, model GPT odpowiada za rozumowanie językowe i generowanie odpowiedzi.

- Wektorowa baza danych (wewnętrzna baza wiedzy): Wewnętrzny GPT będzie tak skuteczny, jak wiedza, którą mu udostępnisz. Zamiast próbować zmieścić całą firmową dokumentację w pojedynczym promptcie, wykorzystuje się wektorową bazę danych (np. Pinecone, Chroma, Weaviate) do przechowywania embeddingów dokumentów firmowych. To taka „pamięć długoterminowa” AI. Gdy użytkownik zadaje pytanie, system przekształca je w wektor i wyszukuje semantycznie pasujące dokumenty. Te informacje są następnie przekazywane do GPT jako kontekst dla odpowiedzi. To podejście znane jako RAG (Retrieval-Augmented Generation) pozwala GPT korzystać z Twojej firmowej bazy wiedzy w czasie rzeczywistym, zamiast polegać wyłącznie na danych treningowych. (Przykładowo: możesz zaindeksować pliki PDF, zasoby z SharePointa, artykuły z bazy wiedzy itp., dzięki czemu GPT będzie mógł odwołać się do najnowszych procedur lub polityk przy udzielaniu odpowiedzi.)

- Warstwa orkiestracji (przetwarzanie zapytań i integracje): Aby wszystko działało, potrzebne jest oprogramowanie pośredniczące (często niestandardowa aplikacja lub framework jak LangChain). Warstwa ta obsługuje cały przepływ zapytań: przyjmuje pytania od użytkownika, wyszukuje wektorowo dane, konstruuje prompt z kontekstem, wywołuje API modelu GPT i formatuje odpowiedź. Może również integrować dodatkowe funkcje – np. GPT może w trakcie rozmowy wywołać kalkulator lub sprawdzić dane w bazie. Logika orkiestracji zapewnia, że model GPT otrzymuje właściwy kontekst, a użytkownik – przydatną i czytelną odpowiedź (np. ze wskazaniem źródeł).

- Kontrola dostępu i autoryzacja: W przeciwieństwie do publicznego ChatGPT, prywatny GPT musi respektować uprawnienia wewnętrzne. Zastosowane są silne mechanizmy kontroli dostępu, dzięki którym użytkownicy widzą tylko dane, do których mają uprawnienia. Można to realizować poprzez tagowanie embeddingów i filtrowanie wyników na podstawie roli i poświadczeń użytkownika. Bardziej zaawansowane systemy stosują CBAC (context-based access control), czyli dynamiczną ocenę, czy dane mogą być udostępnione w danym kontekście (np. blokada, jeśli pracownik działu finansowego próbuje uzyskać dane HR). W skrócie: system egzekwuje polityki bezpieczeństwa obowiązujące w organizacji – AI udziela odpowiedzi tylko na podstawie danych, do których użytkownik ma dostęp.

- Szyfrowanie i bezpieczeństwo danych: Wszystkie dane przepływające przez prywatną warstwę GPT powinny być szyfrowane w spoczynku i w transmisji. Oznacza to szyfrowanie zawartości wektorowej bazy danych, cache’owanych rozmów itd., najlepiej przy użyciu kluczy zarządzanych przez firmę (np. z wykorzystaniem chmurowego Key Vaulta lub lokalnego HSM). W przypadku chmurowych usług wiele ofert dla firm umożliwia korzystanie z własnych kluczy szyfrowania. Dzięki temu nawet jeśli ktoś uzyska dostęp do surowej bazy danych (np. pracownik dostawcy chmury), dane będą bezużyteczne bez klucza. Komunikacja między komponentami (aplikacja, baza wektorowa, API GPT) odbywa się przez szyfrowane kanały (HTTPS/TLS), a wrażliwe pola mogą być maskowane lub hashowane. Niektóre organizacje idą dalej i szyfrują nawet embeddingi, by uniemożliwić odtworzenie oryginalnych treści. W praktyce szyfrowanie w spoczynku + w transmisji, z rygorystycznym zarządzaniem kluczami, zapewnia wysoki poziom ochrony nawet w przypadku potencjalnego naruszenia danych.

- Bezpieczne wdrożenie (VPC lub środowisko lokalne): Równie istotne jak same komponenty jest to, gdzie są one uruchomione. Najlepszą praktyką jest wdrożenie całego stosu AI w izolowanej, prywatnej sieci – na przykład w ramach Virtual Private Cloud (VPC) na AWS, Azure lub GCP albo w lokalnym centrum danych – bez publicznego dostępu do kluczowych komponentów. Taka izolacja sieciowa gwarantuje, że baza wektorowa, serwer aplikacji, a nawet punkt końcowy modelu GPT (jeśli korzystamy z API chmurowego) nie są dostępne z internetu. Dostęp możliwy jest wyłącznie z poziomu wewnętrznych aplikacji lub przez VPN. Nawet jeśli klucz API zostanie ujawniony, atakujący nie wykorzysta go, jeśli nie znajduje się w Twojej sieci. Ta zamknięta architektura znacząco ogranicza powierzchnię ataku.

2.1 GPT jako mózg, dane jako pamięć

W tej architekturze GPT pełni rolę warstwy rozumowania, a firmowe repozytorium danych – warstwy pamięci. Model dostarcza „mocy obliczeniowej” – rozumie zapytania użytkowników i generuje odpowiedzi – natomiast baza wektorowa dostarcza konkretnej wiedzy, z której może korzystać. GPT nie ma wbudowanej wiedzy o Twoich firmowych danych (i nie chcesz, by miało je na stałe w treningu), dlatego pobiera informacje w razie potrzeby. Przykładowo, GPT potrafi wygenerować instrukcję krok po kroku, ale gdy zostanie zapytane „Jaka jest nasza polityka gwarancyjna dla produktu X?”, pobierze odpowiednią treść z bazy i włączy ją do odpowiedzi. Taki podział obowiązków pozwala AI udzielać precyzyjnych, aktualnych i kontekstowych odpowiedzi. To działa jak u człowieka: GPT to elokwentny ekspert, a Twoje dokumenty i bazy danych to jego biblioteka referencyjna – razem dają odpowiedzi oparte na faktach.

3. Jak utrzymać aktualność wiedzy i ograniczyć halucynacje

Jedną z największych zalet prywatnej warstwy GPT jest możliwość aktualizacji wiedzy bez konieczności ciągłego trenowania modelu. W podejściu RAG (retrieval-augmented) pamięcią modelu jest po prostu Twoja baza wektorowa. Aktualizacja wiedzy AI sprowadza się do aktualizacji źródła danych: gdy pojawi się nowa polityka, raport czy procedura, wystarczy przetworzyć treść (podzielić, stworzyć embeddingi) i dodać ją do bazy. Kolejne zapytanie użytkownika znajdzie już te dane. Nie ma potrzeby ponownego trenowania modelu na każdą zmianę – wstrzykujesz aktualny kontekst w czasie rzeczywistym, co jest znacznie bardziej elastyczne. Dobrym podejściem jest automatyzacja procesu indeksowania (np. codzienne skanowanie zmian w dokumentach lub aktualizacje po publikacji), co pozwala utrzymać bazę wiedzy świeżą. Dzięki temu AI nie będzie odpowiadać na podstawie danych sprzed kwartału, jeśli dostępne są nowsze.

Nawet przy aktualnych danych modele GPT potrafią czasem halucynować – czyli pewnie wygenerować odpowiedź, która brzmi wiarygodnie, ale jest błędna lub nieoparta na przekazanym kontekście. Ograniczenie takich halucynacji ma kluczowe znaczenie w środowiskach biznesowych. Oto kilka najlepszych praktyk, które pomogą utrzymać prywatnego GPT na właściwym kursie:

- Osadzaj model w kontekście: Zawsze dostarczaj modelowi odpowiedni kontekst z firmowej bazy wiedzy i instruuj go, by trzymał się tych informacji. Już sama instrukcja w stylu: „Użyj poniższych informacji i nie dodawaj nic od siebie” znacząco zmniejsza ryzyko halucynacji. Jeśli model nie znajdzie odpowiedzi w danych, może odpowiedzieć komunikatem zastępczym (np. „Przepraszam, nie posiadam takich informacji.”) zamiast zgadywać. Im bardziej opierasz odpowiedzi na rzeczywistych dokumentach wewnętrznych, tym mniej miejsca na „kreatywność” modelu.

- Regularna weryfikacja i kuracja danych: Upewnij się, że treści w bazie wektorowej są dokładne i pochodzą z wiarygodnych źródeł. Archiwizuj lub oznaczaj nieaktualne dokumenty, by nie były używane. Warto też przeanalizować, z jakich źródeł AI korzysta – w przypadku kluczowych tematów zlecaj przegląd ekspertom merytorycznym. Zasada jest prosta: garbage in, garbage out – jeśli baza wiedzy jest rzetelna, odpowiedzi AI też będą.

- Dostosuj prompt i parametry: Możesz ograniczyć „fantazjowanie” modelu poprzez ustawienia generowania. Na przykład niższy parametr temperature (odpowiedzialny za losowość odpowiedzi) sprawi, że wypowiedzi będą bardziej przewidywalne i faktograficzne. Pomaga też inżynieria promptów – np. prośba o dodanie źródeł do każdej informacji, co zmusza model do trzymania się dostarczonego kontekstu. Dobrze zaprojektowany prompt systemowy i spójne reguły stylu prowadzą do bardziej niezawodnego działania AI.

- Monitorowanie halucynacji i nadzór ludzki: W zastosowaniach o wysokim ryzyku wdrażaj proces recenzji. Możesz np. zaprogramować automatyczne wykrywanie potencjalnie błędnych lub ryzykownych odpowiedzi i kierować je do zatwierdzenia przez człowieka. Warto też mieć mechanizm feedbacku – jeśli użytkownik zauważy błąd, powinien móc go zgłosić, co umożliwia korektę danych lub zmianę promptu. Wiele firm stosuje automatyczne walidacje i nadzór człowieka w przypadku kluczowych wyników, z jasnymi zasadami, kiedy AI powinno milczeć lub eskalować pytanie. Regularne monitorowanie działania – analiza dokładności, przegląd błędów – pozwala stopniowo wzmacniać system przeciwko halucynacjom.

W praktyce firmy zauważają, że wewnętrzny agent GPT, jeśli jest ograniczony do mówienia wyłącznie o tym, co wie (czyli bazuje na firmowych danych), znacznie rzadziej „zmyśla”. A jeśli popełni błąd, masz pełen wgląd w jak i dlaczego – co ułatwia doskonalenie systemu. Z czasem taki prywatny GPT staje się coraz mądrzejszy i bardziej godny zaufania, bo nieustannie dostarczasz mu sprawdzonych informacji i eliminujesz błędne odpowiedzi, zanim wyrządzą szkody.

4. Ile kosztuje zbudowanie prywatnej warstwy GPT?

Gdy pojawia się pomysł wdrożenia prywatnego GPT, jedno z pierwszych pytań zarządu brzmi: Ile to będzie kosztować? Odpowiedź zależy od skali i wyborów technicznych, ale możemy przedstawić realistyczne widełki. Ogólnie rzecz biorąc, małe wdrożenie może kosztować około 50 000 USD rocznie, podczas gdy pełnowymiarowe rozwiązanie klasy enterprise to już miliony dolarów rocznie. Przeanalizujmy to dokładniej.

W przypadku pilotażowego projektu lub wdrożenia działowego koszty są stosunkowo niewielkie. Można zintegrować API GPT-4 z kilkuset dokumentami i kilkoma użytkownikami. Koszty obejmują w tym przypadku opłaty za użycie API (OpenAI nalicza opłaty za 1000 tokenów – przy lekkim użyciu to od kilkuset do kilku tysięcy dolarów miesięcznie), koszty integracji i usług chmurowych (baza wektorowa, hosting aplikacji). Wdrożenie można zrealizować w kilka tygodni małym zespołem – przy koszcie rzędu kilkudziesięciu tysięcy USD za robociznę. Jeden z przykładów wdrożenia w małej firmie wskazuje, że koszt integracji wyniósł około 50 000 USD, a koszty operacyjne to ok. 2000 USD miesięcznie. Całkowity koszt pierwszego roku to około 70–80 tys. USD, co sprawia, że wiele średnich firm może sobie pozwolić na test prywatnego GPT.

W przypadku pełnoskalowego wdrożenia na poziomie całej organizacji koszty znacząco rosną. Obsługujesz teraz potencjalnie tysiące użytkowników i zapytań, wymagania dotyczące dostępności 24/7, zaawansowane zabezpieczenia i ciągły rozwój. Według niedawnej analizy branżowej, CIO często niedoszacowują koszty projektów AI nawet dziesięciokrotnie, a rzeczywisty łączny koszt posiadania (TCO) dla rozwiązań GPT klasy enterprise przez 3 lata mieści się w przedziale od 1 do 5 milionów dolarów. Oznacza to średnio 300 000–1,5 miliona USD rocznie przy dużym wdrożeniu. Dlaczego aż tyle? Ponieważ przekształcenie surowego API GPT w stabilną usługę enterprise to wiele ukrytych kosztów poza samymi opłatami za model:

- Rozwój i integracja: Budowa niestandardowej warstwy aplikacyjnej, audyty bezpieczeństwa, integracja z wewnętrznymi źródłami danych, prace nad interfejsem użytkownika. To obejmuje np. logowanie i autoryzację, UI czatu lub integracje z istniejącymi narzędziami, a także ewentualne dostrajanie modelu. Szacunkowo, koszt wdrożenia produkcyjnego może wynosić kilkaset tysięcy USD i więcej, w zależności od złożoności.

- Infrastruktura i usługi chmurowe: Utrzymanie prywatnej warstwy GPT oznacza koszty chmurowe: hosting bazy wektorowej, baz danych dla logów i metadanych, ewentualne serwery GPU (jeśli model jest hostowany wewnętrznie), sieć. Wraz ze wzrostem użycia mogą być potrzebne wyższe plany API lub większe limity. Do tego dochodzą koszty magazynowania i backupu embeddingów i historii czatów – mogą one sięgać dziesiątek tysięcy USD miesięcznie przy dużej skali.

- Utrzymanie i wsparcie: Jak każde krytyczne narzędzie IT, system wymaga bieżącego wsparcia: monitoring, poprawki, optymalizacja promptów, aktualizacja bazy wiedzy, migracje modeli, szkolenia dla użytkowników. Wiele organizacji uwzględnia też cykliczne audyty bezpieczeństwa i zgodności. Szacuje się, że roczne utrzymanie to zwykle 15–20% kosztów wdrożenia. Dodatkowo należy uwzględnić szkolenia pracowników oraz działania change management wspierające adopcję AI – one również generują koszty.

W praktyce duża organizacja (np. globalny bank lub firma z listy Fortune 500), wdrażająca prywatnego GPT w całej strukturze, może bez problemu wydać ponad 1 milion USD już w pierwszym roku, a w kolejnych latach – biorąc pod uwagę wzrost ruchu i koszty utrzymania – jeszcze więcej. Średnie przedsiębiorstwo może zmieścić się w kilku setkach tysięcy dolarów rocznie przy mniejszym zakresie wdrożenia. Rozpiętość jest duża, ale kluczowa myśl brzmi: to nie tylko 2 centy za wywołanie API – kosztuje cała otoczka: inżynieria oprogramowania, bezpieczeństwo, skalowanie, zgodność i integracje.

Dobra wiadomość? Te koszty z czasem spadają dzięki nowym narzędziom i platformom. Dostawcy chmur oferują zarządzane usługi (np. Azure OpenAI z opcjami enterprise, AWS Bedrock), które przejmują część ciężaru. Powstaje też wiele gotowych rozwiązań i startupów typu „ChatGPT dla twoich danych”, które skracają czas wdrożenia. Nadal płacisz za subskrypcje czy usługi, ale czas do osiągnięcia wartości biznesowej jest krótszy. Realistycznie – firma powinna planować co najmniej średni sześciocyfrowy budżet roczny na poważne wdrożenie prywatnego GPT, z założeniem, że pełne, globalne uruchomienie może kosztować kilka milionów. To inwestycja – ale jak pokażemy dalej, taka, która może przynieść bardzo wymierne korzyści strategiczne.

5. Korzyści strategiczne z wdrożenia prywatnej warstwy GPT

Dlaczego warto przechodzić przez cały ten proces i inwestycję, by zbudować własną warstwę AI? Odpowiedź jest prosta – prywatny GPT oferuje strategiczne „trójkątne zwycięstwo” dla dużych organizacji: bezpieczeństwo, wykorzystanie wiedzy i pełna kontrola. Oto najważniejsze korzyści i czynniki wartości:

- Pełna prywatność danych i zgodność z regulacjami: Twój GPT działa za Twoją zaporą sieciową, korzysta z Twoich zaszyfrowanych baz danych – dzięki temu poufne dane nie opuszczają Twojej infrastruktury. Znacznie obniża to ryzyko wycieków i ułatwia zgodność z przepisami (RODO, HIPAA, przepisy finansowe itd.), bo nie wysyłasz danych klientów do zewnętrznych serwisów. Możesz wykazać audytorom, że cała komunikacja AI odbywa się wewnętrznie, z pełnym logowaniem i nadzorem. Już ten jeden aspekt przekonuje wiele firm – zwłaszcza z sektora finansów, ochrony zdrowia i administracji – by wybrać własną AI. Jak ujął to jeden z ekspertów branżowych: zyskujesz szybkość i skalę AI, „zachowując pełną własność i kontrolę nad danymi klientów.”

- Wykorzystanie wiedzy firmowej: Publiczne GPT, takie jak ChatGPT, dysponuje ogólną wiedzą do określonego momentu w czasie, ale nie zna unikalnych danych Twojej firmy – specyfikacji produktów, dokumentacji procesów, raportów klientów itd. Tworząc własną warstwę GPT, odblokowujesz wartość tej zamkniętej wiedzy. Pracownicy mogą błyskawicznie uzyskiwać odpowiedzi z Twoich dokumentów, klienci rozmawiają z AI znającą aktualną ofertę, a decyzje opierają się na wewnętrznych danych, do których AI konkurencji nie ma dostępu. W praktyce przekształcasz rozproszoną wiedzę korporacyjną w interaktywnego, inteligentnego asystenta dostępnego 24/7. Skraca to czas poszukiwań, usprawnia obsługę klienta (szybsze, bardziej trafne odpowiedzi) i ogólnie czyni wiedzę organizacji dostępną i użyteczną w codziennych działaniach.

- Dostosowanie i inteligencja szyta na miarę: Prywatna AI pozwala dostosować zachowanie i „charakter” modelu do Twojej branży i marki. Możesz dostroić bazowy model do żargonu branżowego lub konkretnych zadań, a także ustalić styl odpowiedzi i formaty poprzez prompt engineering. AI może mówić głosem Twojej firmy – formalnym, swobodnym, technicznym – i radzić sobie z pytaniami, których ogólny model by nie zrozumiał. Ta inteligencja dopasowana do kontekstu oznacza trafniejsze i bardziej przydatne odpowiedzi. Przykład: GPT w banku może doskonale rozumieć terminologię finansową i regulacje, a w firmie IT – generować przykłady kodu z użyciem wewnętrznych API. Taki kontekst i dopasowanie sprawia, że AI „rozumie” Twój biznes na głębszym poziomie.

- Niezawodność, kontrola i integracja: Mając własną warstwę GPT, zyskujesz pełną kontrolę nad jej działaniem i integracją. Nie jesteś zdany na kaprysy zewnętrznego API, które może zmienić zasady lub ograniczyć ruch bez ostrzeżenia. Możesz ustawić własne SLA (poziomy dostępności), skalować infrastrukturę według potrzeb, aktualizować model kiedy chcesz (po testach). Co więcej, prywatna AI może być głęboko zintegrowana z Twoimi systemami – np. pobierać dane z CRM, generować raporty, wywoływać wewnętrzne procesy. Ponieważ to Ty ją kontrolujesz, możesz połączyć ją z narzędziami niedostępnymi dla zewnętrznych chatbotów. Taka integracja usprawnia pracę (np. asystent AI, który nie tylko odpowiada, ale od razu wyciąga odpowiedni rekord z bazy). W skrócie: zyskujesz zaufanego „współpracownika” AI, którego możesz rozwijać, monitorować i na którym możesz polegać – jak na każdej kluczowej aplikacji wewnętrznej.

- Przewaga strategiczna: W szerszym ujęciu posiadanie stabilnego, prywatnego rozwiązania AI może być przewagą konkurencyjną. Otwiera to nowe scenariusze – od hiperpersonalizowanej obsługi klienta po inteligentną automatyzację procesów – które wyróżniają Twoją firmę. A wszystko to bez rezygnacji z poufności. Firmy, które nauczą się bezpiecznie i skutecznie wdrażać AI na dużą skalę, prześcigną te, które wciąż się wahają z powodu obaw o bezpieczeństwo. Jest też aspekt rekrutacyjny – pracownicy, szczególnie młodsze pokolenia, oczekują nowoczesnych narzędzi AI w pracy. Zapewnienie dostępu do prywatnego GPT zwiększa produktywność i zadowolenie zespołu, eliminując żmudne wyszukiwanie informacji. To sygnał, że Twoja organizacja jest nowoczesna, ale odpowiedzialna technologicznie. Wszystkie te korzyści przekładają się na realną wartość biznesową: szybsze decyzje, lepsze doświadczenie klienta, niższe koszty operacyjne i silniejsza pozycja na rynku.

Podsumowując, budowa prywatnej warstwy GPT to inwestycja w innowację z pełną kontrolą. Pozwala organizacji korzystać z ogromnego potencjału AI w stylu GPT – zwiększając efektywność, odblokowując wiedzę i usprawniając doświadczenia użytkowników – zachowując jednocześnie pełną kontrolę nad danymi i ryzykiem. W świecie, w którym dane są najcenniejszym zasobem, prywatny GPT pozwala wykorzystać ich potencjał, chroniąc je przed zagrożeniami. Firmy, które wdrożą to rozwiązanie z sukcesem, zyskają bezpieczną, skalowalną i dopasowaną do potrzeb infrastrukturę AI – przewagę w erze sztucznej inteligencji.

Gotowy na budowę własnej warstwy GPT?

Jeśli rozważasz wdrożenie bezpiecznego, skalowalnego asystenta AI dopasowanego do potrzeb Twojej organizacji, sprawdź, jak może pomóc TTMS. Nasi eksperci projektują i wdrażają prywatne warstwy GPT, łącząc innowacyjność z pełną kontrolą nad danymi.

FAQ

Czym różni się prywatna warstwa GPT od korzystania z publicznego ChatGPT?

Prywatna warstwa GPT działa w całości w kontrolowanym środowisku firmy – dane nie są przesyłane do publicznych serwerów ani używane do trenowania zewnętrznych modeli. Masz pełną kontrolę nad tym, jakie informacje trafiają do modelu, kto ma dostęp i jak wygląda logowanie zapytań. W przypadku ChatGPT dane mogą być przechowywane poza Twoją infrastrukturą, co budzi obawy związane z prywatnością, zgodnością z przepisami i bezpieczeństwem.

Czy prywatna warstwa GPT oznacza, że musimy samodzielnie trenować własny model językowy?

Nie. W większości przypadków firmy korzystają z gotowych modeli GPT (np. GPT-4) udostępnianych przez API lub w wersji hostowanej lokalnie. Kluczowe jest dodanie firmowej warstwy wiedzy – za pomocą bazy wektorowej i integracji – a nie trenowanie modelu od zera. Dzięki temu możesz korzystać z potężnych możliwości AI bez kosztów i złożoności związanej z uczeniem modeli.

Czy wdrożenie prywatnego GPT wymaga dużych zasobów IT?

To zależy od skali. Pilotażowe wdrożenie (dla jednego działu lub ograniczonej liczby użytkowników) można zrealizować w kilka tygodni i przy umiarkowanym budżecie. Większe wdrożenia klasy enterprise wymagają zespołu IT, DevOpsów, architektów chmurowych i specjalistów ds. bezpieczeństwa. Dobra wiadomość: coraz więcej gotowych narzędzi i platform (np. Azure OpenAI, LangChain, Weaviate) upraszcza ten proces.

Jak często trzeba aktualizować wiedzę prywatnego GPT?

W architekturze opartej na RAG nie musisz trenować modelu za każdym razem, gdy zmieniają się dane. Wystarczy zaktualizować bazę wektorową – np. dodać nowy dokument, usunąć przestarzały lub nadpisać zmienioną wersję. Możesz to robić ręcznie lub automatycznie (np. codziennie reindeksować nowe pliki). Dzięki temu GPT zawsze odpowiada na podstawie najnowszych informacji.

Czy prywatny GPT może halucynować?

Tak, jak każdy model językowy, GPT może generować odpowiedzi pozornie poprawne, ale nieprawdziwe. Jednak w środowisku prywatnym masz znacznie większą kontrolę nad tym zjawiskiem. Dzięki dostarczaniu kontekstu z wiarygodnych źródeł, inżynierii promptów i monitorowaniu jakości odpowiedzi można znacznie ograniczyć ryzyko halucynacji. W razie potrzeby możliwa jest też recenzja odpowiedzi przez człowieka.

Ile kosztuje wdrożenie prywatnego GPT?

Koszty zależą od skali: małe projekty pilotażowe można zrealizować już za około 50–80 tys. USD rocznie. Pełnoskalowe wdrożenia klasy enterprise to koszt od kilkuset tysięcy do kilku milionów dolarów rocznie. Kluczowe elementy kosztów to: integracja systemów, infrastruktura chmurowa lub lokalna, utrzymanie, bezpieczeństwo, szkolenia i rozwój.