Generatywna sztuczna inteligencja to dla biznesu miecz obusieczny. Najnowsze nagłówki ostrzegają, że firmy coraz częściej „wpadają w tarapaty przez AI”. Głośne przypadki pokazują, jak łatwo o błędy: polski wykonawca stracił kontrakt na utrzymanie dróg po złożeniu dokumentów wygenerowanych przez AI, zawierających fikcyjne dane. W Australii renomowana firma musiała zwrócić część wynagrodzenia rządowego, gdy w raporcie wspieranym przez AI wykryto zmyślony cytat z orzeczenia sądu i odwołania do nieistniejących badań. Prawnicy zostali ukarani za złożenie pisma procesowego zawierającego fikcyjne cytaty z rzekomych orzeczeń wygenerowane przez ChatGPT. Z kolei fintech, który zastąpił setki pracowników chatbotami, odnotował gwałtowny spadek satysfakcji klientów i był zmuszony ponownie zatrudnić ludzi. Te przestrogi pokazują realne ryzyka – od „halucynacji” AI i błędów po odpowiedzialność prawną, straty finansowe i utratę reputacji. Dobra wiadomość jest taka, że takich pułapek można uniknąć. Niniejszy ekspercki przewodnik przedstawia praktyczne kroki prawne, technologiczne i operacyjne, które pomogą Twojej firmie korzystać z AI odpowiedzialnie i bezpiecznie – tak, by wprowadzać innowacje bez ryzyka wpadki.

1. Zrozumienie ryzyk związanych z generatywną sztuczną inteligencją w biznesie

Zanim przejdziemy do rozwiązań, warto zidentyfikować główne ryzyka związane z AI, które już doprowadziły wiele firm do problemów. Świadomość potencjalnych zagrożeń pozwala zawczasu wprowadzić skuteczne zabezpieczenia.

- „Halucynacje” AI (fałszywe wyniki): Generatywna sztuczna inteligencja potrafi tworzyć informacje brzmiące wiarygodnie, ale całkowicie nieprawdziwe. Przykładowo, jedno z narzędzi AI wymyśliło fikcyjne interpretacje prawne i dane w dokumentacji przetargowej – te „halucynacje” wprowadziły komisję w błąd i doprowadziły do odrzucenia oferty. Podobny przypadek miał miejsce w Deloitte, gdzie raport wygenerowany przez AI zawierał nieistniejący cytat z orzeczenia sądu oraz odwołania do badań, które nigdy nie powstały. Opieranie się na niezweryfikowanych wynikach AI może prowadzić do błędnych decyzji i utraty kontraktów.

- Nieprawidłowe raporty i analizy: Gdy pracownicy traktują wyniki AI jako bezbłędne, błędy mogą przedostać się do raportów biznesowych, analiz finansowych czy treści komunikacyjnych. W przypadku Deloitte brak należytej kontroli nad raportem stworzonym przez AI zakończył się publicznym zawstydzeniem i koniecznością zwrotu części wynagrodzenia. AI to potężne narzędzie, ale – jak zauważył jeden z ekspertów – „AI nie mówi prawdy, tylko tworzy odpowiedzi”. Bez odpowiednich zabezpieczeń może więc generować nieścisłości.

- Odpowiedzialność prawna i pozwy: Korzystanie z AI bez poszanowania prawa i zasad etyki może skończyć się pozwami. Głośny przykład to nowojorscy prawnicy, którzy zostali ukarani grzywną za złożenie pisma procesowego pełnego fikcyjnych cytatów wygenerowanych przez ChatGPT. Firmy mogą też narazić się na pozwy o naruszenie praw autorskich lub ochrony danych osobowych, jeśli AI wykorzysta dane w niewłaściwy sposób. W Polsce organy nadzoru jasno wskazują, że przedsiębiorstwo ponosi odpowiedzialność za wszelkie wprowadzające w błąd informacje – nawet jeśli pochodzą one z AI. Innymi słowy, nie można obarczyć winą algorytmu – odpowiedzialność prawna zawsze spoczywa na człowieku.

- Straty finansowe: Błędy wynikające z niekontrolowanego działania AI mogą bezpośrednio uderzyć w wyniki finansowe. Nieprawidłowa analiza wygenerowana przez AI może prowadzić do nietrafionej inwestycji lub błędu strategicznego. Zdarzało się, że firmy traciły intratne kontrakty lub musiały zwracać wynagrodzenia z powodu błędów wprowadzonych przez sztuczną inteligencję. Prawie 60% pracowników przyznaje, że popełniło błędy związane z użyciem AI w pracy – ryzyko kosztownych pomyłek jest więc bardzo realne, jeśli nie istnieją odpowiednie mechanizmy kontroli.

- Utrata reputacji: Gdy błędy popełnione przez AI wychodzą na jaw, podważają zaufanie klientów i partnerów biznesowych. Globalna firma doradcza nadwerężyła swój wizerunek po ujawnieniu, że w przekazanym raporcie znalazły się błędy wygenerowane przez sztuczną inteligencję. Po stronie konsumenckiej podobne wyzwania napotkał Starbucks – klienci sceptycznie zareagowali na pomysł „robotycznych baristów”, co zmusiło markę do zapewnień, że AI ma wspierać ludzi, a nie ich zastępować. Z kolei fintech Klarna, który chwalił się w pełni zautomatyzowaną obsługą klienta, musiał się z tego wycofać, przyznając, że jakość usług ucierpiała, a wizerunek firmy został wyraźnie nadszarpnięty. Wystarczy jedna wpadka z udziałem AI, by reputacja budowana latami znalazła się na krawędzi.

Ryzyka te są realne, ale można nimi skutecznie zarządzać. W kolejnych częściach przedstawiamy praktyczny plan działania, który pozwala w pełni wykorzystać potencjał sztucznej inteligencji, jednocześnie unikając pułapek, w jakie wpadły inne firmy.

2. Prawne i kontraktowe zabezpieczenia odpowiedzialnego wykorzystania AI

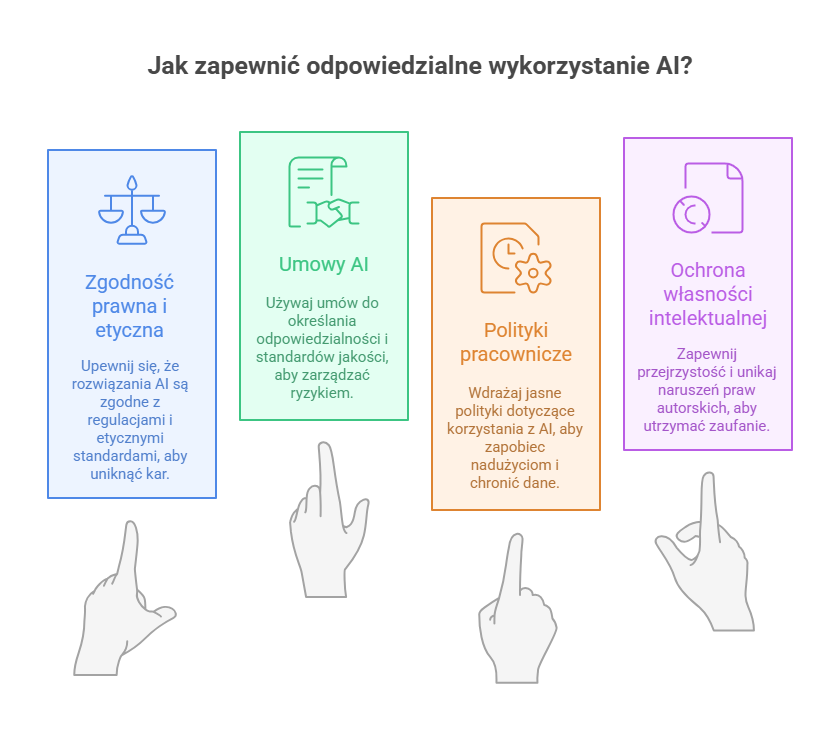

2.1. Działaj w granicach prawa i etyki

Zanim wdrożysz AI w procesach operacyjnych, upewnij się, że rozwiązanie jest zgodne ze wszystkimi obowiązującymi regulacjami. Przepisy o ochronie danych osobowych, takie jak RODO, obowiązują także w przypadku wykorzystania AI – wprowadzanie danych klientów do systemów sztucznej inteligencji musi respektować ich prawo do prywatności. W niektórych branżach (np. finansowej czy medycznej) obowiązują też dodatkowe ograniczenia dotyczące użycia AI. Warto śledzić nowe regulacje, takie jak unijny AI Act, który wprowadzi obowiązek zapewnienia przejrzystości, bezpieczeństwa i ludzkiego nadzoru nad systemami AI. Brak zgodności może skutkować dotkliwymi karami finansowymi lub zakazem używania danego systemu. Dlatego przy wdrażaniu AI należy jak najwcześniej zaangażować dział prawny lub dział compliance, by zidentyfikować i zminimalizować potencjalne ryzyka.

2.2. Wykorzystuj umowy do określenia odpowiedzialności za AI

Zawierając umowy na dostawę rozwiązań AI lub współpracę z dostawcami technologii, uwzględnij w nich zapisy ograniczające ryzyko. Określ standardy jakości i procedury postępowania w przypadku błędnych wyników generowanych przez AI. Jeśli system dostarcza treści lub podejmuje decyzje, wprowadź obowiązek weryfikacji przez człowieka oraz gwarancję ochrony przed rażąco błędnymi wynikami. Wyraźnie wskaż, kto ponosi odpowiedzialność w przypadku szkód lub naruszeń prawa spowodowanych przez AI. Zadbaj też, by dostawca był zobowiązany do ochrony Twoich danych – np. zakazu wykorzystywania ich do trenowania własnych modeli – oraz przestrzegania przepisów prawa. Tego rodzaju zapisy nie wyeliminują błędów, ale zapewnią jasne zasady i podstawę prawną do działania, jeśli coś pójdzie nie tak.

2.3. Uwzględnij zasady korzystania z AI w politykach pracowniczych

Kodeks etyki lub polityka IT firmy powinny wprost odnosić się do zasad korzystania z AI. Określ, co pracownicy mogą, a czego nie powinni robić z użyciem narzędzi AI. Na przykład, zabroń wprowadzania poufnych lub wrażliwych danych biznesowych do publicznie dostępnych modeli, aby uniknąć wycieku informacji – chyba że korzystają z zatwierdzonych, bezpiecznych kanałów. Wymagaj, aby każda treść wygenerowana przez AI była weryfikowana pod względem poprawności i adekwatności. Podkreśl, że wyniki generowane automatycznie to sugestie, a nie ostateczne decyzje – odpowiedzialność za efekt pracy zawsze spoczywa na człowieku. Egzekwowanie takich zasad ogranicza ryzyko sytuacji, w której pracownik nieświadomie doprowadza do kryzysu prawnego lub wizerunkowego. To szczególnie istotne, ponieważ badania pokazują, że wielu pracowników korzysta z AI bez wyraźnych wytycznych – niemal połowa ankietowanych nie ma pewności, czy ich działania z wykorzystaniem AI są w ogóle dozwolone. Jasna polityka wewnętrzna chroni zarówno pracowników, jak i samą organizację.

2.4. Chroń własność intelektualną i zapewnij przejrzystość

Z prawnego i etycznego punktu widzenia firmy muszą zwracać uwagę na pochodzenie materiałów generowanych przez AI. Jeśli Twoje narzędzie tworzy teksty lub obrazy, upewnij się, że nie dochodzi do plagiatu ani naruszenia praw autorskich. Korzystaj z modeli AI licencjonowanych do użytku komercyjnego lub takich, które jasno wskazują, na jakich danych były trenowane. Gdzie to zasadne, ujawniaj, że treść powstała z pomocą AI – np. gdy raport lub wpis w mediach społecznościowych został współtworzony przez AI, warto to zaznaczyć dla przejrzystości i zaufania. W umowach z klientami lub użytkownikami rozważ stosowne zastrzeżenia, że niektóre wyniki wygenerowała AI i mogą nie mieć gwarancji – jeśli ma to zastosowanie. Celem jest uniknięcie zarzutów wprowadzania w błąd lub naruszeń praw własności intelektualnej. Zawsze pamiętaj: jeśli narzędzie AI dostarcza treść, traktuj ją jak materiał od nieznanego autora – przed publikacją przeprowadź należytą staranność. Tak samo postępuj z wynikami AI.

3. Dobre praktyki ograniczania błędów AI

3.1. Sprawdzaj wyniki AI – najlepiej z udziałem człowieka lub niezależnego systemu kontroli

Najprostszym zabezpieczeniem przed błędami AI jest ludzki nadzór. Nie dopuszczaj, by krytyczne decyzje ani komunikacja zewnętrzna opierały się wyłącznie na AI. Jak stwierdzono po incydencie z Deloitte: „Odpowiedzialność nadal spoczywa na profesjonaliście, który z niej korzysta… sprawdź wynik i zastosuj własny osąd, zamiast kopiować to, co wypluwa system”. W praktyce wprowadź etap kontroli: jeśli AI przygotuje analizę lub e-mail, niech kompetentna osoba to zweryfikuje. Jeśli AI dostarcza dane lub kod, przetestuj je lub porównaj z innym źródłem. Niektóre firmy stosują podwójną warstwę AI – jedna generuje, druga ocenia – ale ostatecznie akceptację musi dać człowiek. Ten nadzór to ostatnia linia obrony przed halucynacjami, uprzedzeniami lub błędami kontekstu.

3.2. Testuj i dostrajaj swoje systemy AI przed pełnym wdrożeniem

Nie powierzaj modelowi AI od razu zadań krytycznych bez testów w środowisku sandbox. Sprawdź działanie na realnych scenariuszach lub danych historycznych. Czy narzędzie generatywne pozostaje przy faktach w Twojej domenie, czy zaczyna „fantazjować”, gdy ma wątpliwości? Czy system decyzyjny przejawia stronniczość lub nietypowe błędy dla pewnych wejść? Pilotaż na małą skalę ujawni tryby awarii. Następnie dostrój system – może to oznaczać fine-tuning na danych własnych dla poprawy trafności lub ostrzejsze parametry. Jeśli wdrażasz chatbota do obsługi klienta, przetestuj go na szerokim zakresie pytań (także narożnych) i poddaj ocenie zespołu. Skaluj dopiero, gdy spełnia standardy dokładności i tonu. A nawet wtedy – stale monitoruj (patrz niżej).

3.3. Dostarczaj AI wyselekcjonowane dane i kontekst

Jednym z powodów „rozjeżdżania się” wyników AI jest brak kontekstu lub trening na mało wiarygodnych danych. Możesz to ograniczyć. Jeśli AI ma odpowiadać na pytania lub tworzyć raporty w Twojej domenie, rozważ podejście typu retrieval augmented: zapewnij bazę zweryfikowanych informacji (dokumentację produktu, bazę wiedzy, zbiory polityk), by model czerpał z prawidłowych źródeł zamiast zgadywać. To znacząco redukuje halucynacje. Analogicznie, filtruj dane treningowe modeli in-house, usuwając oczywiste nieścisłości lub uprzedzenia. Celem jest możliwie „nauczyć” AI prawdy. Pamiętaj: gdy pozwoli się AI wypełniać luki, zrobi to z pełnym przekonaniem. Zawężając zakres do źródeł wysokiej jakości, ograniczasz pole błędu.

3.4. Wprowadź dodatkowe kontrole dla wrażliwych lub wysokostawkowych wyników

Nie wszystkie potknięcia AI są równe – literówka w notatce wewnętrznej to co innego niż fałszywe twierdzenie w raporcie finansowym. Zidentyfikuj, które wyniki AI w Twojej firmie są „wysokiego ryzyka” (np. treści publiczne, dokumenty prawne, analizy finansowe). Tam dodaj dodatkowy nadzór. Może to być wielostopniowa akceptacja (kilku ekspertów zatwierdza) lub użycie narzędzi wykrywających anomalie. Przykładowo: automatyczne fact-checkery i moderacja treści mogą wstępnie oznaczać wątpliwe twierdzenia lub niestosowny język. Skonfiguruj też progi: jeśli system AI sygnalizuje niską pewność lub wychodzi poza zakres, powinien automatycznie przekazać sprawę człowiekowi. Wielu dostawców oferuje ustawienia progów pewności i reguły eskalacji – wykorzystaj je, aby powstrzymać niezweryfikowane, podejrzane wyniki.

3.5. Monitoruj i aktualizuj swoje systemy AI

Traktuj model AI jak żywy organizm, który wymaga regularnej konserwacji. Obserwuj jego wydajność w czasie – czy liczba błędów nie rośnie? Czy pojawiają się nowe typy zapytań, z którymi sobie nie radzi? Regularnie przeprowadzaj audyty jakości – np. comiesięczne przeglądy wyników lub losową weryfikację części interakcji. Aktualizuj także sam model: jeśli system powtarza ten sam błąd, przeucz go na poprawnych danych lub ulepsz prompt. Gdy zmieniają się przepisy lub polityka firmy, zadbaj, by AI uwzględniała nowe zasady (np. poprzez aktualizację baz wiedzy lub reguł). Ciągłe audyty pomagają wykryć problemy, zanim przerodzą się w poważny incydent. W przypadku zastosowań wrażliwych warto zaprosić zewnętrznych audytorów lub korzystać z narzędzi testujących uprzedzenia, by mieć pewność, że AI pozostaje rzetelna i bezstronna. Celem jest, by nigdy nie traktować AI jako systemu „ustaw i zapomnij” – tak jak serwisuje się kluczowe maszyny, tak samo należy regularnie serwisować modele AI.

4. Strategie operacyjne i nadzór człowieka

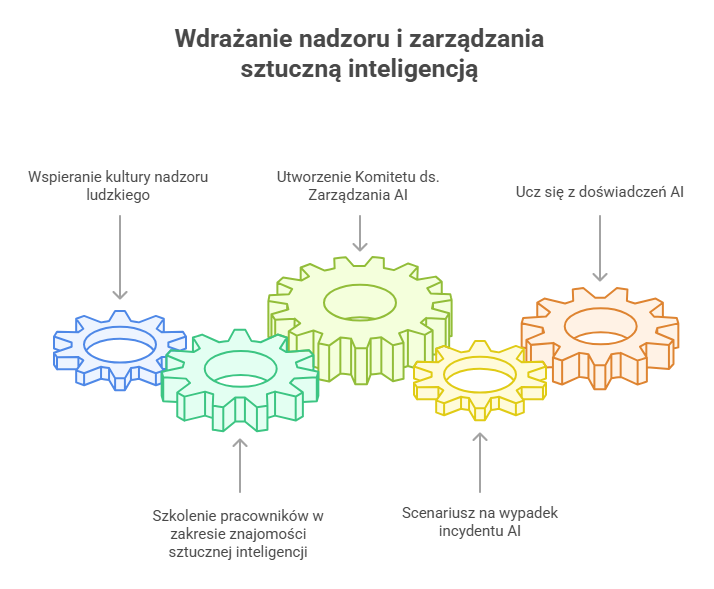

4.1. Buduj kulturę ludzkiego nadzoru

Bez względu na stopień zaawansowania Twojej AI, nadzór człowieka powinien być standardem. To podejście zaczyna się od góry – kierownictwo powinno podkreślać, że AI ma wspierać, a nie zastępować ludzki osąd. Zachęcaj pracowników, by traktowali AI jak młodszego analityka lub „współpilota” – pomocnego, ale wymagającego kontroli. Przykładowo, Starbucks wprowadził asystenta AI dla baristów, ale wyraźnie zaznaczył, że to narzędzie wspierające obsługę, a nie „robot-barista”. Takie komunikaty kształtują oczekiwanie, że ostateczna jakość pozostaje w rękach człowieka. W codziennej pracy wprowadź obowiązek akceptacji: np. menedżer powinien zatwierdzać każde opracowanie wygenerowane przez AI dla klienta. Dzięki wbudowaniu nadzoru w procesy znacząco zmniejszasz ryzyko niekontrolowanych błędów AI.

4.2. Szkol pracowników z zasad korzystania z AI

Nawet osoby technicznie biegłe nie zawsze rozumieją ograniczenia sztucznej inteligencji. Organizuj szkolenia wyjaśniające, co AI potrafi, a czego nie. Objaśnij zjawisko „halucynacji” AI, używając konkretnych przykładów – np. sprawy prawników, którzy przedstawili fikcyjne sprawy sądowe stworzone przez ChatGPT. Naucz zespoły rozpoznawać błędy AI – np. weryfikować źródła danych, identyfikować zbyt ogólne lub „dziwne” odpowiedzi. Szkolenia powinny też obejmować politykę firmy dotyczącą korzystania z AI: jak postępować z danymi, z jakich narzędzi można korzystać, jak wygląda procedura weryfikacji wyników. Im bardziej AI przenika do codziennej pracy, tym ważniejsze, by każdy rozumiał wspólną odpowiedzialność za jej właściwe użycie. Zachęcaj pracowników, by zgłaszali niepokojące zachowania AI i bez obaw prosili o dodatkową weryfikację przez człowieka. Świadomość na pierwszej linii to Twój najskuteczniejszy system wczesnego ostrzegania przed problemami.

4.3. Powołaj zespół lub osobę odpowiedzialną za zarządzanie AI

Tak jak firmy mają oficerów ds. bezpieczeństwa czy zespoły compliance, warto wyznaczyć osoby odpowiedzialne za nadzór nad AI. Może to być formalny Komitet Etyki lub Zarządzania AI spotykający się cyklicznie, albo tzw. „AI champion” – menedżer projektu monitorujący działanie konkretnego systemu. Zespół taki powinien ustalać standardy korzystania z AI, oceniać projekty wysokiego ryzyka przed wdrożeniem i informować kierownictwo o bieżących inicjatywach. Powinien też śledzić zmiany w regulacjach i najlepszych praktykach branżowych, aktualizując firmowe procedury. Kluczowe jest skupienie odpowiedzialności i wiedzy w jednym miejscu, zamiast pozwalać, by AI rozwijała się w firmie chaotycznie. Taki zespół pełni funkcję bezpiecznika, który dba o przestrzeganie zasad i rekomendacji zawartych w tym przewodniku.

4.4. Planuj scenariusze awarii i reagowania na błędy AI

Uwzględnij ryzyka związane z AI w planach ciągłości działania i reagowania na incydenty. Zadawaj pytania „co jeśli”: co jeśli chatbot w obsłudze klienta udzieli obraźliwej lub błędnej odpowiedzi, a sprawa trafi do mediów? Co jeśli pracownik przypadkowo ujawni dane za pomocą narzędzia AI? Planowanie z wyprzedzeniem pozwala stworzyć procedury – np. gotowe oświadczenie PR na wypadek błędów AI, by móc zareagować szybko i transparentnie. Określ też plan wycofania systemu – kto ma prawo zatrzymać działanie AI lub przywrócić procesy manualne, jeśli system zachowuje się nieprzewidywalnie. W ramach przygotowań przeprowadzaj symulacje takich scenariuszy, jak ćwiczenia ewakuacyjne. Lepiej być gotowym, niż zaskoczonym. Firmy, które skutecznie przeszły przez kryzysy technologiczne, łączy jedno: szybka i odpowiedzialna reakcja. W przypadku AI szczere, szybkie działania naprawcze mogą zamienić potencjalny kryzys w dowód wiarygodności i dojrzałości organizacyjnej.

4.5. Ucz się na cudzych i własnych doświadczeniach

Śledź studia przypadków i doniesienia o zastosowaniach AI w biznesie – zarówno tych udanych, jak i tych zakończonych porażką. Przypadki opisane wcześniej (od utraty kontraktu przez Exdrog po zwrot w strategii Klarna) niosą cenne lekcje. Regularnie analizuj, co poszło nie tak w innych firmach, i pytaj: „Czy to mogłoby zdarzyć się u nas? Jak byśmy zareagowali?”. Równie ważne są analizy wewnętrzne – jeśli w Twojej organizacji wystąpił błąd lub „bliski incydent” związany z AI, omów go, zrozum przyczynę i ulepsz proces. Wprowadź kulturę otwartości – bez obwiniania. Pracownicy powinni czuć się bezpiecznie, zgłaszając problemy wynikające z nadmiernego zaufania do AI, bo tylko wtedy organizacja może się uczyć. Stałe uczenie się na błędach własnych i cudzych buduje odporność i pozwala skutecznie poruszać się po zmieniającym się świecie sztucznej inteligencji.

5. Podsumowanie: bezpieczna i mądra adaptacja AI

Technologia sztucznej inteligencji w 2026 roku jest bardziej dostępna niż kiedykolwiek wcześniej – a wraz z tym rośnie odpowiedzialność za jej właściwe wykorzystanie. Firmy, które popadają w tarapaty przez AI, robią to zwykle nie dlatego, że technologia jest zła, lecz dlatego, że używają jej bezrefleksyjnie lub bez nadzoru. Jak pokazują przykłady, ślepe zaufanie do wyników AI lub całkowite zastąpienie ludzkiego osądu prowadzi prosto do problemów. Z kolei organizacje, które łączą innowacje AI z solidnymi mechanizmami kontroli, czerpią korzyści bez ryzyka negatywnego rozgłosu.

Zasadniczą wartością jest odpowiedzialność – niezależnie od tego, jaki system wdrażasz, to firma ponosi odpowiedzialność za jego skutki. Stosując opisane tu zabezpieczenia prawne, techniczne i organizacyjne, możesz bezpiecznie integrować AI z działalnością operacyjną. Sztuczna inteligencja może zwiększać efektywność, odkrywać nowe możliwości i wspierać rozwój – pod warunkiem, że pozostaje pod odpowiedzialnym nadzorem. Dzięki przemyślanej strategii Twoja firma może uczynić z AI potężnego sojusznika, a nie źródło ryzyka.

W gruncie rzeczy, recepta na to, „jak nie wpaść w tarapaty przez AI”, sprowadza się do jednej zasady: wprowadzaj innowacje odważnie, ale zarządzaj nimi rozważnie. Przyszłość należy do tych, którzy potrafią robić jedno i drugie.

Chcesz bezpiecznie i strategicznie wdrożyć AI? Sprawdź, jak TTMS pomaga firmom w odpowiedzialnym i skutecznym wykorzystaniu sztucznej inteligencji: ttms.com/ai-solutions-for-business.

FAQ

Czym są „halucynacje” AI i jak można im zapobiec w firmie?

„Halucynacje” AI to sytuacje, w których generatywna sztuczna inteligencja tworzy treści, które brzmią wiarygodnie, ale są całkowicie nieprawdziwe. AI nie kłamie celowo – po prostu uzupełnia luki w wiedzy na podstawie wzorców, co może prowadzić do wymyślonych danych, cytatów czy faktów. Przykładem może być sytuacja, gdy AI wygenerowała fikcyjne interpretacje podatkowe lub zmyślone orzeczenia sądowe, które trafiły do dokumentów przetargowych. Aby uniknąć takich błędów, należy zawsze weryfikować treści stworzone przez AI – traktować je jak wstępny szkic, a nie ostateczną wersję. Warto też korzystać z modeli, które pozwalają podłączyć zaufane źródła wiedzy (Retrieval Augmented Generation), dzięki czemu AI opiera się na prawdziwych danych, a nie „zgaduje”. Zasada jest prosta: żadna treść wygenerowana przez AI nie powinna być publikowana bez ludzkiej kontroli.

Jakie przepisy regulują wykorzystanie AI w 2026 roku?

W 2026 roku kluczowym aktem prawnym w Europie jest AI Act, czyli unijne rozporządzenie dotyczące sztucznej inteligencji. Nakłada ono obowiązki w zakresie przejrzystości, bezpieczeństwa i nadzoru człowieka nad systemami AI, a także wprowadza kategorie ryzyka dla różnych zastosowań. Równocześnie obowiązują przepisy o ochronie danych osobowych (RODO), które zabraniają przetwarzania danych bez odpowiednich podstaw prawnych – dotyczy to również danych wprowadzanych do narzędzi AI. Poza UE warto zwrócić uwagę na lokalne regulacje dotyczące ochrony konsumentów i własności intelektualnej. W Polsce, podobnie jak w innych krajach Unii, firma ponosi pełną odpowiedzialność za skutki działania AI, nawet jeśli błąd wynikał z decyzji algorytmu. Dlatego nie można „zrzucić winy na maszynę” – odpowiedzialność zawsze pozostaje po stronie człowieka i organizacji.

Czy AI zastąpi ludzi w firmie? Jak znaleźć właściwą równowagę?

AI nie powinna być traktowana jako zastępstwo człowieka, lecz jako jego wsparcie. Największe sukcesy odnoszą organizacje, które łączą automatyzację z ludzką kontrolą. Przykładowo fintech Klarna po eksperymencie z chatbotami obsługującymi klientów w pełni automatycznie musiał ponownie zatrudnić część pracowników, gdy spadła jakość obsługi. Wniosek jest prosty: AI świetnie radzi sobie z rutyną, ale to człowiek gwarantuje empatię, kontekst i odpowiedzialność. Najlepszym rozwiązaniem jest model „AI + człowiek”, w którym sztuczna inteligencja wspiera ludzi w powtarzalnych zadaniach, a oni zajmują się tym, co wymaga osądu i doświadczenia.

Co powinno znaleźć się w wewnętrznej polityce korzystania z AI?

Każda firma korzystająca z AI powinna opracować jasne wytyczne regulujące sposób używania tej technologii przez pracowników. W polityce należy określić:

- które narzędzia AI są zatwierdzone do użytku służbowego,

- jakie dane można, a jakich nie wolno wprowadzać do systemów AI (np. danych osobowych, tajemnic handlowych),

- obowiązek weryfikacji wyników generowanych przez AI,

- zasady etycznego wykorzystania treści, w tym unikanie naruszeń praw autorskich,

- odpowiedzialność użytkownika za wykorzystanie wyników AI.

Taka polityka chroni zarówno firmę, jak i pracowników przed nieświadomym naruszeniem przepisów lub zasad etyki. Warto też zapewnić pracownikom szkolenia z zakresu „AI literacy” – umiejętnego, świadomego korzystania ze sztucznej inteligencji.

Jak chronić dane firmowe i bezpieczeństwo informacji przy korzystaniu z AI?

Bezpieczeństwo danych to jeden z największych obszarów ryzyka przy wdrażaniu AI. Aby uniknąć wycieków lub nadużyć:

- używaj biznesowych wersji narzędzi AI (np. ChatGPT Enterprise), które gwarantują poufność danych,

- nie wprowadzaj do publicznych modeli danych wrażliwych, osobowych ani firmowych,

- ogranicz dostęp AI tylko do niezbędnych zasobów (zasada „least privilege”),

- regularnie audytuj sposób wykorzystania AI w organizacji,

- weryfikuj dostawców pod kątem bezpieczeństwa (certyfikaty, procedury, zgodność z RODO).

Pamiętaj, że dane wprowadzone do otwartych modeli mogą zostać wykorzystane do dalszego treningu – czyli w praktyce przestać być poufne. Dlatego każda interakcja z AI powinna być traktowana jak potencjalne udostępnienie informacji na zewnątrz.