Unijny Akt o Sztucznej Inteligencji (EU AI Act) wchodzi w krytyczną fazę wdrażania w 2025 roku. Niniejszy artykuł to kontynuacja naszego opracowania z lutego 2025, które przedstawiało podstawy tej przełomowej regulacji. Teraz przyglądamy się najnowszym zmianom: dopracowanemu kodeksowi postępowania dla modeli sztucznej inteligencji ogólnego przeznaczenia (GPAI), uprawnieniom egzekucyjnym nowego European AI Office, harmonogramowi wdrożenia od sierpnia 2025 do 2027 roku, pierwszym reakcjom liderów rynku takich jak xAI, Meta czy Google oraz praktycznym wskazówkom dla biznesu w zakresie zgodności i ochrony reputacji.

Kodeks postępowania dla AI ogólnego przeznaczenia: dobrowolne ramy zgodności

Jednym z najważniejszych kamieni milowych ostatnich miesięcy jest publikacja Kodeksu postępowania dla AI ogólnego przeznaczenia (GPAI) – obszernego zestawu dobrowolnych wytycznych, które mają pomóc dostawcom AI w spełnieniu wymogów EU AI Act wobec modeli bazowych. Ogłoszony 10 lipca 2025 r., kodeks został opracowany przez niezależnych ekspertów w ramach procesu wielostronnych konsultacji i zatwierdzony przez nowo utworzone European AI Office. Stanowi on niewiążące ramy regulacyjne, które obejmują trzy kluczowe obszary: przejrzystość, poszanowanie praw autorskich oraz bezpieczeństwo i niezawodność zaawansowanych modeli AI. W praktyce oznacza to, że dostawcy GPAI (np. twórcy dużych modeli językowych czy systemów generatywnych) otrzymują konkretne narzędzia i wzory dokumentacji, aby ujawniać wymagane informacje, przestrzegać prawa autorskiego i ograniczać ryzyka systemowe związane z najbardziej zaawansowanymi modelami.

Choć przystąpienie do kodeksu jest dobrowolne, daje ono istotną przewagę: „domniemanie zgodności” z AI Act. Innymi słowy, firmy, które podpiszą kodeks, uznawane są za spełniające obowiązki wynikające z regulacji dotyczących GPAI, co zapewnia im większą pewność prawną i mniejsze obciążenia administracyjne podczas audytów czy kontroli. To podejście typu „marchewka i kij” silnie zachęca kluczowych dostawców AI do udziału. Już w ciągu kilku tygodni od publikacji kodeksu dziesiątki firm technologicznych – w tym Amazon, Google, Microsoft, OpenAI, Anthropic i inne – zgłosiły się jako sygnatariusze, sygnalizując gotowość do stosowania najlepszych praktyk. Zatwierdzenie kodeksu przez Komisję Europejską oraz nową Radę ds. AI (skupiającą regulatorów z państw członkowskich) w sierpniu 2025 dodatkowo ugruntowało jego pozycję jako autorytatywnego narzędzia zgodności. Ci, którzy zdecydują się nie przystępować do kodeksu, muszą liczyć się z ostrzejszą kontrolą – będą musieli samodzielnie udowodnić regulatorom, w jaki sposób ich własne rozwiązania wypełniają wszystkie wymogi EU AI Act.

European AI Office: centralny organ nadzoru i egzekwowania

Aby nadzorować i egzekwować przepisy EU AI Act, Komisja Europejska powołała w 2024 roku dedykowany organ regulacyjny – European AI Office. Funkcjonujący w ramach DG CONNECT urząd pełni rolę ogólnoeuropejskiego centrum kompetencji i koordynacji nadzoru nad AI. Jego głównym zadaniem jest monitorowanie, kontrolowanie i egzekwowanie zgodności z przepisami – szczególnie w odniesieniu do modeli ogólnego przeznaczenia – we wszystkich 27 państwach członkowskich. AI Office został wyposażony w szerokie uprawnienia: może prowadzić oceny modeli AI, żądać dokumentacji technicznej i informacji od dostawców, nakazywać środki naprawcze w przypadku niezgodności, a w poważnych sytuacjach rekomendować sankcje finansowe. Co istotne, AI Office odpowiada także za opracowywanie i aktualizację kodeksów postępowania (takich jak GPAI Code) oraz pełni funkcję sekretariatu nowej Europejskiej Rady ds. AI, która koordynuje działania regulatorów krajowych.

W praktyce European AI Office działa ramię w ramię z władzami krajowymi, aby zapewnić spójne egzekwowanie prawa. Jeśli model AI ogólnego przeznaczenia budzi podejrzenie niezgodności lub stwarza nieprzewidziane ryzyka systemowe, urząd może wszcząć dochodzenie we współpracy z organami nadzoru rynku w państwach członkowskich. Może również inicjować wspólne kontrole transgraniczne, gdy ten sam system jest wdrażany w wielu krajach, aby zagwarantować, że problemy takie jak algorytmiczne uprzedzenia czy zagrożenia bezpieczeństwa są rozwiązywane jednolicie. Poprzez wymianę informacji i wytyczne dla regulatorów krajowych (podobnie jak w przypadku Europejskiej Rady Ochrony Danych przy RODO), AI Office ma przeciwdziałać fragmentacji regulacyjnej. Jako centralny ośrodek pełni też rolę reprezentanta UE w międzynarodowych dyskusjach o regulacjach AI oraz nadzoruje inicjatywy sprzyjające innowacjom, takie jak piaskownice regulacyjne czy programy wsparcia dla MŚP. Dla liderów biznesu oznacza to pojawienie się europejskiego „jednego okienka” w zakresie zgodności z AI – firmy mogą oczekiwać, że AI Office będzie wydawać wytyczne, obsługiwać część rejestracji czy zatwierdzeń oraz prowadzić kluczowe działania egzekucyjne wobec systemów AI, które wykraczają poza granice jednego państwa.

Harmonogram wdrażania AI Act: sierpień 2025 – 2027

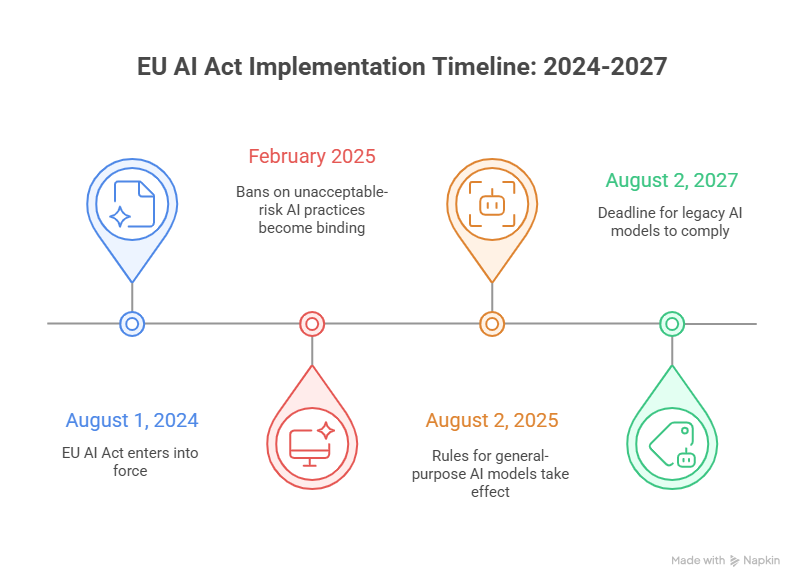

EU AI Act wprowadzany jest etapami, a kluczowe obowiązki pojawiają się w latach 2025-2027. Regulacja formalnie weszła w życie 1 sierpnia 2024 r., ale nie wszystkie przepisy zaczęły obowiązywać od razu. Zamiast tego przyjęto harmonogram stopniowego wdrażania, aby dać organizacjom czas na dostosowanie. Pierwszy ważny kamień milowy pojawił się już po sześciu miesiącach: od lutego 2025 r. zakazane praktyki AI uznane za „nieakceptowalne ryzyko” (np. systemy punktacji społecznej, manipulacja osobami szczególnie podatnymi, czy zdalna identyfikacja biometryczna w czasie rzeczywistym w przestrzeni publicznej na potrzeby organów ścigania) stały się nielegalne. Każdy system AI mieszczący się w tych kategoriach musiał zostać wstrzymany lub wycofany z rynku UE, co stanowiło pierwsze realne sprawdzian regulacji.

Kolejny ważny etap przypada na 2 sierpnia 2025 r., kiedy zaczynają obowiązywać przepisy dotyczące modeli AI ogólnego przeznaczenia. Od tego dnia każdy nowy model bazowy lub duży system AI (spełniający definicję GPAI) wprowadzany na rynek unijny musi być zgodny z wymogami AI Act w zakresie przejrzystości, bezpieczeństwa i ochrony praw autorskich. Oznacza to m.in. obowiązek dostarczania szczegółowej dokumentacji technicznej regulatorom i użytkownikom, ujawnianie danych użytych do trenowania (przynajmniej w formie podsumowania) oraz wdrożenie działań ograniczających ryzyka związane z zaawansowanymi modelami. Warto zauważyć, że dla modeli już obecnych na rynku przed sierpniem 2025 r. przewidziano okres przejściowy – dostawcy mają czas do 2 sierpnia 2027 r., aby w pełni dostosować te rozwiązania i ich dokumentację do wymogów prawa. Dwuletnie okno ma ułatwić aktualizację systemów już wdrożonych i wdrożenie dodatkowych zabezpieczeń czy dokumentacji. W tym okresie narzędzia dobrowolne, takie jak Kodeks postępowania GPAI, pełnią rolę pomostu, pomagając firmom wyrównać kurs z regulacjami, zanim w 2027 r. zostaną opublikowane ostateczne zharmonizowane standardy techniczne.

Pozostałe obowiązki AI Act będą wchodzić w życie w latach 2026-2027. Do sierpnia 2026 r. (dwa lata od wejścia w życie regulacji) większość przepisów stanie się w pełni stosowana, w tym wymagania wobec systemów wysokiego ryzyka wykorzystywanych w takich obszarach jak opieka zdrowotna, finanse, zatrudnienie czy infrastruktura krytyczna. Te systemy muszą przechodzić oceny zgodności, prowadzić rejestry działania, zapewniać nadzór człowieka i spełniać inne rygorystyczne kryteria. Mają one jednak nieco więcej czasu – ostateczny termin zgodności przewidziano na koniec 2027 r., czyli trzy lata od wejścia w życie ustawy. W praktyce oznacza to, że w latach 2025-2027 firmy najbardziej odczują skutki regulacji: najpierw w obszarze generatywnej i ogólnej AI, a następnie w branżowych zastosowaniach wysokiego ryzyka. Przedsiębiorstwa powinny wpisać sierpień 2025 i sierpień 2026 do kalendarzy jako momenty przełomowe, a sierpień 2027 traktować jako ostateczną granicę, do której wszystkie systemy AI objęte zakresem regulacji muszą spełniać nowe standardy unijne. Regulatorzy zapowiadają też, że do 2027 r. pojawią się formalne „zharmonizowane normy” dla AI – opracowywane przez europejskie organizacje normalizacyjne – które dodatkowo usprawnią proces zgodności.

Reakcje branży: co pokazują xAI, Google i Meta

Jak firmy technologiczne zareagowały dotychczas na zmieniający się krajobraz regulacyjny? Pierwsze sygnały od liderów rynku dają wyraźny obraz mieszanki wsparcia i obaw. Z jednej strony wielu dużych graczy publicznie przyjęło podejście Unii Europejskiej. Przykładowo, Google zadeklarowało podpisanie nowego kodeksu postępowania, a prezes Microsoftu Brad Smith zasugerował, że Microsoft najprawdopodobniej zrobi to samo. Wielu deweloperów AI dostrzega wartość w spójności i stabilności, jakie obiecuje AI Act – harmonizacja przepisów w całej Europie zmniejsza niepewność prawną i może zwiększyć zaufanie użytkowników do produktów AI. To pro-regulacyjne podejście potwierdza długa lista wczesnych sygnatariuszy kodeksu, wśród których znajdują się nie tylko globalne koncerny technologiczne, ale także start-upy i firmy badawcze z Europy i spoza niej.

Z drugiej strony część znanych firm wyraziła zastrzeżenia lub przyjęła bardziej ostrożne stanowisko. Szczególnie głośno było o przedsięwzięciu Elona Muska, xAI, które w lipcu 2025 r. ogłosiło, że podpisze jedynie rozdział kodeksu dotyczący „Bezpieczeństwa i niezawodności” – rezygnując z części poświęconych przejrzystości i prawom autorskim. W oficjalnym oświadczeniu xAI podkreśliło, że „popiera bezpieczeństwo AI” i będzie przestrzegać wymogów bezpieczeństwa, ale uważa, że pozostałe fragmenty ustawy są „poważnie szkodliwe dla innowacji” i że regulacje dotyczące praw autorskich idą zbyt daleko. To częściowe podejście do zgodności sugeruje obawy, że zbyt rygorystyczne wymogi dotyczące przejrzystości i ujawniania danych mogą naruszyć tajemnice handlowe i osłabić przewagę konkurencyjną. Podobnie Meta (właściciel Facebooka) przyjęła stanowisko jeszcze bardziej opozycyjne: firma całkowicie odmówiła podpisania kodeksu, argumentując, że dokument wprowadza „niejasności prawne dla deweloperów modeli” i nakłada wymogi „wykraczające daleko poza zakres AI Act”. Innymi słowy, Meta uznała, że zobowiązania wynikające z kodeksu mogą być zbyt obciążające lub przedwczesne, zwłaszcza że wykraczają poza to, co wprost zapisano w ustawie (szczególnie w obszarze open-source i filtrów praw autorskich, wobec których firma jest krytyczna).

Tak różne reakcje pokazują, że branża z jednej strony jest świadoma ryzyk społecznych związanych ze sztuczną inteligencją, a z drugiej – ostrożna wobec ograniczeń regulacyjnych. Firmy takie jak Google i OpenAI, szybko popierając kodeks postępowania, dają sygnał, że są gotowe spełniać wyższe standardy przejrzystości i bezpieczeństwa – być może po to, by uprzedzić bardziej rygorystyczne działania egzekucyjne i pozycjonować się jako odpowiedzialni liderzy rynku. Z kolei sprzeciw Mety oraz częściowa, selektywna zgoda xAI pokazują obawy, że przepisy UE mogą osłabić konkurencyjność albo wymuszać niechciane ujawnienia danych treningowych i metod budowy modeli. Warto dodać, że podobne wątpliwości wyrażają też niektórzy eksperci i rządy – podczas zatwierdzania kodeksu Belgia zgłosiła zastrzeżenia do rozdziału dotyczącego praw autorskich, co odzwierciedla trwającą debatę o tym, jak najlepiej równoważyć innowacje z regulacją. W miarę jak AI Act przechodzi z poziomu zapisów prawnych do praktyki, można spodziewać się dalszego dialogu regulatorów z branżą. Komisja Europejska zapowiedziała już aktualizacje kodeksu wraz z rozwojem technologii – a nawet sceptycy prawdopodobnie wezmą udział w tym procesie, by mieć realny wpływ na jego kształt.

Strategiczne wskazówki dla liderów biznesu

Wraz z wejściem w życie kolejnych wymogów AI Act liderzy biznesu powinni podjąć proaktywne kroki, aby zapewnić zgodność i zminimalizować zarówno ryzyka prawne, jak i reputacyjne. Oto kluczowe obszary, na które warto zwrócić uwagę:

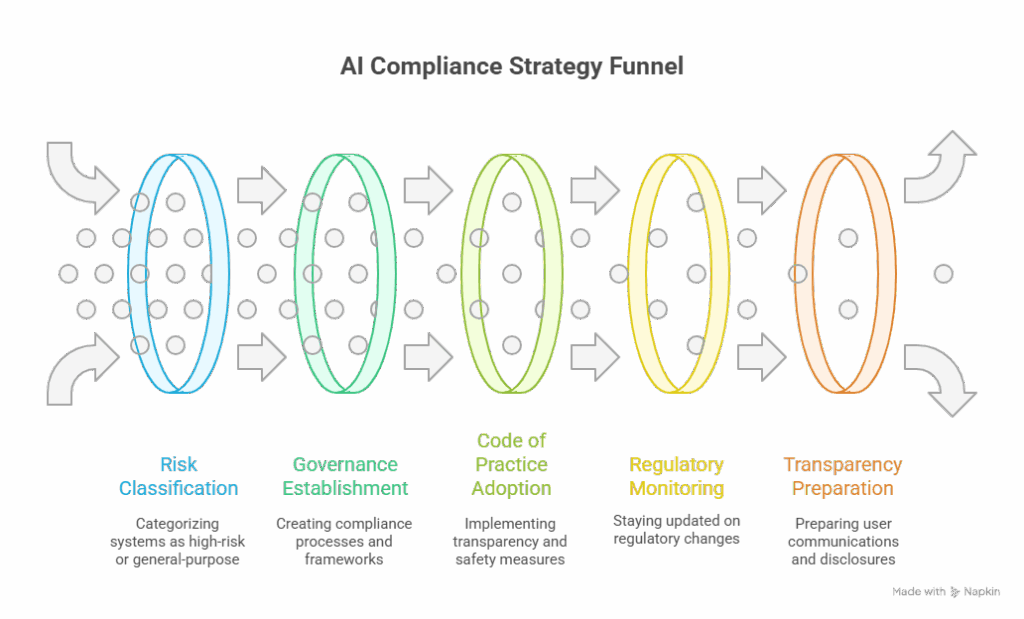

- Przeprowadź audyt portfela AI i klasyfikację ryzyka: Zacznij od stworzenia mapy wszystkich systemów, narzędzi i modeli AI używanych lub dostarczanych w firmie. Sprawdź, które z nich mogą mieścić się w definicji systemów wysokiego ryzyka (np. AI w ochronie zdrowia, finansach, HR) lub modeli ogólnego przeznaczenia. Ta klasyfikacja jest kluczowa – systemy wysokiego ryzyka muszą spełnić bardziej rygorystyczne wymogi (oceny zgodności, dokumentacja, nadzór człowieka), a dostawcy GPAI mają konkretne obowiązki w zakresie przejrzystości i bezpieczeństwa. Dzięki temu można odpowiednio ustalić priorytety działań zgodności.

- Stwórz ramy zarządzania i zgodności AI: Traktuj zgodność z AI Act jako odpowiedzialność międzydziałową – angażującą zespoły prawne, IT, data science i zarządzania ryzykiem. Opracuj wewnętrzne wytyczne i ramy zarządzania AI. Dla systemów wysokiego ryzyka oznacza to wdrożenie procesów do oceny ryzyka, kontroli jakości danych, dokumentowania i nadzoru człowieka przed wdrożeniem. W przypadku rozwoju GPAI warto wprowadzić procedury dokumentowania źródeł danych treningowych, redukcji uprzedzeń i testowania bezpieczeństwa modeli.

- Wykorzystaj kodeks postępowania GPAI i standardy: Jeśli Twoja organizacja rozwija duże modele AI, rozważ podpisanie unijnego kodeksu lub potraktowanie go jako praktycznego przewodnika. Przestrzeganie kodeksu może służyć jako dowód rzetelnych działań i ułatwić kontakt z regulatorami w okresie przejściowym, zanim pojawią się formalne standardy. Nawet bez formalnego podpisania warto wdrożyć jego rekomendacje – od dokumentacji modeli, przez polityki dot. praw autorskich, po testy odporności i red-teaming – co realnie poprawia profil ryzyka.

- Monitoruj regulacje i angażuj się w dialog: Środowisko regulacyjne AI będzie się rozwijać do 2026 r. i dalej. Śledź komunikaty European AI Office i Rady ds. AI – publikują one wytyczne, Q&A i interpretacje niejasnych punktów. Warto zabezpieczyć budżet na konsultacje prawne oraz uczestniczyć w konsultacjach branżowych czy forach. Zaangażowanie może pomóc w kształtowaniu nadchodzących standardów i pokazuje regulatorom, że firma działa odpowiedzialnie.

- Przygotuj się na przejrzystość i komunikację z klientami: Często niedocenianym elementem AI Act są wymogi wobec użytkowników końcowych. Systemy wysokiego ryzyka muszą informować użytkowników o interakcji z AI, a treści generowane automatycznie mogą wymagać oznaczeń. Warto już teraz przygotować jasne komunikaty o możliwościach i ograniczeniach AI. Równie ważne jest posiadanie gotowej dokumentacji i dowodów kontroli ryzyka – przyspieszy to reakcję na ewentualne zapytania regulatora. Przejrzystość wobec klientów i organów nadzoru może stać się przewagą konkurencyjną, a nie tylko obowiązkiem.

Ostatecznie liderzy biznesu powinni traktować zgodność nie jako formalny „checkbox”, lecz jako element budowania kultury zaufanej AI. AI Act stawia etykę i prawa człowieka w centrum regulacji. Firmy, które postawią na bezpieczeństwo użytkowników, sprawiedliwość i odpowiedzialność, wzmocnią swoją reputację. Z kolei brak zgodności lub głośny incydent (np. stronniczość algorytmu czy poważna awaria bezpieczeństwa) mogą skutkować nie tylko karami finansowymi (do 35 mln euro lub 7% globalnego obrotu), ale i kryzysem wizerunkowym. W nadchodzących latach inwestorzy, klienci i partnerzy biznesowi będą preferować organizacje, które potrafią udowodnić, że ich AI jest dobrze zarządzane i zgodne z regulacjami. Wczesne przygotowanie pozwoli uniknąć nerwowych działań na ostatnią chwilę i pozycjonuje firmę jako lidera w erze regulowanej sztucznej inteligencji.

TTMS AI Solutions – Automatyzuj z pewnością

Wraz z przechodzeniem EU AI Act z fazy zapisów prawnych do praktyki, organizacje potrzebują narzędzi, które łączą zgodność z regulacjami, wysoką wydajność i szybkość działania. Transition Technologies MS (TTMS) dostarcza rozwiązania AI klasy enterprise, które są bezpieczne, skalowalne i dopasowane do realnych procesów biznesowych.

- AI4Legal – Automatyzacja dla zespołów prawniczych: przyspiesz przegląd dokumentów, tworzenie projektów i podsumowań spraw, zachowując pełną kontrolę i możliwość śledzenia zmian.

- AI4Content – Analiza dokumentów na dużą skalę: przekształcaj raporty, formularze i transkrypcje w ustrukturyzowane dane gotowe do podejmowania decyzji.

- AI4E-Learning – Szybsze tworzenie treści szkoleniowych: zamieniaj materiały wewnętrzne w modułowe kursy z quizami, notatkami dla prowadzących i łatwą edycją.

- AI4Knowledge – Odpowiedzi zamiast plików: centralne repozytorium wiedzy z wyszukiwaniem w języku naturalnym, które skraca czas potrzebny na znalezienie procedur i know-how.

- AI4Localisation – Wielojęzyczność w tempie enterprise: tłumaczenia kontekstowe dopasowane do tonu, terminologii i spójności marki na różnych rynkach.

- AML Track – Zautomatyzowana zgodność AML: kompleksowa obsługa KYC, PEP i screeningów sankcyjnych, bieżący monitoring oraz raportowanie gotowe na audyt – wszystko w jednej platformie.

Nasi eksperci współpracują z Twoim zespołem na każdym etapie – od analizy potrzeb i zarządzania zgodnością, przez integrację, aż po wsparcie przy wdrożeniu zmian – tak, aby dostarczyć mierzalne rezultaty, a nie tylko kolejne narzędzie.

Kiedy EU AI Act będzie w pełni egzekwowany i jakie są kluczowe daty?

EU AI Act jest wdrażany stopniowo na przestrzeni kilku lat. Regulacja formalnie weszła w życie w sierpniu 2024 r., ale jej wymagania zaczynają obowiązywać w różnych terminach. Zakaz stosowania niektórych praktyk uznanych za niedopuszczalne (takich jak systemy punktacji społecznej czy manipulacyjne wykorzystanie AI) wszedł w życie w lutym 2025 r. Od 2 sierpnia 2025 r. zaczynają obowiązywać przepisy dotyczące modeli AI ogólnego przeznaczenia (tzw. foundation models) – każdy nowy model wprowadzony po tej dacie musi być zgodny z regulacją. Większość pozostałych wymogów, w tym obowiązki związane z wieloma systemami wysokiego ryzyka, wejdzie w życie w sierpniu 2026 r. (dwa lata po wejściu regulacji w życie). Ostateczny termin przypada na sierpień 2027 r. – do tego czasu dostawcy modeli już obecnych na rynku muszą dostosować je do przepisów. Podsumowując: okres od połowy 2025 do 2027 r. to moment, w którym wymagania AI Act stopniowo przechodzą z teorii w praktykę.

Czym jest kodeks postępowania dla modeli AI ogólnego przeznaczenia i czy firmy muszą go podpisać?

Kodeks postępowania dla GPAI to dobrowolny zestaw wytycznych zaprojektowanych tak, aby pomóc dostawcom modeli AI spełniać wymogi EU AI Act dotyczące systemów ogólnego przeznaczenia (takich jak duże modele językowe czy systemy generatywne). Obejmuje on dobre praktyki w zakresie przejrzystości (dokumentowanie procesu tworzenia AI i jego ograniczeń), praw autorskich (zapewnienie poszanowania własności intelektualnej w danych treningowych) oraz bezpieczeństwa (testowanie i ograniczanie ryzyk związanych z zaawansowanymi modelami). Firmy nie muszą podpisywać kodeksu – jest on opcjonalny – ale istnieje silna zachęta, aby to zrobić. Podmioty, które go przestrzegają, korzystają z tzw. „domniemania zgodności”, co oznacza, że regulatorzy uznają spełnienie wymogów AI Act, zapewniając większą pewność prawną. Wiele największych firm technologicznych już podpisało kodeks. Jeżeli jednak firma zdecyduje się tego nie robić, musi samodzielnie wykazać zgodność w inny sposób. Podsumowując: kodeks nie jest obowiązkowy, ale stanowi wysoce rekomendowaną i praktyczną drogę do spełnienia wymogów w przypadku modeli AI ogólnego przeznaczenia.

W jaki sposób European AI Office będzie egzekwować AI Act i jakie ma uprawnienia?

European AI Office to nowy organ regulacyjny UE, powołany w celu zapewnienia spójnego stosowania AI Act we wszystkich państwach członkowskich. Można go traktować jako europejskiego „strażnika” sztucznej inteligencji. Urząd posiada szereg istotnych uprawnień egzekucyjnych: może żądać od firm szczegółowych informacji i dokumentacji technicznej dotyczącej ich systemów AI, przeprowadzać oceny i testy modeli (zwłaszcza dużych modeli ogólnego przeznaczenia), aby sprawdzić ich zgodność, a także koordynować dochodzenia, jeśli istnieje podejrzenie naruszenia przepisów. Codzienne działania kontrolne – takie jak inspekcje rynkowe czy rozpatrywanie skarg – pozostają w gestii krajowych organów nadzoru, ale AI Office nadaje kierunek i zapewnia jednolite podejście, podobnie jak Europejska Rada Ochrony Danych w obszarze prawa o ochronie prywatności. Urząd może również inicjować kary – w przypadku poważnych naruszeń AI Act mogą one sięgać nawet 35 mln euro lub 7% globalnych rocznych przychodów firmy. W praktyce AI Office stanie się głównym punktem odniesienia na poziomie UE: będzie opracowywać wytyczne, zarządzać kodeksem postępowania i dbać o to, aby żadna firma nie umknęła uwadze w różnorodnym krajobrazie krajowych regulacji.

Czy EU AI Act obejmuje także firmy spoza UE, np. amerykańskie czy azjatyckie?

Tak. AI Act ma charakter eksterytorialny, bardzo podobny do unijnego RODO. Jeśli firma spoza Europy dostarcza system AI lub usługę, która jest używana w UE lub wpływa na osoby znajdujące się w UE, to musi ona przestrzegać przepisów AI Act w odniesieniu do tych działań. Nie ma znaczenia, gdzie firma ma siedzibę ani gdzie powstał model – liczy się wpływ na rynek europejski i użytkowników. Przykładowo, amerykańska firma technologiczna oferująca narzędzie generatywne klientom w UE czy azjatycki producent sprzedający do Europy robota z funkcjami AI będą podlegać tym regulacjom. Firmy spoza UE mogą być zobowiązane do wyznaczenia przedstawiciela w Unii (lokalnego punktu kontaktowego), a w razie naruszeń podlegają tym samym obowiązkom i karom (sięgającym nawet 35 mln euro lub 7% globalnych przychodów) co przedsiębiorstwa europejskie. Krótko mówiąc: jeśli Twoje rozwiązania AI oddziałują na Europę, zakładaj, że stosuje się do nich EU AI Act.

Jak firmy powinny zacząć przygotowania do zgodności z EU AI Act już teraz?

Aby się przygotować, firmy powinny przyjąć wielotorowe podejście. Po pierwsze, należy uświadomić kadrze zarządzającej i zespołom produktowym wymagania wynikające z AI Act i zidentyfikować, które systemy AI są nimi objęte. Następnie warto przeprowadzić analizę luk lub audyt – sprawdzić, czy istnieje potrzebna dokumentacja, mechanizmy kontroli ryzyka i środki przejrzystości. Jeśli ich brakuje, trzeba rozpocząć wdrażanie. Dobrym krokiem jest stworzenie wewnętrznego programu zarządzania AI, który łączy ekspertów prawnych, technicznych i operacyjnych w celu nadzorowania zgodności. Firmy budujące modele AI powinny rozważyć wykorzystanie unijnego kodeksu postępowania dla GPAI jako ramy odniesienia. Równolegle należy zaktualizować umowy i procedury w łańcuchu dostaw – upewniając się, że technologie AI nabywane od dostawców spełniają unijne standardy (w razie potrzeby wprowadzając odpowiednie klauzule zgodności). Kluczowa jest także elastyczność: warto na bieżąco śledzić nowe wytyczne European AI Office oraz prace nad standardami technicznymi, które będą precyzować oczekiwania regulatorów. Działając z wyprzedzeniem – przed głównymi terminami w 2025 i 2026 roku – firmy unikną nerwowych działań w ostatniej chwili i mogą potraktować zgodność nie jako obowiązek, lecz jako szansę na wzmocnienie zaufania do swoich rozwiązań AI.