Od obsługi klienta po wsparcie decyzyjne – systemy AI są już integralną częścią kluczowych funkcji biznesowych przedsiębiorstw. Liderzy biznesowi muszą zadbać o to, by potężne narzędzia AI (takie jak duże modele językowe, generatywni asystenci AI czy platformy uczenia maszynowego) były wykorzystywane odpowiedzialnie i bezpiecznie. Poniżej prezentujemy 10 kluczowych mechanizmów kontroli, które każda organizacja powinna wdrożyć, by zabezpieczyć sztuczną inteligencję w firmie.

1. Wdróż logowanie jednokrotne (SSO) i silne uwierzytelnianie

Kontrola tego, kto ma dostęp do Twoich narzędzi AI, to pierwszy filar bezpieczeństwa. Wprowadź w całej organizacji system SSO (logowanie jednokrotne), który wymusza uwierzytelnianie użytkownika przez centralnego dostawcę tożsamości (np. Okta, Azure AD) przed dostępem do jakiejkolwiek aplikacji AI. Dzięki temu tylko uprawnieni pracownicy mogą korzystać z systemów, a zarządzanie kontami staje się prostsze. Koniecznie aktywuj również uwierzytelnianie wieloskładnikowe (MFA) dla wszystkich platform AI, by zwiększyć poziom ochrony. W praktyce oznacza to, że wszystkie systemy generatywnej AI są dostępne wyłącznie przez autoryzowane kanały, co znacząco zmniejsza ryzyko nieuprawnionego dostępu. Silne uwierzytelnianie chroni nie tylko przed włamaniami, ale pozwala też zespołom bezpieczeństwa śledzić aktywność użytkowników z poziomu jednej tożsamości – co ma ogromne znaczenie przy audytach i zgodności z przepisami.

2. Wprowadź kontrolę dostępu opartą na rolach (RBAC) i zasadę minimalnych uprawnień

Nie każdy w organizacji powinien mieć taki sam dostęp do modeli AI czy danych. RBAC (role-based access control) to model bezpieczeństwa, który ogranicza dostęp do systemów w zależności od przypisanej roli użytkownika. Wdrożenie RBAC oznacza zdefiniowanie ról (np. data scientist, programista, analityk biznesowy, administrator) i przypisanie im odpowiednich uprawnień – tak, by każdy miał dostęp tylko do tego, czego potrzebuje do pracy. Dzięki temu tylko uprawnione osoby mają dostęp do wrażliwych danych i funkcji AI. Przykład: programista może korzystać z API modelu AI, ale nie widzi danych treningowych, podczas gdy data scientist może trenować model, ale nie wdrażać go na produkcji. Kluczowe jest stosowanie zasady najmniejszych uprawnień – każdy użytkownik powinien mieć tylko niezbędne minimum dostępu. W połączeniu z SSO, RBAC znacząco ogranicza ryzyko – nawet jeśli jedno konto zostanie przejęte, ograniczenia roli nie pozwolą atakującemu dotrzeć do newralgicznych systemów. RBAC to skuteczny sposób na ograniczenie nieautoryzowanego użycia i potencjalnych szkód.

3. Włącz logowanie audytowe i ciągły monitoring

Nie da się zabezpieczyć czegoś, czego się nie monitoruje. Logowanie audytowe to kluczowy element bezpieczeństwa AI – każda interakcja z modelem AI (prompty, dane wejściowe i wyjściowe, zapytania do API) powinna być rejestrowana i możliwa do prześledzenia. Dzięki szczegółowym logom zapytań i odpowiedzi, organizacja zyskuje pełną ścieżkę audytu, co ułatwia diagnozowanie problemów oraz spełnianie wymagań regulacyjnych. Takie logi pozwalają zespołom bezpieczeństwa wykryć nietypowe działania, np. gdy pracownik wprowadza dużą ilość wrażliwych danych albo AI generuje nieoczekiwane odpowiedzi.

W praktyce zaleca się ciągły monitoring wykorzystania AI – by w czasie rzeczywistym wykrywać anomalie lub potencjalne nadużycia. Firmy powinny wdrożyć dashboardy lub specjalistyczne narzędzia bezpieczeństwa AI, które śledzą wzorce użytkowania i uruchamiają alerty w razie podejrzanych działań (np. nagły wzrost liczby zapytań czy próby wycieku danych). Monitoring powinien również obejmować wydajność modelu i jego dryf – czyli czy odpowiedzi AI nadal mieszczą się w przewidywanych granicach. Celem jest wczesne wykrycie problemów: niezależnie od tego, czy chodzi o złośliwy prompt injection, czy manipulację modelem, odpowiedni monitoring pozwala szybko zareagować.

Pamiętaj: logi mogą zawierać wrażliwe dane (co pokazały wcześniejsze incydenty związane z wyciekiem historii czatów AI), dlatego same logi również należy odpowiednio zabezpieczyć i ograniczyć do nich dostęp. Dobrze wdrożone logowanie i monitoring dają Ci pełną widoczność działania systemów AI i pozwalają szybko wykrywać nieautoryzowany dostęp, manipulację danymi czy ataki typu adversarial.

4. Chroń dane za pomocą szyfrowania i maskowania

Systemy AI przetwarzają ogromne ilości danych – często poufnych. Każda firma powinna wdrożyć szyfrowanie danych i maskowanie danych, aby chronić informacje wykorzystywane przez AI. Po pierwsze, należy zadbać o szyfrowanie danych w tranzycie i w spoczynku. Oznacza to stosowanie protokołów takich jak TLS 1.2+ dla danych przesyłanych do i z usług AI oraz mocnych algorytmów szyfrowania (np. AES-256) dla danych przechowywanych w bazach danych czy hurtowniach danych. Szyfrowanie chroni przed odczytem danych przez osoby trzecie – nawet jeśli przechwycą transmisję lub uzyskają dostęp do nośników danych.

Po drugie, należy stosować maskowanie danych lub tokenizację dla wrażliwych pól w promptach lub danych treningowych. Maskowanie polega na ukrywaniu lub zastępowaniu danych osobowych (PII) oraz innych poufnych informacji fikcyjnymi, ale realistycznymi odpowiednikami, zanim trafią one do modelu AI. Na przykład imiona klientów czy numery ID mogą zostać zastąpione neutralnymi placeholderami. Dzięki temu AI generuje wartościowe wyniki, nie mając dostępu do prawdziwych danych prywatnych.

Obecnie dostępne są narzędzia, które automatycznie wykrywają i maskują dane wrażliwe w tekście, stanowiąc swoiste „barierki ochronne” dla prywatności w AI. Maskowanie i tokenizacja zapewniają, że nawet jeśli dojdzie do wycieku promptów lub logów, rzeczywiste dane osobowe nie zostaną ujawnione. Podsumowując: szyfruj wszystkie dane i eliminuj informacje wrażliwe wszędzie tam, gdzie jest to możliwe – te działania znacząco zmniejszają ryzyko wycieków danych przez systemy AI.

5. Zastosuj Retrieval-Augmented Generation (RAG), by zatrzymać dane wewnątrz firmy

Jednym z wyzwań związanych z wieloma modelami AI jest to, że są trenowane na ogólnych danych i mogą potrzebować Twojej wewnętrznej wiedzy, by odpowiadać na pytania specyficzne dla firmy. Zamiast przesyłać do AI duże ilości poufnych danych (co może grozić ich wyciekiem), firmy powinny wdrażać architekturę opartą na Retrieval-Augmented Generation (RAG). RAG to technika, która łączy model AI z zewnętrznym repozytorium wiedzy lub bazą danych. Gdy pojawia się zapytanie, system najpierw pobiera odpowiednie informacje z wewnętrznych źródeł danych, a następnie AI generuje odpowiedź w oparciu o te sprawdzone informacje. Takie podejście niesie wiele korzyści z punktu widzenia bezpieczeństwa. Oznacza, że odpowiedzi AI bazują na aktualnych, precyzyjnych i firmowych danych – np. z wewnętrznego SharePointa, baz wiedzy lub baz danych – bez konieczności dawania modelowi pełnego dostępu do tych danych przez cały czas. Model pozostaje więc ogólnym silnikiem, a wrażliwe dane pozostają w systemach pod Twoją kontrolą (lub w zaszyfrowanej bazie wektorowej). Dzięki RAG poufne dane nie muszą być bezpośrednio osadzane w treningu modelu, co zmniejsza ryzyko, że model „nauczy się” i nieświadomie ujawni wrażliwe informacje. Co więcej, systemy RAG poprawiają transparentność: często wskazują źródła lub kontekst odpowiedzi, dzięki czemu użytkownicy widzą, skąd pochodzą informacje. W praktyce może to wyglądać tak: pracownik pyta AI o wewnętrzną politykę – system RAG pobiera właściwy fragment dokumentu i AI na jego podstawie generuje odpowiedź, bez ujawniania całego pliku i bez wysyłania danych do zewnętrznego dostawcy. Wdrożenie RAG pomaga więc utrzymać dokładność odpowiedzi AI i bezpieczeństwo danych, wykorzystując moc AI przy jednoczesnym zachowaniu wiedzy w zaufanym środowisku.

(Jeśli chcesz głębiej zrozumieć RAG i jego zastosowania, zobacz nasz szczegółowy przewodnik: Retrieval-Augmented Generation (RAG).)

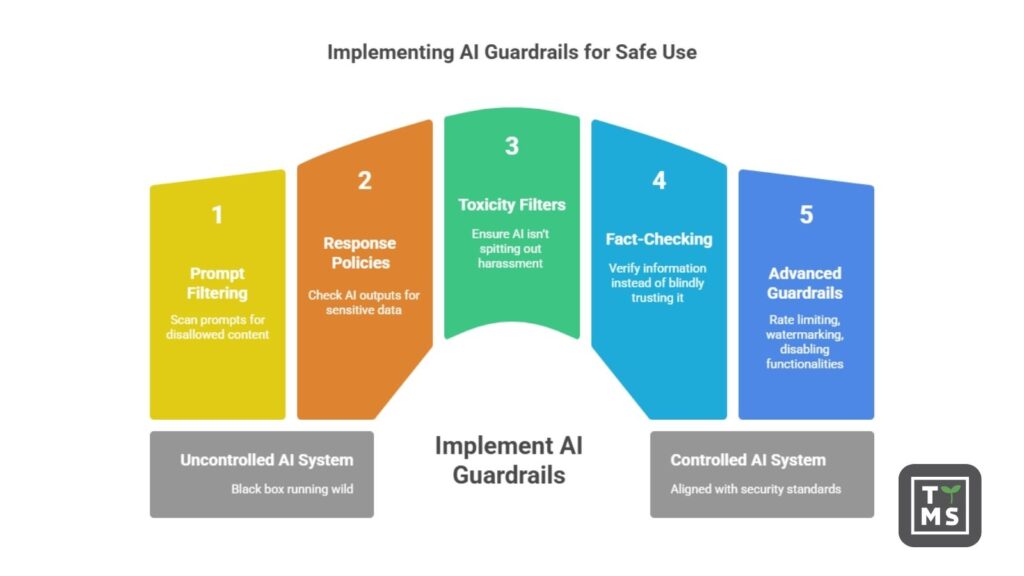

6. Ustal zabezpieczenia wejścia i wyjścia AI (AI Guardrails)

Żaden system AI nie powinien działać jak czarna skrzynka bez kontroli. Firmy muszą wdrażać zabezpieczenia tego, co trafia do modelu AI i co z niego wychodzi. Po stronie wejścia należy stosować filtry i walidację promptów. Mechanizmy te skanują zapytania użytkownika w poszukiwaniu zabronionych treści (jak dane osobowe, informacje poufne czy złośliwe instrukcje) i mogą je cenzurować lub blokować. Pomaga to zapobiec atakom typu prompt injection, w których atakujący próbują oszukać AI poleceniami typu „zignoruj wszystkie wcześniejsze instrukcje”, by ominąć zabezpieczenia. Dzięki filtrowaniu promptów wiele ataków można zatrzymać już na wejściu.

Po stronie wyjścia warto ustalić polityki odpowiedzi i stosować narzędzia do moderacji treści. Na przykład, jeśli AI generuje odpowiedź zawierającą coś, co przypomina numer karty kredytowej lub adres, system może to zmaskować lub wysłać ostrzeżenie do administratora. Również filtry toksycznych treści i systemy fact-checkingowe pomagają upewnić się, że AI nie generuje mowy nienawiści, molestowania czy oczywistych dezinformacji. Niektóre platformy AI dla firm pozwalają też wymusić, by model cytował źródła odpowiedzi, co zwiększa wiarygodność i pozwala użytkownikowi samodzielnie ją zweryfikować.

Bardziej zaawansowane zabezpieczenia obejmują m.in. ograniczanie liczby zapytań (rate limiting – by zapobiec scrapowaniu danych przez AI), wodoodporne znakowanie treści (watermarking) w celu identyfikacji wygenerowanych treści oraz blokowanie funkcji wysokiego ryzyka (np. uniemożliwienie AI-asystentowi kodującemu wykonywania poleceń systemowych). Kluczowe jest z góry zdefiniowanie dopuszczalnego użycia AI. Jak zauważa SANS Institute, wdrażając guardrails i filtry promptów, organizacje mogą skutecznie ograniczyć manipulacje i zapobiec niepożądanemu, ukrytemu zachowaniu modelu, które mogliby wywołać atakujący. Mówiąc krótko, guardrails działają jak siatka bezpieczeństwa, utrzymując AI w zgodzie z firmowymi standardami bezpieczeństwa i etyki.

7. Oceń i zweryfikuj dostawców AI (zarządzanie ryzykiem stron trzecich)

Wiele firm korzysta z zewnętrznych rozwiązań AI – czy to w formie narzędzi SaaS, usług chmurowych, czy gotowych modeli dostarczanych przez vendorów. Dlatego tak ważne jest, aby ocenić bezpieczeństwo każdego dostawcy AI przed jego wdrożeniem. Zacznij od podstaw: sprawdź, czy dostawca stosuje dobre praktyki bezpieczeństwa (czy szyfrują dane? czy oferują SSO i RBAC? czy są zgodni z przepisami, np. GDPR, SOC 2?). Dostawca powinien jasno komunikować, jak przetwarza Twoje dane. Zapytaj, czy planują używać danych Twojej firmy do własnych celów, np. do trenowania modeli – jeśli tak, warto to ograniczyć lub z tego zrezygnować. Wielu dostawców AI pozwala dziś klientom biznesowym zachować pełne prawo do wprowadzanych/zwracanych danych i wyłączyć opcję ich wykorzystania do treningu (tak działa np. OpenAI w planie enterprise). Upewnij się, że Twój dostawca to gwarantuje – nie chcesz przecież, by Twoje wrażliwe dane firmowe trafiły do publicznego modelu AI.

Sprawdź politykę prywatności i zabezpieczenia dostawcy – dotyczy to m.in. metod szyfrowania, kontroli dostępu oraz procedur przechowywania i usuwania danych. Warto zapytać o historię dostawcy: czy mieli incydenty naruszenia danych lub problemy prawne? Dobrym krokiem jest przeprowadzenie oceny bezpieczeństwa lub wymaganie wypełnienia kwestionariusza bezpieczeństwa dla dostawcy (skoncentrowanego na ryzykach związanych z AI), który może ujawnić potencjalne zagrożenia. Weź też pod uwagę, gdzie hostowana jest usługa AI (lokalizacja, chmura), ponieważ przepisy o lokalizacji danych mogą wymagać, by dane pozostały w określonym kraju.

Traktuj dostawcę AI tak samo rygorystycznie, jak każdego krytycznego partnera IT: wymagaj przejrzystości i solidnych zabezpieczeń. Organizacje takie jak Cloud Security Alliance opublikowały wzorcowe kwestionariusze oceny ryzyka dostawców AI, z których warto skorzystać. Jeśli dostawca nie potrafi jasno odpowiedzieć, jak chroni Twoje dane lub jak spełnia wymagania regulacyjne – warto się zastanowić nad jego wyborem. Dokładna weryfikacja partnerów AI pomaga zminimalizować ryzyko w łańcuchu dostaw i upewnić się, że każda zewnętrzna usługa AI spełnia Twoje wymogi bezpieczeństwa i zgodności.

8. Zaprojektuj bezpieczną, świadomą ryzyka architekturę AI

To, jak zaprojektujesz swoje rozwiązania AI, ma ogromny wpływ na poziom ryzyka. Firmy powinny wdrażać zabezpieczenia już na etapie projektowania architektury AI. Jednym z kluczowych aspektów jest to, gdzie systemy AI są uruchamiane i przechowywane. Wdrożenie lokalne lub w prywatnej chmurze daje większą kontrolę nad danymi i bezpieczeństwem – to Ty decydujesz, kto ma dostęp i nie musisz wysyłać danych do zewnętrznych usługodawców. Wymaga to jednak odpowiedniej infrastruktury i zabezpieczenia środowiska. Jeśli korzystasz z publicznych usług AI w chmurze, stosuj wirtualne sieci prywatne (VPC), prywatne punkty końcowe i szyfrowanie, aby izolować dane.

Dobrą praktyką jest również segmentacja sieci: oddziel środowiska deweloperskie i uruchomieniowe AI od głównych sieci IT. Na przykład wewnętrzny LLM lub agent AI powinien działać w odseparowanym środowisku (np. osobna podsieć lub kontener), dzięki czemu nawet w razie naruszenia bezpieczeństwa atakujący nie uzyska dostępu do kluczowych baz danych. Zastosuj zasadę zero zaufania na poziomie architektury – żaden komponent lub mikroserwis AI nie powinien ufać innemu domyślnie. Stosuj bramki API, polityki sieciowe i uwierzytelnianie oparte na tożsamości przy każdej komunikacji pomiędzy komponentami.

Warto również wdrożyć piaskownice zasobów: uruchamiaj AI w kontenerach lub maszynach wirtualnych z minimalnymi uprawnieniami, by ograniczyć potencjalne szkody. Architektura odporna na ryzyko to także taka, która zakłada awarie – wdrażaj mechanizmy ograniczające (throttling), przerywniki (circuit breakers) i redundancję dla kluczowych funkcji, by utrzymać ciągłość działania. Oddziel środowiska testowe od produkcyjnych – żadne eksperymentalne projekty AI nie powinny mieć dostępu do danych produkcyjnych bez przeglądu i zatwierdzenia.

Projektując architekturę AI z myślą o izolacji, ograniczonym zaufaniu i zasadzie najmniejszych uprawnień, ograniczasz ryzyko systemowe. Czasem warto nawet wybrać mniejsze, wyspecjalizowane modele, które łatwiej zabezpieczyć, zamiast dużych, ogólnych modeli mających dostęp do wszystkiego. Podsumowując: projektuj z myślą o kontroli i ograniczaniu szkód – zakładaj, że AI może ulec awarii lub zostać zaatakowana i zapobiegaj eskalacji, tak jak projektuje się statki z grodziami zabezpieczającymi przed zalaniem.

9. Wdróż ciągłe testowanie i monitorowanie systemów AI

Podobnie jak ewoluują zagrożenia cybernetyczne, zmieniają się też systemy AI i związane z nimi ryzyka – dlatego ciągłe testowanie i monitorowanie są kluczowe. Traktuj to jako fazę „utrzymania i działania” bezpieczeństwa AI. Nie wystarczy raz wdrożyć zabezpieczenia – potrzebny jest stały nadzór. Zacznij od ciągłego monitorowania modeli: obserwuj wydajność i wyniki modeli AI w czasie. Jeśli ich zachowanie zaczyna odbiegać od normy (np. pojawiają się stronnicze lub dziwne odpowiedzi), może to świadczyć o dryfie koncepcyjnym lub problemach z bezpieczeństwem (jak zatruwanie danych). Wprowadź metryki i automatyczne alerty. Przykład: niektóre firmy wdrażają systemy wykrywania dryfu, które informują o spadku trafności na testach kontrolnych lub o nietypowych zmianach w odpowiedziach.

Kolejny krok to regularne testy w scenariuszach ataków. Przeprowadzaj cykliczne ćwiczenia red team dla swoich aplikacji AI – symuluj popularne ataki, takie jak prompt injection, zatruwanie danych, obchodzenie modeli, itp., aby sprawdzić odporność zabezpieczeń. Coraz więcej organizacji tworzy własne metodyki pentestów AI (np. testowanie reakcji modelu na spreparowane wejścia). Wczesne wykrycie luk pozwala je załatać, zanim zrobią to atakujący. Upewnij się też, że masz plan reagowania na incydenty AI. Twój zespół bezpieczeństwa musi wiedzieć, jak zareagować, gdy dojdzie do incydentu z udziałem AI – np. wycieku danych przez model, przejęcia klucza API czy nieprawidłowego działania AI w kluczowym procesie. Stwórz scenariusze działania na wypadek takich sytuacji jak: „AI ujawnia dane wrażliwe” lub „AI niedostępne z powodu DDoS”, aby zespół mógł działać natychmiastowo.

Reakcja na incydent powinna zawierać kroki takie jak izolacja systemu (np. wyłączenie wadliwego AI), zabezpieczenie dowodów (logi, snapshoty modelu), oraz naprawa (np. retrenowanie modelu, zmiana kluczy dostępu). Regularne audyty to kolejny filar kontroli – przeglądaj na bieżąco, kto ma dostęp do systemów AI (uprawnienia mogą się niepostrzeżenie rozszerzać), sprawdzaj, czy po aktualizacjach nadal obowiązują zabezpieczenia pipeline’u AI, i weryfikuj zgodność z przepisami. Traktując bezpieczeństwo AI jako proces ciągły z elementami monitoringu, testów i doskonalenia, organizacja może szybciej wykrywać zagrożenia i utrzymać wysoki poziom ochrony – nawet gdy technologia i ryzyka stale się zmieniają. Pamiętaj: zabezpieczenie AI to cykl, a nie jednorazowy projekt.

10. Wprowadź nadzór nad AI, zgodność z przepisami i programy szkoleniowe

Same zabezpieczenia techniczne nie wystarczą – organizacje muszą wdrożyć odpowiednie zasady zarządzania i polityki dotyczące AI. Oznacza to określenie, jak firma może (a jak nie powinna) korzystać z AI oraz kto ponosi odpowiedzialność za jej działania. Warto powołać komitet ds. zarządzania AI, w skład którego wchodzą przedstawiciele działów IT, bezpieczeństwa, prawnego, compliance i biznesowego. Taki zespół może ustalać, jakie przypadki użycia AI są dozwolone, oceniać narzędzia i dostawców pod kątem bezpieczeństwa, a także regularnie przeglądać projekty AI pod kątem ryzyk. Formalne zasady governance gwarantują, że wdrożenia AI są zgodne z przepisami i standardami etycznymi i zapewniają kontrolę wykraczającą poza zespół techniczny. Wiele firm wdraża dziś standardy takie jak NIST AI RMF czy normy ISO dla AI.

Zarządzanie obejmuje też prowadzenie inwentaryzacji systemów AI (tzw. AI Bill of Materials) – należy wiedzieć, jakie modele i dane są wykorzystywane i dokumentować to dla przejrzystości. Po stronie zgodności z przepisami należy śledzić regulacje takie jak RODO, HIPAA czy powstające przepisy jak AI Act UE i upewnić się, że wykorzystanie AI jest zgodne z nimi (np. prawo do bycia zapomnianym, przejrzystość algorytmiczna, ograniczanie stronniczości). W przypadku zastosowań wysokiego ryzyka może być konieczne przeprowadzenie oceny wpływu AI i wdrożenie odpowiednich zabezpieczeń prawnych.

Nie mniej ważne jest szkolenie pracowników z bezpiecznego korzystania z AI. Jednym z największych zagrożeń jest nieświadome wklejenie poufnych danych do narzędzi AI – szczególnie publicznych. Należy jasno określić w szkoleniach i politykach firmowych, czego nie wolno udostępniać systemom AI – np. kodu źródłowego, danych klientów, raportów finansowych – chyba że dane narzędzie zostało zatwierdzone i zabezpieczone. Pracownicy powinni być świadomi, że nawet jeśli narzędzie deklaruje prywatność, najlepszym podejściem jest ograniczanie danych wrażliwych do minimum.

Warto promować kulturę, w której AI wspiera produktywność, ale zawsze w duchu odpowiedzialności i bezpieczeństwa (np. „ufaj, ale weryfikuj” wyniki AI przed działaniem). Dodaj wytyczne dotyczące AI do polityki bezpieczeństwa informacji lub podręcznika pracownika. Silne zarządzanie, jasne zasady i świadomi użytkownicy tworzą ludzki firewall przed zagrożeniami związanymi z AI. Każdy – od kadry zarządzającej po nowe osoby w zespole – powinien rozumieć zarówno szanse, jak i odpowiedzialność wynikającą z wykorzystania sztucznej inteligencji. Dzięki governance i edukacji, firma może wdrażać AI bez ryzyka dla danych, zachowując zgodność i unikając kosztownych błędów.

Podsumowanie – działaj proaktywnie i bezpiecznie

Wdrożenie tych 10 mechanizmów kontrolnych pozwoli Twojej firmie obrać właściwy kierunek w stronę bezpiecznego wdrażania AI. Krajobraz zagrożeń związanych ze sztuczną inteligencją dynamicznie się zmienia, ale dzięki połączeniu zabezpieczeń technicznych, czujnego monitoringu i solidnego nadzoru, przedsiębiorstwa mogą korzystać z zalet AI bez kompromisów w zakresie bezpieczeństwa i prywatności. Pamiętaj, że bezpieczeństwo AI to proces ciągły – regularnie przeglądaj i aktualizuj swoje kontrole w miarę rozwoju technologii i przepisów. W ten sposób chronisz dane, utrzymujesz zaufanie klientów i umożliwiasz zespołom bezpieczne wykorzystanie AI jako mnożnika efektywności biznesowej.

Jeśli potrzebujesz wsparcia w bezpiecznym wdrażaniu AI lub chcesz poznać dopasowane do Twoich potrzeb rozwiązania AI, odwiedź naszą stronę AI Solutions for Business. Zespół TTMS pomoże Ci wdrożyć najlepsze praktyki i zbudować systemy AI, które są zarówno skuteczne, jak i bezpieczne.

FAQ

Czy można ufać decyzjom podejmowanym przez AI w biznesie?

Zaufanie do AI powinno być oparte na transparentności, jakości danych i audytowalności modeli. AI może podejmować szybkie i trafne decyzje, ale tylko wtedy, gdy działa w przewidywalnym i nadzorowanym środowisku. Brak wglądu w logikę działania modelu (tzw. „black box”) obniża zaufanie. Dlatego ważne są mechanizmy tłumaczalności decyzji (explainable AI) oraz ciągły monitoring zachowania modeli. Ufać warto, ale z odpowiednią dozą kontroli i weryfikacji.

Jak odróżnić „zaufaną” AI od tej potencjalnie niebezpiecznej?

Zaufaną AI charakteryzuje przejrzystość procesu trenowania, znane źródła danych, audyty bezpieczeństwa i możliwość uzyskania wyjaśnienia decyzji. Niebezpieczna AI to taka, której nie wiemy, „czego się nauczyła” i nie mamy nad nią wystarczającej kontroli. Warto sprawdzać, czy model przeszedł testy bezpieczeństwa i czy można go cofnąć lub „wyłączyć” w razie problemów. Zaufanie buduje się na zgodności z zasadami etyki, odpowiedzialności i regulacjami branżowymi.

Czy ludzie ufają AI bardziej niż innym ludziom?

W wielu przypadkach – tak, zwłaszcza jeśli AI kojarzy się z „obiektywnym” podejściem i szybką analizą danych. Ale w sytuacjach wymagających empatii, moralnych osądów czy złożonych niuansów kulturowych, ludzie nadal wolą zaufać innym ludziom. Zaufanie do AI często zależy od kontekstu: inżynier zaufa AI analizującej dane, ale dyrektor HR może nie zaufać jej w kwestii oceny kandydatów. Dlatego tak ważna jest współpraca człowieka i AI – zamiast zastępować zaufanie, AI powinna je wspierać.

Jak budować zaufanie do AI w organizacji?

Kluczowe są: edukacja pracowników, przejrzystość procesu wdrożenia i włączenie użytkowników końcowych w projektowanie rozwiązań. Dobrą praktyką jest stopniowe wprowadzanie AI z jasno określonymi celami i kontrolami. Ważne też, by komunikować ograniczenia AI i nie traktować jej jako „wszechwiedzącej”. Zaufanie rośnie, gdy użytkownicy widzą, że AI działa przewidywalnie, uczy się na błędach i wspiera ich pracę zamiast ją zastępować.

Czy AI może „udawać” godną zaufania – a mimo to szkodzić?

Tak, i właśnie to jest jedno z najtrudniejszych zagrożeń. Model może brzmieć wiarygodnie, podawać poprawne odpowiedzi, a mimo to zawierać ukryte błędy, stronniczość lub luki w logice. Złośliwa manipulacja danymi treningowymi (np. zatruwanie danych) może sprawić, że AI będzie działać dobrze na zewnątrz, ale źle wewnątrz. Dlatego nie wystarczy oceniać AI po „zachowaniu” – trzeba też rozumieć, na czym się uczyła i kto ma nad nią kontrolę.