1. Wprowadzenie: od hype’u do twardej rzeczywistości

Przez ostatnie trzy lata upowszechnianie sztucznej inteligencji w biznesie była napędzana hype’em i niekontrolowanymi eksperymentami. Firmy inwestowały miliardy w pilotaże generatywnej AI, licząc na to, że technologia ta „dosłownie wszystko” odmieni. Szczególnie rok 2025 był szczytem tej gorączki AI – wiele organizacji przechodziło wtedy od testów do rzeczywistych wdrożeń. Jednocześnie rzeczywistość coraz wyraźniej rozmijała się z obietnicami. Realny wpływ AI na biznes okazywał się nierówny i trudny do jednoznacznego zmierzenia, głównie dlatego, że otaczające ją systemy i procesy nie były gotowe na trwałe wykorzystanie jej potencjału. Jak trafnie zauważyło World Economic Forum, „jeśli 2025 był rokiem hype’u wokół AI, to 2026 może okazać się rokiem rozliczenia”. W 2026 roku rachunek za pierwsze eksperymenty z AI zaczyna być wystawiany – w postaci długu technicznego, ryzyk bezpieczeństwa, presji regulacyjnej oraz rosnącej niecierpliwości inwestorów.

Rok 2026 oznacza punkt zwrotny: era bezrefleksyjnego entuzjazmu wobec AI ustępuje miejsca epoce oceny i odpowiedzialności. Kluczowe pytanie nie brzmi już „czy AI potrafi to zrobić?”, lecz „jak dobrze potrafi to zrobić, jakim kosztem i kto ponosi ryzyko?”. W tym artykule analizujemy, w jaki sposób swobodne eksperymenty z AI w latach 2023-2025 wygenerowały ukryte koszty i zagrożenia oraz dlaczego rok 2026 zapowiada się jako moment prawdy dla AI w biznesie – moment, w którym hype zderza się z rzeczywistością, a ktoś musi zapłacić cenę.

2. Lata 2023-2025: epoka hype’u i niekontrolowanych eksperymentów z AI

Z perspektywy czasu lata 2023-2025 były dla wielu organizacji prawdziwym „Dzikim Zachodem” AI. Narzędzia generatywnej AI (GenAI) – takie jak ChatGPT, Copiloty czy modele tworzone na zamówienie – szturmem wkroczyły na rynek, obiecując rewolucję w programowaniu, tworzeniu treści, obsłudze klienta i wielu innych obszarach. Zarówno technologiczni giganci, jak i startupy inwestowały bezprecedensowe środki w rozwój AI oraz infrastrukturę, napędzając falę innowacji. W niemal każdej branży AI przedstawiano jako siłę transformacyjną, a firmy ścigały się w uruchamianiu kolejnych pilotażowych zastosowań, obawiając się, że pozostaną w tyle.

Ten pośpiech niósł jednak ze sobą wyraźną sprzeczność. Ogromne modele i potężne budżety przyciągały uwagę mediów, ale codzienne doświadczenia firm często nie dorównywały wygórowanym oczekiwaniom. Pod koniec 2025 roku wiele organizacji miało trudność z wykazaniem konkretnych, mierzalnych efektów swoich inicjatyw AI. Problem nie polegał na tym, że technologia zawiodła – w wielu przypadkach algorytmy działały zgodnie z założeniami. Kluczowe było raczej to, że procesy biznesowe i systemy wspierające nie były przygotowane na przekucie wyników AI w trwałą wartość. Brakowało odpowiedniej infrastruktury danych, zarządzania zmianą oraz integracji z istniejącymi systemami, przez co wczesne pilotaże rzadko przeradzały się w stabilny i powtarzalny zwrot z inwestycji.

Entuzjazm wokół AI pozostał jednak niezwykle wysoki. Początkowe potknięcia i nierówne rezultaty w niewielkim stopniu osłabiły mentalność „wyścigu AI”. Wręcz przeciwnie – porażki przesunęły punkt ciężkości debaty z samego wdrażania na skuteczniejsze wykorzystanie AI. Jak ujęto to w jednej z analiz, „te momenty niepowodzeń nie zmniejszyły entuzjazmu – dojrzały go, przekształcając początkową ekscytację w silniejsze dążenie do realnych efektów”. Do 2025 roku AI zdecydowanie wyszła z fazy testów i trafiła do realnych wdrożeń produkcyjnych, a kadra zarządzająca wchodziła w 2026 rok nadal przekonana, że AI jest koniecznością – choć już znacznie bardziej świadoma wyzwań, które się z nią wiążą.

3. Narastający dług techniczny i bezpieczeństwa jako efekt szybkiej adopcji AI

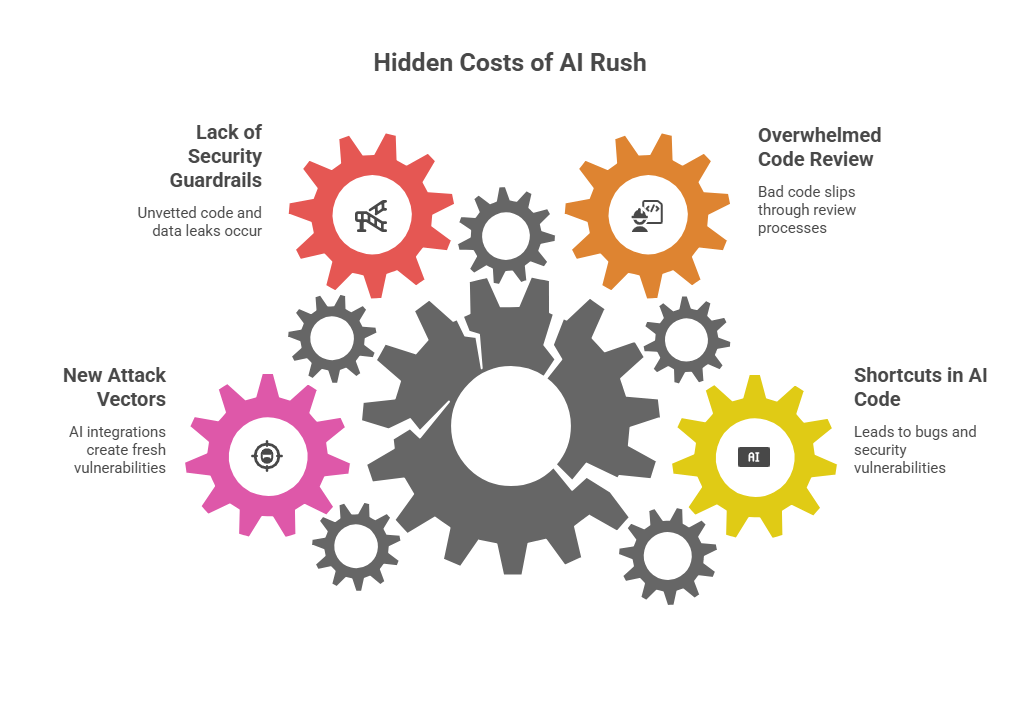

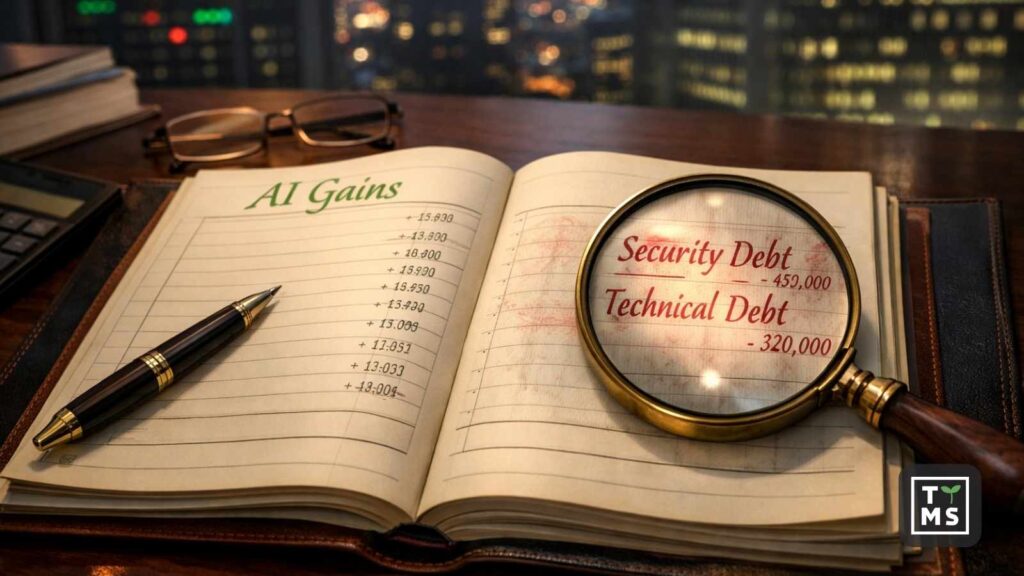

Jednym z ukrytych kosztów boomu na AI w latach 2023-2025 jest znaczący dług techniczny i dług bezpieczeństwa, który zgromadziło wiele organizacji. W pośpiechu towarzyszącym szybkim wdrożeniom rozwiązań AI często chodzono na skróty – szczególnie w obszarze kodu generowanego przez AI oraz zautomatyzowanych przepływów pracy – co przełożyło się na długofalowe problemy utrzymaniowe i nowe podatności.

Asystenci programistyczni oparte na AI radykalnie przyspieszyli rozwój oprogramowania, pozwalając zespołom wytwarzać kod nawet dwukrotnie szybciej. Ta prędkość miała jednak swoją cenę. Badania pokazują, że kod generowany przez AI często faworyzuje szybkie rozwiązania kosztem solidnej architektury, co prowadzi do kumulowania się błędów, luk bezpieczeństwa, zduplikowanego kodu oraz trudnej do opanowania złożoności. Jak zauważono w jednym z raportów, „gwałtowny wzrost tempa w naturalny sposób zwiększa akumulację zobowiązań jakościowych kodu – w szczególności błędów, podatności bezpieczeństwa, złożoności strukturalnej oraz długu technicznego”. Nawet jeśli narzędzia do generowania kodu stale się poprawiają, sama skala produkcji przerasta możliwości ludzkiego code review, przez co wadliwy kod przedostaje się do środowisk produkcyjnych. Efekt to rosnący backlog strukturalnie słabego kodu i ukrytych defektów, który dziś wymaga kosztownej refaktoryzacji i zabezpieczania.

Analitycy Forrester przewidują, że do 2026 roku 75% decydentów technologicznych będzie zmagać się z umiarkowanym lub poważnym długiem technicznym, w dużej mierze będącym konsekwencją podejścia „najpierw szybkość”, charakterystycznego dla rozwoju wspieranego przez AI w poprzednich latach. Taki dług to nie tylko problem zespołów developerskich – to realne ryzyko dla całej organizacji. Systemy nasycone błędami wprowadzonymi przez AI lub źle utrzymywane modele mogą zawodzić w nieprzewidywalny sposób, zakłócając procesy biznesowe i doświadczenia klientów.

Liderzy obszaru bezpieczeństwa również coraz głośniej ostrzegają przed „długiem bezpieczeństwa” wynikającym z gwałtownej adopcji GenAI. W pogoni za automatyzacją i generowaniem kodu lub treści wiele firm nie zadbało o odpowiednie mechanizmy ochronne. Do najczęstszych problemów należą:

- Nieweryfikowany kod generowany przez AI, zawierający ukryte podatności (np. niezabezpieczone API czy błędy logiczne), wdrażany bezpośrednio do systemów produkcyjnych. Jeśli nie zostanie wykryty, może być łatwo wykorzystany przez atakujących.

- Zjawisko „shadow AI” wśród pracowników – korzystanie z prywatnych kont ChatGPT lub innych narzędzi AI do przetwarzania danych firmowych – prowadzące do wycieków wrażliwych informacji. Przykładowo w 2023 roku inżynierowie Samsunga nieumyślnie ujawnili poufny kod źródłowy w ChatGPT, co skłoniło firmę do czasowego zakazu korzystania z generatywnej AI do momentu wdrożenia odpowiednich kontroli. W wewnętrznej ankiecie Samsunga 65% respondentów uznało narzędzia GenAI za zagrożenie dla bezpieczeństwa, wskazując na brak możliwości odzyskania danych po ich przesłaniu na zewnętrzne serwery AI. Od tego czasu wiele organizacji odkryło, że pracownicy bez zgody wklejają do narzędzi AI dane klientów lub fragmenty kodu, generując ryzyka zgodności regulacyjnej oraz naruszenia własności intelektualnej.

- Nowe wektory ataku wynikające z integracji AI. W miarę jak firmy wplatały AI w swoje produkty i procesy, często nieświadomie tworzyły nowe podatności. Aktorzy zagrożeń coraz częściej wykorzystują generatywną AI do prowadzenia bardziej zaawansowanych cyberataków w tempie maszynowym – od wiarygodnych kampanii phishingowych po eksploitację kodu. Jednocześnie usługi AI zintegrowane z aplikacjami mogą być podatne na manipulacje (np. prompt injection czy zatruwanie danych), jeśli nie zostaną odpowiednio zabezpieczone.

W praktyce oznacza to, że zespoły bezpieczeństwa wchodzą w 2026 rok z narastającym backlogiem ryzyk związanych z AI, które trzeba pilnie ograniczać. Regulatorzy, klienci i audytorzy coraz częściej oczekują „udowadnialnych mechanizmów bezpieczeństwa obejmujących cały cykl życia AI (pozyskiwanie danych, trenowanie, wdrożenie, monitoring oraz reagowanie na incydenty)”. Innymi słowy, firmy muszą dziś realnie spłacać dług bezpieczeństwa powstały w wyniku gwałtownej adopcji AI – wdrażając bardziej restrykcyjne kontrole dostępu, lepszą ochronę danych oraz testy bezpieczeństwa modeli AI. Reaguje na to nawet rynek ubezpieczeń cybernetycznych – niektórzy ubezpieczyciele wymagają już dowodów aktywnego zarządzania ryzykiem AI jako warunku objęcia organizacji ochroną. Mowa tutaj o takich dowodach jak symulowane testy ataków na modele AI (red teaming) czy sprawdzanie, czy model nie faworyzuje wybranych grup (testy stronniczości).

Wniosek: epoka eksperymentów rzeczywiście przyspieszyła produktywność, ale jednocześnie wygenerowała ukryte koszty. W 2026 roku organizacje będą musiały zainwestować czas i środki, aby posprzątać „bałagan po AI” – refaktoryzować niestabilny kod generowany przez AI, łatać podatności oraz wprowadzać mechanizmy zapobiegające wyciekom danych i nadużyciom. Firmy, które nie zmierzą się z tym długiem technicznym i bezpieczeństwa, zapłacą w inny sposób – poprzez incydenty, przestoje systemów lub zahamowanie innowacji.

4. Luka w nadzorze: adopcja AI wyprzedziła governance

Kolejną istotną lekcją wyniesioną z boomu AI w latach 2023-2025 jest to, że wdrażanie AI wyraźnie wyprzedziło mechanizmy nadzoru. W ferworze implementacji rozwiązań opartych na AI wiele organizacji zaniedbało stworzenie spójnego governance AI, ścieżek audytowych oraz wewnętrznych kontroli. W 2026 roku ta luka staje się boleśnie widoczna.

W fazie hype’u atrakcyjne narzędzia AI były często wdrażane przy minimalnych wytycznych politycznych i bez rzetelnej oceny ryzyka. Niewiele firm posiadało ramy pozwalające odpowiedzieć na kluczowe pytania: kto ponosi odpowiedzialność za decyzje podejmowane przez AI? Jak audytować działania systemu? Czy zapobiegamy stronniczości, nadużyciom własności intelektualnej lub naruszeniom zgodności regulacyjnej? W efekcie wiele organizacji funkcjonowało w modelu „ufamy AI”, bez etapu „sprawdzamy”. Pracownicy otrzymywali copiloty AI do generowania kodu lub treści, ale brakowało logów audytowych i dokumentacji pokazujących, co dokładnie wygenerowała AI i czy wynik został zweryfikowany przez człowieka. Algorytmy wspierające podejmowanie decyzji trafiały do użytku bez jasno określonej odpowiedzialności i punktów kontroli typu human-in-the-loop.

W badaniu PwC niemal połowa menedżerów przyznała, że wdrożenie zasad Responsible AI w praktyce stanowi dla nich wyzwanie. Choć zdecydowana większość zgadza się, że odpowiedzialna AI jest kluczowa dla ROI i efektywności, to operacjonalizacja tych zasad – poprzez testy uprzedzeń, transparentność czy mechanizmy kontroli – wyraźnie nie nadążała za tempem wdrożeń. W praktyce adopcja AI rozprzestrzeniała się szybciej niż modele nadzoru zdolne zarządzać jej specyficznymi ryzykami. Organizacje masowo wdrażały agentów AI i zautomatyzowane systemy decyzyjne, „szybciej, niż governance było w stanie odpowiedzieć na ich unikalne potrzeby”. Ta luka w nadzorze sprawiła, że wiele firm weszło w 2026 rok z systemami AI działającymi produkcyjnie, ale pozbawionymi solidnego nadzoru i dokumentacji, co znacząco zwiększa ryzyko błędów oraz potknięć etycznych.

Początkowy wyścig po AI często stawiał szybkość ponad strategią – jak zauważył jeden z dyrektorów ds. prawnych w branży technologicznej. „Wczesna fala wdrożeń AI faworyzowała tempo kosztem strategii, pozostawiając wiele organizacji z niewielkimi efektami w zamian za poniesione inwestycje” – podkreśla Chief Legal Officer firmy Ivanti, wskazując, że przedsiębiorstwa dopiero teraz zaczynają dostrzegać konsekwencje tego zaniedbania. Obejmują one m.in. rozproszone, silosowe projekty AI, niespójne standardy oraz zjawisko „teatru innowacji” – mnogość pilotaży AI pozbawionych wspólnego kierunku i mierzalnej wartości biznesowej.

Co istotne, do 2026 roku brak governance AI stał się problemem na poziomie zarządów i rad nadzorczych. Dyrektorzy i inwestorzy coraz częściej pytają kadrę zarządzającą: jaką realną kontrolę macie nad AI w organizacji? Także regulatorzy oczekują istnienia formalnych struktur zarządzania ryzykiem i nadzoru nad AI. W Stanach Zjednoczonych Komitet Doradczy Inwestorów przy SEC wezwał wręcz do rozszerzenia ujawnień dotyczących tego, w jaki sposób zarządy nadzorują governance AI w kontekście zarządzania ryzykiem cyberbezpieczeństwa. Oznacza to, że firmy mogą wkrótce zostać zobowiązane do raportowania zasad zarządzania AI w podobny sposób, jak dziś raportują kontrole finansowe czy praktyki ochrony danych.

Luka w governance z ostatnich lat sprawiła, że wiele organizacji musi dziś nadrabiać zaległości. W 2026 roku zespoły audytu i compliance gorączkowo inwentaryzują wszystkie wykorzystywane systemy AI, wdrażają ścieżki audytowe oraz egzekwują polityki (np. obowiązek ludzkiej weryfikacji wyników AI w decyzjach o wysokiej wadze). Ramy Responsible AI, które w latach 2023-2024 funkcjonowały głównie na poziomie deklaracji, w 2026 roku mają szansę wreszcie stać się operacyjne. Jak prognozuje PwC, „rok 2026 może okazać się momentem, w którym firmy przezwyciężą to wyzwanie i wdrożą powtarzalne, rygorystyczne praktyki Responsible AI (RAI)”. Można spodziewać się upowszechnienia nowych mechanizmów governance – od rejestrów i dokumentacji modeli AI, przez wewnętrzne komitety etyki AI, aż po narzędzia do automatycznego wykrywania i monitorowania uprzedzeń. Organizacje, które zamkną tę lukę w nadzorze, nie tylko unikną kosztownych błędów, lecz także zyskają solidne podstawy do bezpiecznego i skalowalnego wykorzystania AI w przyszłości.

5. Szybkość kontra gotowość: pogłębiająca się luka wdrożeniowa

Jednym z najbardziej widocznych problemów boomu na AI była rosnąca rozbieżność między tempem wdrożeń a faktyczną gotowością organizacji do zarządzania ich konsekwencjami. Wiele firm przeskoczyło od zera do AI w zawrotnym tempie, jednak ich ludzie, procesy i strategie nie nadążały za tą zmianą. Powstał w ten sposób paradoks efektywności: AI była wszędzie, a mimo to realna wartość biznesowa często pozostawała trudna do uchwycenia.

Pod koniec 2025 roku badania przyniosły otrzeźwiające dane – nawet 95% korporacyjnych projektów generatywnej AI nie dostarczyło mierzalnego zwrotu z inwestycji ani realnego wpływu na wynik finansowy. Innymi słowy, jedynie niewielka część inicjatyw AI faktycznie przełożyła się na istotną zmianę biznesową. Z kolei MIT Media Lab wskazał, że „95% organizacji nie widzi mierzalnych zwrotów z AI” w sektorze pracy opartej na wiedzy. Nie oznacza to, że AI nie potrafi tworzyć wartości – raczej pokazuje, że większość firm nie była przygotowana na jej skuteczne wykorzystanie w tempie, w jakim ją wdrażała.

Przyczyny tej luki między wdrożeniem a gotowością organizacyjną są wielorakie:

- Brak integracji z codziennymi procesami: Samo wdrożenie modelu AI to jedno, a przeprojektowanie procesów biznesowych tak, aby realnie z niego korzystały – to zupełnie inna kwestia. Wiele firm „wdrażało AI bez dopasowania jej do istniejących procesów i bez odpowiedniego przeszkolenia pracowników”, co prowadziło do początkowego spadku produktywności, określanego mianem paradoksu produktywności AI. Wyniki generowane przez AI wyglądały efektownie na demonstracjach, lecz pracownicy pierwszej linii często nie potrafili włączyć ich w codzienną pracę albo musieli poświęcać dodatkowy czas na weryfikację rezultatów (to, co bywa określane jako „AI slop”, czyli niskiej jakości rezultat generujący więcej pracy niż korzyści).

- Luka kompetencyjna i kulturowa: Organizacje wdrażały AI szybciej, niż rozwijały kompetencje pracowników niezbędne do korzystania z tych narzędzi i ich nadzorowania. Część zespołów obawiała się nowej technologii, inni po prostu nie byli przygotowani do efektywnej współpracy z systemami AI. Jak zauważył analityk Gartnera Deepak Seth, „wciąż nie wiemy, jak zbudować strukturę zespołu, w której AI jest równoprawnym uczestnikiem pracy”. W wielu organizacjach brakowało dojrzałości i biegłości w obszarze AI zarówno wśród pracowników, jak i menedżerów, co skutkowało niewłaściwym użyciem lub niewykorzystaniem potencjału technologii.

- Rozproszone i niepriorytetyzowane działania: Bez jasno zdefiniowanej strategii AI część firm rozpraszała swoje wysiłki na dziesiątki równoległych eksperymentów. Jak zauważa PwC, „organizacje rozkładają swoje działania zbyt cienko, stawiając na drobne, niespójne zakłady… a wczesne sukcesy potrafią maskować głębsze problemy”. Gdy projekty AI wyrastały w różnych częściach organizacji (często oddolnie, z inicjatywy entuzjastycznych pracowników), kierownictwu trudno było skalować te naprawdę istotne. Brak strategii narzuconej odgórnie sprawiał, że wiele inicjatyw AI nigdy nie przełożyło się na realny wpływ w skali całego przedsiębiorstwa.

Efektem tych zjawisk było to, że do 2025 roku wiele firm miało niewiele do pokazania mimo intensywnej aktywności wokół AI. Jak ujęła to Brooke Johnson z Ivanti, organizacje kończyły z „niedziałającymi optymalnie narzędziami, rozproszonymi systemami i zmarnowanymi budżetami”, ponieważ działały zbyt szybko i bez planu. Ta frustracja wymusza dziś zmianę podejścia w 2026 roku: odejście od filozofii „działaj szybko i psuj” na rzecz „zwolnij i zrób to dobrze”.

Już teraz widać, że najbardziej dojrzałe organizacje korygują swoje podejście. Zamiast ścigać się w dziesiątkach przypadków użycia AI, identyfikują kilka obszarów o największym potencjale i koncentrują się na nich w sposób pogłębiony – zgodnie z podejściem „wąsko, ale głęboko”. Inwestują w zarządzanie zmianą i szkolenia, tak aby pracownicy faktycznie korzystali z dostarczonych narzędzi AI. Co istotne, kadra zarządzająca wprowadza coraz więcej dyscypliny i nadzoru nad inicjatywami AI. Jak zauważa PwC, w 2026 roku „słusznie kończy się cierpliwość dla czysto eksploracyjnych inwestycji w AI” – każda wydana złotówka musi dziś przekładać się na mierzalne efekty, a powierzchowne pilotaże są systematycznie eliminowane. Mówiąc wprost, AI musi teraz na siebie zarabiać.

Luka między wdrożeniem a gotowością zamyka się w tych firmach, które traktują AI jako transformację strategiczną, prowadzoną przez najwyższe kierownictwo, a nie jako serię technologicznych demonstracji. Organizacje tkwiące w „teatrze innowacji” przekonają się w 2026 roku, że to bolesne przebudzenie – ich projekty AI trafią pod lupę dyrektorów finansowych i zarządów pytających wprost: „jaką realną wartość to dostarcza?” Sukces w 2026 roku przypadnie tym, którzy potrafią zrównoważyć innowacyjność z przygotowaniem, powiązać inicjatywy AI z celami biznesowymi, wzmocnić je odpowiednimi procesami i kompetencjami oraz wdrażać je w tempie, które organizacja jest w stanie wchłonąć. Czasy wdrażania AI „dla samej AI” minęły – teraz liczy się trwała, zarządzana AI, na którą organizacja jest faktycznie gotowa.

6. Regulacyjne rozliczenie: nadchodzą zasady i egzekwowanie prawa wobec AI

Regulatorzy dostrzegli chaos, jaki towarzyszył masowej adopcji AI w ostatnich latach, a rok 2026 wyznacza początek znacznie bardziej zdecydowanej reakcji regulacyjnej na całym świecie. Po okresie debat legislacyjnych w latach 2023-2024 rządy przechodzą dziś od ogólnych wytycznych do realnego egzekwowania przepisów dotyczących AI. Firmy, które zlekceważyły governance AI, mogą stanąć w obliczu konsekwencji prawnych i finansowych, jeśli nie dostosują się wystarczająco szybko.

W Unii Europejskiej przełomowa regulacja – EU AI Act – jest wdrażana etapami. Przyjęte pod koniec 2023 roku kompleksowe rozporządzenie wprowadza obowiązki zależne od poziomu ryzyka danego systemu AI. Co istotne, do 2 sierpnia 2026 roku firmy wdrażające AI na terenie UE muszą spełnić szczegółowe wymogi transparentności i kontroli dla tzw. „systemów AI wysokiego ryzyka”. Brak zgodności nie wchodzi w grę, jeśli ktoś nie liczy się z poważnymi karami – sankcje mogą sięgać 35 mln euro lub 7% globalnego rocznego obrotu (w zależności od tego, która kwota jest wyższa) w przypadku najpoważniejszych naruszeń. To jednoznaczny sygnał, że w UE era dobrowolnej samoregulacji dobiegła końca. Organizacje będą musiały dokumentować swoje systemy AI, przeprowadzać oceny ryzyka oraz zapewnić nadzór człowieka nad zastosowaniami wysokiego ryzyka (np. w ochronie zdrowia, finansach, HR), w przeciwnym razie narażą się na zdecydowane działania egzekucyjne.

Unijni regulatorzy już zaczęli demonstrować swoją determinację. Pierwszy pakiet przepisów AI Act zaczął obowiązywać w 2025 roku, a w państwach członkowskich wyznaczani są organy odpowiedzialne za nadzór nad zgodnością. Komisja Europejska publikuje wytyczne dotyczące praktycznego stosowania nowych regulacji. Równolegle obserwujemy inicjatywy uzupełniające, takie jak włoska ustawa o AI (spójna z EU AI Act) czy wdrażany kodeks postępowania dotyczący transparentności treści generowanych przez AI. Wszystko to oznacza, że do 2026 roku firmy działające w Europie muszą mieć swoje AI „uporządkowane” – prowadzić ścieżki audytowe, rejestrować wybrane systemy AI w unijnej bazie, informować użytkowników o wykorzystaniu AI w generowanych treściach i nie tylko – albo liczyć się z postępowaniami i karami finansowymi.

Ameryka Północna nie pozostaje daleko w tyle. Choć na początku 2026 roku Stany Zjednoczone nie posiadają jeszcze jednolitej, federalnej ustawy regulującej AI, tempo regulacji i egzekwowania przepisów na poziomie stanowym wyraźnie rośnie. Przykładowo ustawa AI Act w stanie Kolorado (uchwalona w 2024 roku) zacznie obowiązywać w czerwcu 2026 roku, nakładając na twórców i użytkowników AI obowiązek zapobiegania dyskryminacji algorytmicznej, wdrażania programów zarządzania ryzykiem oraz przeprowadzania ocen wpływu dla systemów AI uczestniczących w istotnych procesach decyzyjnych. Kilka innych stanów (m.in. Kalifornia, Nowy Jork, Illinois) wprowadziło regulacje koncentrujące się na konkretnych obszarach, takich jak algorytmy rekrutacyjne czy systemy AI podszywające się pod ludzi. Ta mozaika przepisów oznacza, że firmy działające w USA muszą niezwykle ostrożnie poruszać się po krajobrazie compliance, w przeciwnym razie mogą narazić się na działania prokuratorów generalnych poszczególnych stanów.

Co więcej, rok 2025 przyniósł już pierwsze realne przykłady egzekwowania przepisów dotyczących AI w USA. W maju 2025 roku prokurator generalny Pensylwanii zawarł ugodę z firmą zarządzającą nieruchomościami po tym, jak wykorzystywane przez nią narzędzie AI do podejmowania decyzji najmu doprowadziło do niebezpiecznych warunków mieszkaniowych i naruszeń prawa. Z kolei w lipcu 2025 roku prokurator generalny stanu Massachusetts nałożył karę w wysokości 2,5 mln dolarów na firmę obsługującą kredyty studenckie w związku z zarzutami, że jej system oparty na AI w sposób nieuczciwy opóźniał lub niewłaściwie obsługiwał programy ulgowe. To najpewniej dopiero wierzchołek góry lodowej – regulatorzy wyraźnie sygnalizują, że firmy będą pociągane do odpowiedzialności za szkodliwe skutki działania AI, również w oparciu o już obowiązujące przepisy o ochronie konsumentów czy przeciwdziałaniu dyskryminacji. Amerykańska Federalna Komisja Handlu (FTC) zapowiedziała także zdecydowane działania wobec wprowadzających w błąd praktyk związanych z AI i niewłaściwego wykorzystania danych, wszczynając postępowania dotyczące m.in. szkód powodowanych przez chatboty oraz bezpieczeństwa dzieci w aplikacjach opartych na AI.

Po drugiej stronie Atlantyku również Wielka Brytania przechodzi od zasad ogólnych do wiążących regulacji. Po początkowym podejściu opartym na minimalnej ingerencji i wspieraniu innowacji rząd brytyjski zasygnalizował w 2025 roku, że regulatorzy sektorowi otrzymają wyraźne uprawnienia do egzekwowania wymogów dotyczących AI w obszarach takich jak ochrona danych, konkurencja czy bezpieczeństwo. Do 2026 roku można spodziewać się wprowadzenia bardziej konkretnych obowiązków compliance, choć prawdopodobnie mniej szczegółowych niż w modelu unijnym.

Dla liderów biznesu przekaz jest jednoznaczny: krajobraz regulacyjny wokół AI szybko się krystalizuje w 2026 roku. Zgodność AI z przepisami musi być traktowana z taką samą powagą jak ochrona danych osobowych (GDPR) czy raportowanie finansowe. Oznacza to m.in. konieczność przeprowadzania ocen wpływu AI, zapewnienia transparentności (np. informowania użytkowników o wykorzystaniu AI), prowadzenia dokumentacji i logów audytowych decyzji podejmowanych przez systemy AI oraz wdrażania procedur obsługi incydentów i błędów związanych z AI. Firmy, które zlekceważą te obowiązki, mogą stać się przykładem dla regulatorów – a kary finansowe lub odszkodowania prawne sprawią, że realnie „zapłacą” za zbyt luźne praktyki z poprzednich lat.

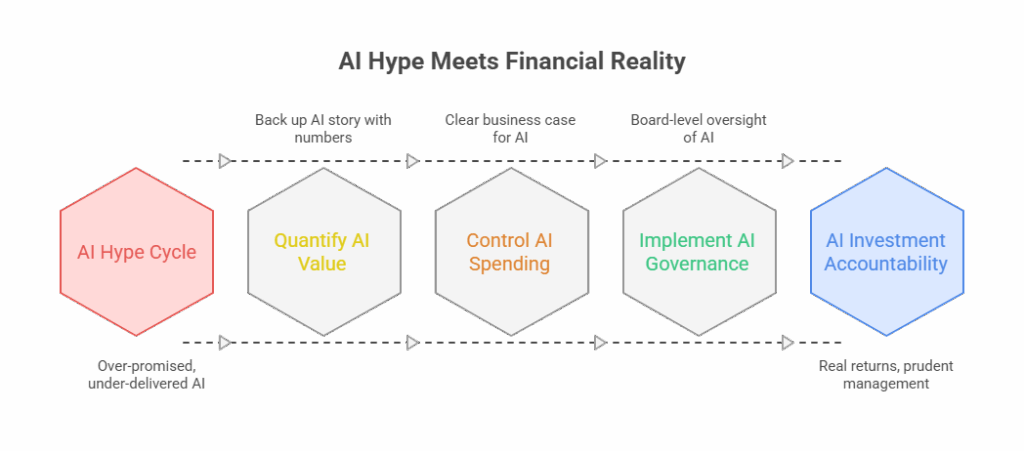

7. Odpór inwestorów: żądanie ROI i realnej odpowiedzialności

To nie tylko regulatorzy – inwestorzy i akcjonariusze również stracili cierpliwość do hype’u wokół AI. Do 2026 roku zarówno rynek giełdowy, jak i fundusze venture capital oczekują namacalnych zwrotów z inwestycji w AI i zaczynają karać firmy, które zbyt wiele obiecywały, a zbyt mało dowiozły.

W 2025 roku AI była gwiazdą Wall Street – spółki technologiczne silnie związane z AI notowały dynamiczne wzrosty, a niemal każda rozmowa wynikowa zawierała wątek sztucznej inteligencji. Jednak wraz z początkiem 2026 roku analitycy otwarcie pytają firmy oparte na AI: „pokażcie pieniądze”. Jeden z raportów trafnie oddał nastroje, posługując się metaforą randkową: „w 2025 roku AI zabrała inwestorów na bardzo udaną pierwszą randkę. W 2026… czas zacząć płacić rachunek”. Okres taryfy ulgowej dla spekulacyjnych wydatków na AI dobiega końca, a inwestorzy oczekują wyraźnego ROI lub oszczędności kosztowych możliwych do przypisania inicjatywom AI. Firmy, które nie potrafią skwantyfikować wartości, mogą liczyć się z obniżką wycen.

Już teraz widać, jak rynek zaczyna wyraźnie oddzielać zwycięzców AI od przegranych. Tom Essaye z Sevens Report zauważył pod koniec 2025 roku, że wcześniejszy „jednolity entuzjazm” wobec wszystkiego, co związane z AI, stał się „rozbity i selektywny”. Jak ujął to wprost, „branża wchodzi w okres, w którym rynek agresywnie sortuje zwycięzców i przegranych”. Przykładowo niektórzy producenci chipów i dostawcy chmury, którzy bezpośrednio korzystają na obciążeniach AI, notowali dynamiczne wzrosty, podczas gdy część dawnych „ulubieńców” rynku oprogramowania – firm, które jedynie marketingowo pozycjonowały się jako liderzy AI – zaczęła tracić na wartości, gdy inwestorzy zażądali dowodów realnego wzrostu napędzanego przez AI. Nawet duże firmy z segmentu enterprise software, takie jak Oracle, które jechały na fali hype’u, spotkały się z większą presją, gdy inwestorzy zaczęli domagać się natychmiastowego ROI z działań AI. To wyraźna zmiana w porównaniu z 2023 rokiem, kiedy samo wspomnienie o „strategii AI” potrafiło podbić kurs akcji. Dziś firmy muszą poprzeć narrację o AI twardymi liczbami – wzrostem przychodów, poprawą marż lub nowymi klientami pozyskanymi dzięki AI.

Akcjonariusze coraz mocniej naciskają także na kosztową stronę AI. Trenowanie dużych modeli oraz ich utrzymanie w skali produkcyjnej jest niezwykle drogie – wystarczy wspomnieć o rosnących rachunkach za chmurę i inwestycjach w GPU. W trudniejszym otoczeniu makroekonomicznym 2026 roku zarządy i inwestorzy nie będą tolerować nieograniczonych wydatków na AI bez jasnego uzasadnienia biznesowego. Można spodziewać się większego aktywizmu inwestorskiego lub ostrych pytań na walnych zgromadzeniach, w stylu: „wydaliście w zeszłym roku 100 mln dolarów na AI – co konkretnie z tego mamy?”. Jeśli odpowiedź będzie niejednoznaczna, należy liczyć się z reakcją rynku. Z drugiej strony firmy, które potrafią jasno przedstawić i dowieźć realny zwrot z AI, zyskają zaufanie inwestorów.

Kolejnym obszarem zainteresowania inwestorów jest ład korporacyjny wokół AI, o którym była mowa wcześniej. Doświadczeni inwestorzy obawiają się, że organizacje pozbawione solidnego governance AI mogą narazić się na kryzysy reputacyjne lub prawne, bezpośrednio uderzające w wartość dla akcjonariuszy. To dlatego SEC oraz sami inwestorzy coraz głośniej domagają się nadzoru nad AI na poziomie zarządów. Niewykluczone, że już w 2026 roku część inwestorów instytucjonalnych zacznie oczekiwać od spółek niezależnych audytów systemów AI lub publikacji raportów ryzyka AI, analogicznych do raportów ESG czy zrównoważonego rozwoju. Przekaz ze strony rynku kapitałowego jest jasny: wierzymy, że AI może być transformacyjna, ale przeżyliśmy już niejeden cykl hype’u – oczekujemy rozsądnego zarządzania i realnych zwrotów, a nie technologicznego optymizmu bez pokrycia.

Podsumowując, rok 2026 to moment, w którym hype wokół AI zderza się z finansową rzeczywistością. Firmy albo zaczną realnie zbierać owoce inwestycji w AI, albo poniosą dotkliwe konsekwencje. Organizacje, które traktowały ostatnie lata jako kosztowną lekcję, muszą teraz zdecydować, czy potrafią ją przekuć w wartość, czy też będą zmuszone spisać część projektów na straty. Dla niektórych oznaczać to będzie korekty wycen giełdowych lub trudności w pozyskiwaniu kapitału, jeśli nie pokażą wiarygodnej drogi do rentowności dzięki AI. Dla innych, dysponujących spójną i dojrzałą strategią, 2026 rok może być momentem, w którym AI faktycznie zacznie poprawiać wyniki finansowe i uzasadni wcześniejsze inwestycje. Jak celnie skomentował jeden z autorów na LinkedInie, „2026 nie będzie definiowany przez hype. Będzie definiowany przez odpowiedzialność – zwłaszcza w kontekście kosztów i zwrotu z inwestycji.”

8. Studia przypadków: zwycięzcy i przegrani dojrzałości AI

Przykłady z rynku pokazują, jak firmy radzą sobie w momencie, gdy eksperymentalna fala AI zaczyna opadać. Część organizacji wyrasta dziś na zwycięzców dojrzałości AI – wcześnie zainwestowały w governance i spójność wdrożeń, dzięki czemu zaczynają osiągać wymierne korzyści. Inne wciąż się zmagają lub wyciągają bolesne wnioski, wycofując się z pośpiesznych wdrożeń AI, które nie przyniosły oczekiwanych rezultatów.

Po stronie organizacji mających problemy uwagę zwracają historie firm, które rzuciły się w AI bez odpowiednich zabezpieczeń. Wspomniany wcześniej przypadek Samsunga jest tu dobrym przykładem. Chcąc szybko zwiększyć produktywność programistów, dział półprzewodników Samsunga dopuścił korzystanie z ChatGPT – a w ciągu kilku tygodni wewnętrzny kod źródłowy oraz wrażliwe plany biznesowe trafiły nieumyślnie do publicznego chatbota. Reakcja była natychmiastowa: firma wprowadziła całkowity zakaz korzystania z zewnętrznych narzędzi AI do czasu wdrożenia odpowiednich mechanizmów ochrony danych. Ten przypadek pokazuje, że nawet technologicznie zaawansowane organizacje mogą potknąć się bez jasnych polityk wewnętrznych dotyczących AI. Wiele innych firm w latach 2023-2024 przeżyło podobne „zimne prysznice” (przykładowo banki takie jak JPMorgan czasowo zakazywały używania ChatGPT), uświadamiając sobie dopiero po wycieku danych lub kompromitujących wynikach, że konieczne jest egzekwowanie zasad korzystania z AI oraz prowadzenie logów. Koszt takich sytuacji ma głównie charakter reputacyjny i operacyjny – obiecujące inicjatywy AI musiały zostać wstrzymane, co oznaczało utratę czasu i impetu.

Innym przykładem „przegranych” są firmy z branży mediów i contentu, które zbyt szybko sięgnęły po AI. Na początku 2023 roku kilku wydawców cyfrowych (m.in. BuzzFeed czy CNET) eksperymentowało z artykułami pisanymi przez AI, licząc na redukcję kosztów. Szybko okazało się to błędem, gdy czytelnicy i eksperci wykryli błędy merytoryczne oraz przypadki plagiatu w treściach generowanych przez AI, co doprowadziło do publicznej krytyki i korekt. CNET, dla przykładu, musiał po cichu wstrzymać swój program tworzenia treści z użyciem AI po ujawnieniu poważnych nieścisłości, co podważyło zaufanie odbiorców. Te przypadki jasno pokazują, że wypychanie AI do kanałów kontaktu z klientem bez rygorystycznej kontroli jakości może poważnie zaszkodzić marce i nadwyrężyć zaufanie – to lekcja, którą rynek odrobił w bolesny sposób.

Z drugiej strony niektóre firmy bardzo sprawnie przeszły przez boom AI i dziś zbierają owoce:

- Ernst & Young (EY), globalna firma doradczo-podatkowa, jest przykładem skalowalnej AI wdrażanej z myślą o governance. EY wcześnie powołała „AI Center of Excellence” oraz wprowadziła polityki odpowiedzialnego korzystania z AI. Efekt? Do 2025 roku firma miała wewnętrznie udokumentowanych 30 mln procesów wspieranych przez AI oraz 41 tys. „agentów AI” działających produkcyjnie. Jednym z nich jest doradca podatkowy oparty na AI, dostarczający pracownikom i klientom aktualne informacje o przepisach podatkowych – co ma ogromną wartość w obszarze, w którym każdego dnia pojawia się ponad 100 zmian regulacyjnych. Dzięki połączeniu wdrożeń AI z intensywnymi szkoleniami (reskilling tysięcy pracowników) oraz mechanizmami kontroli (każda rekomendacja podatkowa AI wymaga zatwierdzenia przez człowieka), EY osiągnęła wzrost efektywności bez utraty jakości. Kierownictwo firmy podkreśla, że narzędzia te znacząco zwiększyły produktywność w obszarach back-office i zarządzania wiedzą, dając EY realną przewagę konkurencyjną. Ten sukces nie był przypadkiem – wynikał z potraktowania AI jako priorytetu strategicznego i inwestycji w gotowość całej organizacji.

- DXC Technology, firma świadcząca usługi IT, oferuje kolejny przykład sukcesu dzięki podejściu skoncentrowanemu na człowieku. DXC wdrożyła AI jako „copilota” dla analityków cyberbezpieczeństwa. W ich centrum operacji bezpieczeństwa AI pełni rolę młodszego analityka, obsługując rutynowe zadania pierwszej linii (np. klasyfikowanie alertów i dokumentowanie ustaleń). Efekty są imponujące: DXC skróciła czas analiz o 67,5% i uwolniła 224 tys. godzin pracy analityków w ciągu roku. Dzięki temu ludzie mogą koncentrować się na zadaniach o wyższej wartości, takich jak zaawansowane polowanie na zagrożenia, podczas gdy powtarzalne czynności są automatyzowane. Firma przypisuje ten sukces projektowaniu AI jako uzupełnienia pracy człowieka (a nie jego zastępstwa) oraz przypisaniu pracownikom odpowiedzialności za „wyłapywanie i korygowanie błędów AI”. Agent AI działa w ściśle monitorowanym środowisku, z jasnymi zasadami eskalacji do człowieka. Przypadki DXC i EY pokazują, że AI wdrażana z jasno określonym celem, zabezpieczeniami i zaangażowaniem pracowników może przynieść wysoki ROI i realnie ograniczyć ryzyka.

- W sektorze finansowym Morgan Stanley zyskał uznanie dzięki ostrożnej, a jednocześnie ambitnej integracji AI. Bank nawiązał współpracę z OpenAI, tworząc wewnętrznego asystenta opartego na GPT-4, który pomaga doradcom finansowym przeszukiwać raporty i wewnętrzne bazy wiedzy. Zamiast działać w pośpiechu, Morgan Stanley poświęcił kilka miesięcy na dopracowanie modelu na danych własnych oraz wdrożenie mechanizmów zgodności. Rezultatem było narzędzie na tyle skuteczne, że w ciągu kilku miesięcy od uruchomienia 98% zespołów doradców korzystało z niego codziennie, znacząco zwiększając efektywność obsługi zapytań klientów. Wczesne raporty sugerowały, że firma spodziewała się ponad 1 mld dolarów ROI z AI w pierwszym roku. Kurs akcji Morgan Stanley również zyskał, gdy rynek uznał, że bank znalazł skuteczny model tworzenia wartości z AI w skali organizacji. Ich podejście – skoncentrowanie się na konkretnym przypadku użycia (wyszukiwanie wiedzy), dbałość o jakość danych i uprawnienia oraz systematyczny pomiar efektów – staje się dziś wzorcem dla innych instytucji finansowych.

Te przykłady prowadzą do szerszego wniosku: „zwycięzcami” 2026 roku są organizacje, które traktują AI jako długofalową zdolność do zbudowania i zarządzania, a nie jako szybki trik czy marketingowy gadżet. Zainwestowały one w governance, rozwój kompetencji pracowników oraz powiązanie AI ze strategią biznesową. „Przegrani” natomiast rzucali się na AI w pogoni za krótkoterminowym efektem lub rozgłosem, by szybko zderzyć się z problemami – od kompromitujących wycofań wadliwych systemów po niezadowolenie klientów i zainteresowanie regulatorów.

W miarę jak rok 2026 nabiera tempa, ta polaryzacja będzie się pogłębiać. Część firm po cichu ograniczy projekty AI, które nie przynoszą efektów, de facto spisując na straty koszty eksperymentów z lat 2023-2025. Inne zdecydują się na podwojenie wysiłków, ale już z zupełnie inną dojrzałością – powołując komitety sterujące AI, zatrudniając Dyrektorów ds. AI lub osoby o podobnym zakresie odpowiedzialności oraz wymagając, by każdy projekt AI miał jasno zdefiniowane mierniki sukcesu. Ten etap wyraźnie oddzieli liderów od maruderów w obszarze dojrzałości AI. I jak sugeruje tytuł artykułu, ci, którzy budowali narrację wyłącznie na hype’ie, „zapłacą” – kosztami porządkowania chaosu lub utraconymi szansami – podczas gdy organizacje łączące innowacyjność z odpowiedzialnością będą się rozwijać.

9. Podsumowanie: 2026 i dalej – odpowiedzialność, dojrzałość i zrównoważona AI

Rok 2026 otwiera nowy rozdział w historii AI w biznesie – rozdział, w którym odpowiedzialność i realizm wygrywają z hype’em i niekontrolowanymi eksperymentami. Okres taryfy ulgowej dobiegł końca: firmy nie mogą już „rzucać AI” na problemy bez ponoszenia konsekwencji. Eksperymenty z lat 2023-2025 dostarczyły wielu lekcji, a rachunek za błędy i zaniedbania właśnie jest wystawiany.

Kto zapłaci za te wcześniejsze eksperymenty? W wielu przypadkach zapłacą same organizacje – inwestując dziś znaczące środki w wzmocnienie bezpieczeństwa, doposażenie governance oraz dopracowanie modeli AI wdrożonych w pośpiechu. Inne zapłacą w bardziej dotkliwy sposób – poprzez kary regulacyjne, odpowiedzialność prawną lub utratę udziałów rynkowych na rzecz bardziej zdyscyplinowanych konkurentów. Liderzy, którzy forsowali efektowne, lecz płytkie inicjatywy AI, zostaną rozliczeni z ROI. Zarządy będą zadawać trudniejsze pytania. Regulatorzy zażądają dowodów kontroli ryzyka. Inwestorzy będą finansować wyłącznie te inicjatywy AI, które wykazują realną wartość lub przynajmniej wiarygodną ścieżkę do jej osiągnięcia.

Jednocześnie 2026 rok to nie tylko rozliczenie, ale także moment dojrzewania AI. To czas, w którym technologia ta może udowodnić swoją wartość w realnych warunkach biznesowych. Gdy hype opada, prawdziwie wartościowe zastosowania AI zaczynają się wyraźnie wyróżniać. Organizacje, które mądrze inwestowały w AI i świadomie zarządzały ryzykiem, mogą zacząć korzystać z efektu skali – od usprawnionych operacji po nowe źródła przychodów. Niewykluczone, że z perspektywy czasu uznamy 2026 rok za moment przejścia AI z „szczytu wygórowanych oczekiwań” na „plateau produktywności”, używając terminologii cyklu hype’u Gartnera.

Dla liderów biznesu przekaz jest jasny: do AI trzeba podchodzić z otwartymi oczami. Warto ją wdrażać – wszystko wskazuje na to, że długofalowo spełni swoje transformacyjne obietnice – ale w ramach jasno określonej odpowiedzialności. Oznacza to wdrożenie solidnego governance AI, inwestycje w kompetencje pracowników i zarządzanie zmianą, systematyczne monitorowanie efektów oraz powiązanie każdego projektu AI z celami i ograniczeniami strategicznymi organizacji. Oznacza to także gotowość, by zatrzymać lub wycofać wdrożenie AI, jeśli generuje nadmierne ryzyko lub nie dostarcza wartości – niezależnie od tego, jak atrakcyjnie wygląda technologia.

Rozliczenie roku 2026 jest w gruncie rzeczy zjawiskiem zdrowym. Oznacza przejście od ery „działaj szybko i psuj” do epoki „działaj mądrze i buduj rozwiązania, które przetrwają”. Organizacje, które wewnętrznie zaakceptują tę zmianę, nie tylko unikną kosztownych błędów z przeszłości, ale także ustawią się w pozycji umożliwiającej zrównoważone wykorzystanie pełnego potencjału AI – jako zaufanego silnika innowacji i efektywności, działającego w jasno określonych ramach. Te, które się nie dostosują, mogą zapłacić cenę na wielu poziomach.

Patrząc poza rok 2026, można mieć nadzieję, że doświadczenia pierwszej połowy dekady doprowadzą do nowej równowagi: w której ogromny potencjał AI będzie realizowany jednocześnie z odwagą i odpowiedzialnością. Rok prawdy spełni swoją rolę, jeśli pozostawi świat biznesu z trzeźwym optymizmem – podekscytowanym możliwościami AI, ale świadomym tego, co naprawdę oznacza jej właściwe wdrożenie.

10. Od rozliczenia AI do odpowiedzialnej egzekucji

Dla organizacji wchodzących w nową fazę odpowiedzialności za AI kluczowym wyzwaniem nie jest już pytanie, czy korzystać z AI, lecz jak robić to w sposób odpowiedzialny, bezpieczny i skalowalny. Przekształcenie AI z eksperymentu w trwałą zdolność biznesową wymaga czegoś więcej niż samych narzędzi – wymaga governance, integracji oraz doświadczenia we wdrożeniach produkcyjnych.

W tym obszarze TTMS wspiera liderów biznesu. Dzięki swoim rozwiązaniom AI dla biznesu TTMS pomaga organizacjom przejść od pilotaży i wdrożeń napędzanych hype’em do dojrzałych, gotowych do produkcji systemów AI klasy enterprise. Kluczowe jest tu dopasowanie AI do procesów biznesowych, redukcja długu technicznego i bezpieczeństwa, wbudowanie compliance i governance już na etapie projektowania oraz zapewnienie, że inwestycje w AI przekładają się na mierzalne efekty. W roku zdominowanym przez odpowiedzialność to właśnie jakość egzekucji decyduje o tym, kto zostaje liderem AI, a kto jej ofiarą.

👉 https://ttms.com/ai-solutions-for-business/

FAQ

Dlaczego 2026 rok nazywany jest „rokiem prawdy” dla AI w biznesie?

Ponieważ po kilku latach intensywnych eksperymentów i hype’u organizacje wchodzą w fazę realnego rozliczenia. W latach 2023–2025 łatwo było uruchamiać pilotaże, kupować licencje i ogłaszać „inicjatywy AI” bez konieczności wykazywania trwałego efektu biznesowego lub panowania nad ryzykiem. W 2026 roku zmienia się perspektywa – zarządy, inwestorzy i regulatorzy oczekują dowodów: mierzalnych wyników, jasno przypisanej odpowiedzialności oraz kontroli nad wpływem AI na organizację. „Rok prawdy” oznacza, że firmy są oceniane nie po tym, czy używają AI, lecz po tym, czy robią to świadomie, bezpiecznie i z realnym zwrotem z inwestycji.

Co oznacza stwierdzenie, że AI przestaje być przewagą konkurencyjną?

Oznacza to, że dostęp do AI stał się powszechny i sam fakt jej wykorzystywania nie wyróżnia już firmy na tle konkurencji. Przewagę buduje dziś nie technologia sama w sobie, lecz sposób jej wdrożenia: integracja z procesami, jakość danych, governance oraz zdolność organizacji do przełożenia wyników AI na decyzje biznesowe. Dwie firmy mogą korzystać z tych samych narzędzi, a mimo to osiągać zupełnie inne rezultaty. Różnicę robi dojrzałość operacyjna, kompetencje zespołów oraz to, czy AI jest traktowana jako element strategii, a nie jako zbiór pojedynczych eksperymentów.

Dlaczego szybka adopcja GenAI może zwiększać ryzyko bezpieczeństwa zamiast je ograniczać?

Generatywna AI znacząco przyspiesza wytwarzanie kodu i automatyzację procesów, ale jednocześnie przyspiesza powstawanie błędów. Gdy tempo wdrożeń rośnie szybciej niż zdolność organizacji do testowania, przeglądu i zabezpieczania rozwiązań, pojawiają się podatności, błędne konfiguracje i luki bezpieczeństwa. Dodatkowym problemem jest niekontrolowane użycie narzędzi AI przez pracowników, które może prowadzić do wycieków danych lub naruszeń zgodności. W efekcie powstaje tzw. dług bezpieczeństwa – nagromadzone ryzyko, którego usunięcie w przyszłości jest znacznie droższe niż zapobieganie mu na etapie wdrożeń.

Jakie wskaźniki powinny dziś mierzyć zarządy, aby ocenić, czy AI faktycznie działa?

Kluczowe jest odejście od mierzenia aktywności na rzecz mierzenia efektów. W zależności od zastosowania mogą to być skrócenie czasu realizacji procesów, spadek liczby błędów, redukcja kosztów, wzrost satysfakcji klientów lub poprawa stabilności systemów. W obszarze IT warto zestawiać tempo wdrożeń z wskaźnikami jakości, takimi jak liczba incydentów czy czas ich usuwania. Istotne są również wskaźniki adopcji – czy pracownicy faktycznie korzystają z narzędzi AI, kiedy je omijają i dlaczego. Coraz ważniejsze stają się też miary związane z governance: obecność dokumentacji, logów audytowych, jasno przypisanej odpowiedzialności oraz procedur reagowania na błędy AI.

Jak w praktyce wygląda governance AI w dużej organizacji?

Governance AI to zestaw zasad, ról i mechanizmów kontroli, które sprawiają, że wykorzystanie AI jest przewidywalne, bezpieczne i możliwe do audytu. W praktyce zaczyna się od inwentaryzacji wszystkich systemów AI oraz określenia, jakie dane przetwarzają i jakie decyzje wspierają. Obejmuje polityki korzystania z AI, klasyfikację ryzyka, obowiązek dokumentowania modeli oraz monitorowanie ich działania w czasie. Ważnym elementem jest też nadzór człowieka w decyzjach o wysokiej wadze oraz procedury reagowania na incydenty. W dojrzałych organizacjach governance AI nie jest jednorazowym dokumentem, lecz stałym modelem operacyjnym, który umożliwia bezpieczne skalowanie AI wraz z rozwojem biznesu.